|

THÉORIE

DE LA DÉMONSTRATION | NOMBRES

| OPÉRATEURS ARITHMÉTIQUES

THÉORIE DES NOMBRES | THÉORIE

DES ENSEMBLES | PROBABILITÉS

| STATISTIQUES

La mathématique est la forme ultime

d'art contraint. (inconnu)

| 1.

THÉORIE

DE LA DÉMONSTRATION |

Dernière mise à jour de ce chapitre:

2017-12-31 17:55:49 |

{oUUID 1.704}

Version: 3.1 Révision 5 | Avancement: ~80%

vues

depuis le 2012-01-01:

0 vues

depuis le 2012-01-01:

0

LISTE DES SUJETS TRAITÉS SUR CETTE PAGE

LISTE DES SUJETS TRAITÉS SUR CETTE PAGE

Nous avons choisi de commencer l'étude

de la mathématique appliquée

par la théorie qui nous semble la plus fondamentale

et la plus importante dans le domaine des sciences pures et

exactes.

La théorie de la démonstration et du calcul propositionnel

(logique) a trois objectifs dans le cadre de ce site:

1. Apprendre au lecteur comment raisonner et à démontrer

et cela indépendamment de la spécialisation étudiée.

2. Montrer que le processus d'une démonstration est

indépendant du langage utilisé.

3. Se préparer à la théorie de la logique

et au théorème d'incomplétude de Gödel

ainsi qu'aux automates (cf. chapitre

d'Informatique Théorique).

Le théorème de Gödel est le point le plus

passionnant car si nous définissons

une religion comme un système de pensée qui contient

des affirmations indémontrables, alors elle contient des éléments

de foi, et Gödel

nous enseigne que la mathématique est non seulement

une religion, mais que c'est alors la seule religion capable

de prouver qu'elle en

est une!

Remarques:

R1. Il est (très) fortement conseillé de lire

en parallèle à ce chapitre, ceux sur la théorie

des automates et de l'algèbre de Boole disponibles dans

la section d'Informatique Théorique du site.

R2. Il faut prendre cette théorie comme une curiosité

sympathique mais qui n'amène fondamentalement pas grand-chose

excepté des méthodes de travail/raisonnement.

Par ailleurs, son objectif n'est pas de démontrer que

tout est démontrable mais que toute démonstration

peut se faire sur un langage commun à partir d'un certain

nombre de règles.

Souvent, quand un étudiant arrive dans une classe supérieure,

il a surtout appris à calculer, à utiliser des algorithmes mais

relativement peu voire pas du tout à raisonner.

Pour tous les raisonnements, le support visuel est un outil

puissant, et les personnes

qui ne voient pas

qu'en traçant

telle ou telle courbe ou droite la solution apparaît ou qui ne

voient pas dans l'espace sont très pénalisées.

Lors des études secondaires, nous manipulons déjà des objets

inconnus, mais c'est surtout pour faire des calculs, et quand

nous

raisonnons sur des objets représentés par des lettres, nous pouvons

remplacer ceux-ci visuellement par un nombre réel, un vecteur,

etc. A partir d'un certain niveau, nous demandons aux personnes

de raisonner

sur des structures plus abstraites, et donc de travailler sur des

objets inconnus qui sont des éléments d'un ensemble lui-même

inconnu, par exemple les éléments d'un groupe quelconque (cf.

chapitre de Théorie Des Ensembles). Ce support

visuel n'existe alors plus.

Nous demandons ainsi souvent aux étudiants de raisonner,

de démontrer

des propriétés, mais personne ne leur a jamais

appris à raisonner

convenablement, à écrire des preuves. Si nous demandons à un étudiant

de licence ce qu'est une démonstration,

il a très probablement quelque difficulté à répondre.

Il peut dire que c'est un texte dans lequel on trouve des mots-clés

comme: "donc", "parce

que", "si", "si et seulement si", "prenons

un x tel que", "supposons que", "cherchons

une contradiction", etc. Mais il est incapable de donner

la grammaire de ces textes ni même leurs rudiments,

et d'ailleurs, ses enseignants, s'ils n'ont pas suivi de

cours, en seraient probablement

incapables aussi.

Pour comprendre cette situation, rappelons que pour parler un enfant

n'a pas besoin de connaître la grammaire. Il imite son entourage

et cela marche très bien: un enfant de six ans sait utiliser des

phrases déjà compliquées quant à la structure grammaticale sans

avoir jamais fait de grammaire. La plupart des enseignants ne connaissent

pas non plus la grammaire du raisonnement mais, chez eux, le processus

d'imitation a bien marché et ils raisonnent correctement. L'expérience

de la majorité des enseignants d'université montre que ce processus

d'imitation marche bien chez les très bons étudiants, et alors il

est suffisant, mais il marche beaucoup moins bien, voire pas du

tout, chez beaucoup d'autres.

Tant que le degré de complexité est faible (notamment

lors d'un raisonnement de type "équationnel"),

la grammaire ne sert

à rien, mais quand il augmente ou quand on ne comprend pas pourquoi

quelque chose est faux, il devient nécessaire de faire

un peu de grammaire pour pouvoir progresser. Les enseignants

et les étudiants

connaissent bien la situation suivante: dans un devoir, le correcteur

a barré toute une page d'un grand trait rouge et mis "faux"

dans la marge. Quand l'étudiant demande ce qui est faux,

le correcteur ne peut que dire des choses du genre "ça

n'a aucun rapport avec la démonstration demandée", "rien

n'est juste",

..., ce qui n'aide évidemment pas l'étudiant à comprendre.

Cela vient en partie, du fait que le texte rédigé par

l'étudiant utilise les

mots voulus mais dans un ordre plus ou moins aléatoire

et qu'on ne peut donner de sens à l'assemblage de ces mots.

De plus, l'enseignant n'a pas les outils nécessaires

pour pouvoir expliquer ce qui ne va pas. Il faut donc les lui

donner!

Ces outils existent mais sont assez récents. La théorie

de la démonstration est une branche de la logique mathématique

dont l'origine est la crise des fondements: il y a eu un doute

sur

ce que nous

avions le "droit" de faire dans un raisonnement

mathématique (voir la "crise des fondements" plus

loin). Des paradoxes sont apparus, et il a alors été nécessaire

de préciser les

règles de démonstration et de vérifier que

ces règles ne sont pas

contradictoires. Cette théorie est apparue au début

du 20ème siècle,

ce qui est très peu puisque l'essentiel des mathématiques

enseignées

en première moitié de l'université est connu

depuis le 16ème-17ème siècle.

LA CRISE DES FONDEMENTS

Pour les premiers Grecs, la géométrie était

considérée comme la forme la plus haute du savoir,

une puissante clé pour les mystères métaphysiques

de l'Univers. Elle était plutôt une croyance

mystique, et le lien entre le mysticisme et la religion était

rendu explicite dans des cultes comme ceux des Pythagoriciens.

Aucune

culture n'a depuis déifié un homme pour avoir

découvert un théorème géométrique!

Plus tard, la mathématique fut considérée

comme le modèle d'une connaissance a priori dans

la tradition aristotélicienne du rationalisme.

L'étonnement des Grecs pour la mathématique

ne nous a pas quittés, on le retrouve sous la traditionnelle

métaphore des mathématiques comme "Reine

des Science". Il s'est renforcé avec les

succès

spectaculaires des modèles mathématiques dans la

science, succès que les Grecs (ignorant même la

simple algèbre)

n'avaient pas prévus. Depuis la découverte

par Isaac Newton du calcul intégral et de la loi du carré

inverse de la gravité, à la fin des années

1600, les sciences phénoménales et les plus hautes

mathématiques étaient restées en étroite

symbiose - au point qu'un formalisme mathématique

prédictif

était devenu le signe distinctif d'une "science

dure".

Après Newton, pendant les deux siècles qui suivirent,

la science aspira à ce genre de rigueur et de pureté

qui semblaient inhérentes aux mathématiques. La

question métaphysique semblait simple: la mathématique

possédait

une connaissance a priori parfaite, et parmi les sciences, celles

qui étaient capables de se mathématiser le plus

parfaitement

étaient les plus efficaces pour la prédiction des

phénomènes. La connaissance parfaite consistait

donc dans un formalisme mathématique qui, une fois atteint

par la science et embrassant tous les aspects de la réalité,

pouvait fonder une connaissance empirique a postériori

sur une logique rationnelle a priori. Ce fut dans cet esprit

que Marie Jean-Antoine

Nicolas de Caritat, marquis de Condorcet (philosophe et mathématicien

français), entreprit d'imaginer la description

de l'Univers

entier comme un ensemble d'équations différentielles

partielles se résolvant les unes après les autres.

La première faille dans cette image inspiratrice apparut

dans la seconde moitié du 19ème siècle,

quand Riemann et Lobatchevsky prouvèrent séparément

que l'axiome des parallèles d'Euclide pouvait

être remplacé par d'autres qui produisaient

des géométries "consistantes" (nous reviendrons

sur ce terme plus loin). La géométrie de Riemann

prenait modèle sur une sphère, celle de Lobatchevsky,

sur la rotation d'un hyperboloïde.

L'impact de cette découverte a été obscurci

plus tard par de grands chamboulements, mais sur le moment,

elle fit

un coup de tonnerre dans le monde intellectuel. L'existence

de systèmes axiomatiques mutuellement inconsistants,

et dont chacun pouvait servir de modèle à l'Univers

phénoménal, remettait entièrement en question

la relation entre la mathématique et la théorie

physique.

Quand on ne connaissait qu'Euclide, il n'y avait qu'une

géométrie possible. On pouvait croire que les

axiomes d'Euclide constituaient un genre de connaissance

parfaite a priori sur la géométrie dans le monde

phénoménal.

Mais soudain, nous avons eu trois géométries, embarrassantes

pour les subtilités métaphysiques.

Pourquoi aurions-nous à choisir entre les axiomes de la

géométrie plane, sphérique et hyperbolique

comme descriptions de la géométrie du réel?

Parce que toutes les trois sont consistantes, nous ne pouvons en

choisir aucune comme fondement a priori - le choix doit devenir

empirique, basé sur leur pouvoir prédictif dans une

situation donnée.

Bien sûr, les théoriciens de la physique ont longtemps

été habitués à choisir des formalismes

pour poser un problème scientifique. Mais il était

admis largement, si ce n'est inconsciemment, que la nécessité

de procéder ainsi était fonction de l'ignorance

humaine, et qu'avec de la logique ou des mathématiques

assez bonnes, on pouvait déduire le bon choix à partir

de principes premiers, et produire des descriptions a priori

de

la réalité, qui devaient être confirmées

après coup par une vérification empirique.

Cependant, la géométrie euclidienne, considérée

pendant plusieurs centaines d'années comme le modèle

de la perfection axiomatique des mathématiques, avait été détrônée.

Si l'on ne pouvait connaître a priori quelque chose

d'aussi fondamental que la géométrie dans

l'espace,

quel espoir restait-il pour une pure théorie rationnelle

qui embrasserait la totalité de la nature ? Psychologiquement,

Riemann et Lobatchevsky avaient frappé au coeur de

l'entreprise

mathématique telle qu'elle avait été

conçue jusqu'alors.

De plus, Riemann et Lobatchevsky remettaient la nature de l'intuition

mathématique en question. Il avait été facile

de croire implicitement que l'intuition mathématique

était une forme de perception - une façon d'entrevoir

le monde platonicien derrière la réalité.

Mais avec deux autres géométries qui bousculaient

celle d'Euclide, personne ne pouvait plus être sûr

de savoir à quoi le monde ressemblait.

Les mathématiciens répondirent à ce double

problème avec un excès de rigueur, en essayant

d'appliquer la méthode axiomatique à toutes la

mathématique.

Dans la période pré-axiomatique, les preuves

reposaient souvent sur des intuitions communément

admises de la "réalité"

mathématique, qui ne pouvaient plus être considérées

automatiquement comme valides.

La nouvelle façon de penser la mathématique

conduisait

à une série de succès spectaculaires. Pourtant

cela avait aussi un prix. La méthode axiomatique rendait

la connexion entre la mathématique et la réalité phénoménale

toujours plus étroite. En même temps, des découvertes

suggéraient que les axiomes mathématiques qui

semblaient

être consistants avec l'expérience phénoménale

pouvaient entraîner de vertigineuses contradictions avec

cette expérience.

La majorité des mathématiciens devinrent rapidement

des "formalistes", soutenant que la mathématique

pure ne pouvait qu'être considérées

philosophiquement comme une sorte de jeu élaboré qui

se jouait avec des signes sur le papier (c'est la théorie

qui sous-tend la prophétique qualification des mathématiques

de "système à contenu nul" par

Robert Heinlein). La croyance "platonicienne" en

la réalité

des objets mathématiques, à l'ancienne

manière, semblait bonne pour la poubelle, malgré le

fait que les mathématiciens continuaient à se

sentir comme les platoniciens durant le processus de découverte

des mathématiques.

Philosophiquement, donc, la méthode axiomatique conduisait

la plupart des mathématiciens à abandonner les

croyances antérieures en la spécificité métaphysique

des mathématiques. Elle produisit aussi la rupture contemporaine

entre la mathématique pure et appliquée.

La plupart des grands mathématiciens du début

de la période

moderne - Newton, Leibniz, Fourier, Gauss et les autres - s'occupaient

aussi de science phénoménale. La méthode

axiomatique avait couvé l'idée moderne du

mathématicien

pur comme un super esthète, insoucieux de la physique.

Ironiquement, le formalisme donnait aux purs mathématiciens

un mauvais penchant à l'attitude platonicienne.

Les chercheurs en mathématiques appliquées cessèrent

de côtoyer

les physiciens et apprirent à se mettre à leur

traîne.

Ceci nous emmène au début du 20ème siècle.

Pour la minorité assiégée des platoniciens,

le pire était encore à venir. Cantor, Frege,

Russell et Whitehead montrèrent que toute la mathématique

pure pouvait être construite sur le simple fondement

axiomatique de la théorie des ensembles. Cela convenait

parfaitement aux formalistes: la mathématique se

réunifiait,

du moins en principe, à partir d'un faisceau de

petits jeux détachés d'un grand. Les platoniciens

aussi

étaient satisfaits, s'il en survenait une

grande structure, clé de voûte consistante pour toute

la mathématique, la spécificité métaphysique

des mathématiques pouvait encore être sauvée.

D'une façon négative, pourtant, un platonicien

eut le dernier mot. Kurt Gödel mit son grain de sable dans

le programme

formaliste d'axiomatisation quand il démontra que

tout système d'axiomes assez puissant pour inclure

les entiers devait être soit inconsistant (contenir des

contradictions) soit incomplet (trop faible pour décider

de la justesse ou de la fausseté de certaines affirmations

du système).

Et c'est plus ou moins où en sont les choses aujourd'hui.

Les mathématiciens savent que de nombreuses tentatives

pour faire avancer la mathématique comme une connaissance

a priori de l'Univers doivent se heurter à de

nombreux paradoxes et à l'impossibilité de

décider

quel système axiomatique décrit la mathématique

réelle. Ils ont été réduits à

espérer que les axiomatisations standards ne soient pas

inconsistantes mais incomplètes, et à se demander

anxieusement quelles contradictions ou quels théorèmes

indémontrables

attendent d'être découverts ailleurs.

Cependant, sur le front de l'empirisme, la mathématique était

toujours un succès spectaculaire en tant

qu'outil

de construction théorique. Les grands succès de

la physique du 20ème siècle (la relativité générale

et la physique quantique) poussaient si loin hors du royaume

de

l'intuition physique, qu'ils ne pouvaient être

compris qu'en méditant profondément sur

leurs formalismes mathématiques, et en prolongeant leurs

conclusions logiques, même lorsque ces conclusions semblaient

sauvagement bizarres. Quelle ironie! Au moment même où la

perception mathématique en venait à paraître

toujours moins fiable dans la mathématique pure,

elle devenait toujours plus indispensable dans les sciences

phénoménales.

À l'opposé de cet arrière-plan, l'applicabilité

des mathématiques à la science phénoménale

pose un problème plus épineux qu'il n'apparaît

d'abord. Le rapport entre les modèles mathématiques

et la prédiction des phénomènes est complexe,

pas seulement dans la pratique mais dans le principe. D'autant

plus complexe que, comme nous le savons maintenant, il y

a des façons

d'axiomatiser la mathématique qui s'excluent!

Mais pourquoi existe-t-il seulement de bons choix de modèle

mathématique ? C'est à dire, pourquoi y a-t-il

un formalisme mathématique, par exemple pour la physique

quantique, si productif qu'il prédit réellement

la découverte de nouvelles particules observables

?

Pour répondre à cette question nous observerons

qu'elle peut, aussi bien, fonctionner comme une sorte de définition.

Pour beaucoup de systèmes phénoménaux,

de tels formalismes prédictifs exacts n'ont pas été

trouvés, et aucun ne semble plausible. Les poètes

aiment marmonner sur le coeur des hommes, mais on peut trouver

des exemples plus ordinaires: le climat, où le comportement

d'une économie supérieure à celle

d'un

village, par exemple - systèmes si chaotiquement interdépendants

que la prédiction exacte est effectivement impossible

(pas seulement dans les faits mais en principe).

PARADOXES

Dès l'antiquité, certains logiciens avaient constaté

la présence de nombreux paradoxes au sein de la rationalité.

En fait, nous pouvons dire que malgré leur nombre, ces

paradoxes ne sont que les illustrations d'un petit nombre de

structures paradoxales.

Attardons-nous à exposer à titre de culture générale

les plus connus qui constituent la classe des "propositions

indécidables".

Exemples: Exemples:

E1. Le paradoxe de la classe des classes (Russell)

Il existe deux types de classes: celles qui se contiennent

elles-mêmes

(ou classes réflexives: la classe des ensembles non-vides,

la classe des classes,...) et celles qui ne se contiennent pas

elles-mêmes

(ou classes irréflexives: la classe des travaux à

rendre, la classe des oranges sanguines, ...). La question posée

est la suivante: la classe des classes irréflexives

est-elle elle-même réflexive ou irréflexive?

Si elle est réflexive, elle se contient et se trouve

rangée

dans la classe des classes irréflexives qu'elle constitue,

ce qui est contradictoire. Si elle est irréflexive, elle

doit figurer dans la classe des classes irréflexives

qu'elle constitue et devient ipso facto réflexive,

nous sommes face

à une nouvelle contradiction.

Ce paradoxe de Russel est souvent connu principalement sous

les deux variantes suivantes:

- Est-ce que l'ensemble de tous

les ensembles qui

ne

se contiennent

eux-mêmes

se contient-il lui-même? La réponse étant: Si "Oui", alors "Non" et

si "Non" alors "Oui"...

- Ceux qui ne rasent pas eux-mêmes sont rasés par le barbier.

Donc qui rase le barbier?

La réponse est aussi indécidable... Le paradoxe de Russel remet en cause la notion d'ensemble comme

collection définie par une propriété commune!!

En un seul coup il détruit la logique (proposition indécidable)

et la théorie

des ensembles... car le concept d'ensemble de tous les ensembles

est une impossibilité. L'autoréférence est au centre de

ce problème de logique!

Ce paradoxe revient aussi à se poser la question si

une question mathématique correctement formulée

(logique) admet nécessairement

une réponse? Autrement, dit, tout énoncé mathématique

est-il prouvable... et c'est Gödel qui bien des années

après l'énoncé

du paradoxe de Russel prouva mathématiquement que la

réponse

est Non!!!!!! En d'autres termes, il y aura

toujours des questions sans réponses car tout système

(langue vivant ou outil mathématique) basé sur

lui-même est nécessairement

incomplet! C'est le fameux Théorème d'Incomplétude de Gödel!

E2. Le paradoxe du bibliothécaire (Gonseth)

Dans une bibliothèque, il existe deux types de catalogues.

Ceux qui se mentionnent eux-mêmes et ceux qui ne se mentionnent

pas. Un bibliothécaire doit dresser le catalogue de

tous les catalogues qui ne se mentionnent pas eux-mêmes.

Arrivé

au terme de son travail, notre bibliothécaire se demande

s'il convient ou non de mentionner le catalogue qu'il est précisément

en train de rédiger. A ce moment, il est frappé de

perplexité. S'il ne le mentionne pas, ce catalogue

sera un catalogue qui ne se mentionne pas et qui devra dès

lors figurer dans la liste des catalogues ne se mentionnant

pas eux-mêmes.

D'un autre côté, s'il le mentionne, ce catalogue

deviendra un catalogue qui se mentionne et qui ne doit donc

pas figurer dans

ce catalogue, puisque celui-ci est le catalogue des catalogues

qui ne se mentionnent pas.

E3. Le paradoxe du menteur (variante)

Définissons provisoirement le mensonge comme l'action de

formuler une proposition fausse. Le poète crétois

Epiménide affirme: "Tous les Crétois sont des

menteurs", soit la proposition P. Comment décider

de la valeur de vérité de P ? Si P est

vraie, comme Epiménide est Crétois, P doit

être fausse. Il faut donc que P soit fausse pour pouvoir

être vraie, ce qui est contradictoire. P est donc fausse.

Remarquons qu'on ne peut pas en déduire, comme dans le véritable

paradoxe du menteur, que P doit aussi être vraie.

Comme l'aurait fait comporendre Ludwig Wittgenstein aux logicien,

ces paradoxes montrent qu finalement les mathématiques

sont un assez bon outil pour montrer la logique mais pas pour

en parler.

Donner avec les mathématiques un existence indépendante à ses

entités algébriques est de la folie et c'est ce

qui produit des monstres comme l'ensemble de tous les ensembles...

La logique est vide et elle ne peut dire la réalité, elle se

restreindre à être juste une image de celle-ci.

RAISONNEMENT HYPOTHETICO-DEDUCTIF

Le raisonnement hypothético-déductif est, nous

le savons, la capacité qu'a l'apprenant de déduire

des conclusions à partir de pures hypothèses et

pas seulement d'une observation réelle. C'est un processus

de réflexion

qui tente de dégager une explication causale d'un phénomène

quelconque (nous y reviendrons lors de nos premiers pas en physique).

L'apprenant qui utilise ce type de raisonnement commence par

formuler une hypothèse et essaie ensuite de confirmer

ou d'infirmer son hypothèse selon le schéma synoptique

ci-dessous:

Figure: 1.1 - Diagramme synoptique du raisonnement hypothético-déductif

Figure: 1.1 - Diagramme synoptique du raisonnement hypothético-déductifLa procédure déductive consiste à tenir pour vrai, à titre provisoire,

cette proposition première que nous appelons, en logique "le

prédicat" (voir plus bas) et à en tirer toutes les conséquences

logiquement nécessaires, c'est-à-dire à en rechercher les implications.

Exemple: Exemple:

Soit la proposition P: "X est un

homme", elle implique la proposition suivante Q:

X est mortel.

L'expression  (si

c'est un homme il est nécessairement mortel) est un implication

prédicative (d'où le terme "prédicat").

Il n'y a pas dans cet exemple de cas où nous puissions énoncer P sans Q.

Cet exemple est celui d'une implication stricte, telle que nous

la trouvons dans le "syllogisme" (figure logique

du raisonnement). (si

c'est un homme il est nécessairement mortel) est un implication

prédicative (d'où le terme "prédicat").

Il n'y a pas dans cet exemple de cas où nous puissions énoncer P sans Q.

Cet exemple est celui d'une implication stricte, telle que nous

la trouvons dans le "syllogisme" (figure logique

du raisonnement).

Remarque: Des spécialistes ont montré que

le raisonnement

hypothético-déductif s'élabore progressivement

chez l'enfant,

à partir de 6-7ans, et que ce type de raisonnement n'est utilisé

systématiquement, en partant d'une fonction propositionnelle

stricte qu'à partir de 11-12 ans.

CALCUL PROPOSITIONNEL

Le "calcul propositionnel" (ou "logique

propositionnelle")

est un préliminaire absolument indispensable pour aborder

une formation en sciences, philosophie, droit, politique, économie,

etc. Ce type de calcul autorise des procédures de décisions

ou tests. Ceux-ci permettent de déterminer dans quel

cas une expression (proposition) logique est vraie et en particulier

si elle est toujours

vraie.

Définitions:

D1. Une expression toujours vraie quel que soit le contenu linguistique

des variables qui la composent est appelée une "expression

valide", une "tautologie",

ou encore une "loi de la logique propositionnelle".

D2. Une expression toujours fausse est appelée une "contradiction"

ou "antilogie".

D3. Une expression qui est parfois vraie, parfois fausse est

appelée

une "expression contingente".

D4. Nous appelons "assertion"

une expression dont nous pouvons dire sans ambiguïté

si elle est vraie ou fausse.

D5. Le "langage objet" est

le langage utilisé pour écrire les expressions

logiques.

D6. Le "métalangage"

est le langage utilisé pour parler du langage objet dans

la langue courante.

Remarques:

R1. Il existe des expressions qui ne sont effectivement pas des

assertions. Par exemple, l'énoncé: "cet énoncé

est faux", est un paradoxe qui ne peut être ni vrai,

ni faux.

R2. Soit une expression logique A. Si celle-ci est une

tautologie, nous la notons fréquemment  et si l'expression est une contradiction, nous la notons

et si l'expression est une contradiction, nous la notons  . .

R3. En mathématiques on peut chercher à démontrer

de façon générale

qu'une assertion est vraie mais pas qu'elle est fausse (le cas

échéant on donne juste un exemple).

PROPOSITIONS

Définition: En logique, une "proposition"

est une affirmation qui a un sens. Cela veut dire que nous pouvons

dire sans ambiguïté si cette affirmation est vraie (V)

ou fausse (F). C'est ce que nous appelons le "principe

du tiers exclu".

Exemple:

Exemple:

"Je mens" n'est pas une proposition. Si nous supposons

que cette affirmation est vraie, elle est une affirmation de sa

propre invalidité, donc nous devrions conclure qu'elle est fausse.

Mais si nous supposons qu'elle est fausse, alors l'auteur de cette

affirmation ne ment pas, donc il dit la vérité, aussi la proposition

serait vraie.

Définition: Une proposition en logique

binaire (où

les propositions sont soit vraies, soit fausses) n'est donc jamais

vraie et fausse à la fois. C'est que nous appelons le "principe

de non-contradiction".

Ainsi, une propriété sur l'ensemble E des

propositions est une application P de E dans

l'ensemble des "valeurs

de vérité":

(1.1)

(1.1)

Nous parlons de "sous-ensemble associé",

lorsque la proposition engendre uniquement une partie E' de

E et inversement.

Exemple:

Exemple:

Dans  ,

si P(x) s'énonce

"x est pair" , alors ,

si P(x) s'énonce

"x est pair" , alors  ce qui est bien seulement un sous-ensemble associé de E mais

de même cardinal (cf. chapitre Théorie

Des Ensembles).

ce qui est bien seulement un sous-ensemble associé de E mais

de même cardinal (cf. chapitre Théorie

Des Ensembles).

Définition: Soit P une propriété sur

l'ensemble E.

Une propriété Q sur E est une "négation"

de P si et seulement si, pour tout  : :

-  est

F si P(x) est

V est

F si P(x) est

V

-  est

V si P(x) est

F est

V si P(x) est

F

Nous pouvons rassembler ces conditions dans une table dite "table

de vérité":

Tableau: 1.1

- Table de vérité des valeurs

Table que nous pouvons aussi trouver ou donc aussi écrire sous

la forme plus explicite suivante:

Tableau: 1.2 - Table de vérité des valeurs

ou encore sous forme binaire:

Tableau: 1.3 - Table de vérité des valeurs

En

d'autres termes, P et Q ont

toujours des valeurs de vérité contraires. Nous

noterons ce genre d'énoncé "Q est une

négation de P":

(1.2)

(1.2)

où le symbole  est

le "connecteur de négation". est

le "connecteur de négation".

Remarque: Les expressions doivent être des expressions bien

formées (souvent abrégé "ebf"). Par définition,

toute variable est une expression bien formée, alors  est

une expression bien formée. Si P,Q sont des expressions

bien formées, alors  est

une expression bien formée (l'expression "je mens" n'est

pas bien formée car elle se contredit elle-même).

CONNECTEURS

Il y a d'autres types de connecteurs en logique:

Soient P et Q deux propriétés

définies

sur le même ensemble E.  (lire

"P ou Q") est une propriété sur E définie

par: (lire

"P ou Q") est une propriété sur E définie

par:

-  est

vraie si au moins l'une des propriétés P, Q est vraie est

vraie si au moins l'une des propriétés P, Q est vraie

-  est

fausse sinon est

fausse sinon

Nous pouvons créer la table de vérité du "connecteur

OU" ou "connecteur de disjonction"

: :

P |

Q |

|

V |

V |

V |

V |

F |

V |

F |

V |

V |

F |

F |

F |

Tableau: 1.4

- Table de vérité de OU

Il est facile de se convaincre que, si les parties P, Q de

E sont respectivement associées aux propriétés P, Q que  (cf.

chapitre Théorie Des Ensembles) est associé à (cf.

chapitre Théorie Des Ensembles) est associé à  . .

(1.3)

(1.3)

Le connecteur  est

associatif. Pour s'en convaincre, il suffit de faire une table

de vérité

où nous vérifions que: est

associatif. Pour s'en convaincre, il suffit de faire une table

de vérité

où nous vérifions que:

(1.4)

(1.4)

Il existe également le "connecteur

ET"

ou "connecteur de conjonction"

pour

quel que soient P, Q deux propriétés

définies

sur

E, pour

quel que soient P, Q deux propriétés

définies

sur

E,  est

une propriété sur E définie

par: est

une propriété sur E définie

par:

-  est

vraie si toutes les deux propriétés P, Q sont

vraies (le syllogisme très connu: Tous les hommes

sont mortels, Socrate est un homme donc Socrate est mortel en est un exemple

fameux). est

vraie si toutes les deux propriétés P, Q sont

vraies (le syllogisme très connu: Tous les hommes

sont mortels, Socrate est un homme donc Socrate est mortel en est un exemple

fameux).

-  est

fausse sinon est

fausse sinon

Nous pouvons créer la table de vérité du connecteur  : :

P |

Q |

|

V |

V |

V |

V |

F |

F |

F |

V |

F |

F |

F |

F |

Tableau: 1.5

- Table de vérité de ET

Il est également facile de se convaincre que, si les

parties P, Q de E sont respectivement

associées aux propriétés

P, Q que  (cf.

chapitre Théorie Des Ensembles) est associé à (cf.

chapitre Théorie Des Ensembles) est associé à  : :

(1.5)

(1.5)

Le connecteur  est

associatif. Pour s'en convaincre, il suffit aussi de faire une

table de

vérité où nous vérifions que: est

associatif. Pour s'en convaincre, il suffit aussi de faire une

table de

vérité où nous vérifions que:

(1.6)

(1.6)

Les connecteurs  sont

distributifs l'un sur l'autre. A l'aide d'une simple table de vérité,

nous prouvons que: sont

distributifs l'un sur l'autre. A l'aide d'une simple table de vérité,

nous prouvons que:

(1.7)

(1.7)

ainsi que:

(1.8)

(1.8)

Une négation de  est est

une

négation de une

négation de  est est

tel

que pour résumer: tel

que pour résumer:

(1.9)

(1.9)

A nouveau, ces propriétés peuvent se démontrer par une simple table

de vérité.

Remarque: Pour voir les détails de tous les opérateurs

logiques, le lecteur devra se rendre dans le chapitre d'Algèbre

De Boole (cf. section d'Informatique

Théorique)

où l'identité, la double négation, l'idempotence,

l'associativité, la distributivité, les relations

de De Morgan sont présentées plus formellement.

Revenons maintenant sur le "connecteur

d'implication logique" appelé aussi parfois le

"conditionnel" noté

" " "

Remarque: Dans certains ouvrages sur le calcul propositionnel,

ce connecteur est noté "  "

et dans le cadre de la théorie de la démonstration

nous lui préférons souvent le symbole "  ".

Soient P, Q deux propriétés sur E.  est

une propriété sur E définie par: est

une propriété sur E définie par:

-  est

fausse si P est vraie et Q fausse est

fausse si P est vraie et Q fausse

-  est

vraie sinon est

vraie sinon

En d'autres termes, P implique logiquement Q signifie

que Q est vraie pour toute évaluation pour laquelle

P est vraie. L'implication représente donc le "si...

alors.."

Si nous écrivons la table de vérité de

l'implication (attention

à l'avant-dernière ligne !!!):

P |

Q |

|

V |

V |

V |

V |

F |

F |

F |

V |

V |

F |

F |

V |

Tableau: 1.6

- Table de vérité de l'implication

Si  ,

nous pouvons dire que pour que Q soit vraie, il suffit

que

P soit vraie (effectivement l'implication sera vraie

si P est vraie ou fausse selon la table de vérité).

Donc P est une condition suffisante de Q (mais

non nécessaire!). D'un autre côté, ,

nous pouvons dire que pour que Q soit vraie, il suffit

que

P soit vraie (effectivement l'implication sera vraie

si P est vraie ou fausse selon la table de vérité).

Donc P est une condition suffisante de Q (mais

non nécessaire!). D'un autre côté,  est

équivalent à est

équivalent à  (nous

parlons alors de "contraposée"). Donc, si Q est

fausse, il est impossible que P soit

vraie (pour que l'implication reste vraie bien sûr!). Donc

finalement Q est une condition nécessaire

de P. (nous

parlons alors de "contraposée"). Donc, si Q est

fausse, il est impossible que P soit

vraie (pour que l'implication reste vraie bien sûr!). Donc

finalement Q est une condition nécessaire

de P.

Exemples:

Exemples:

E1. Soit la proposition: "Si tu obtiens ton diplôme, je t'achète

un ordinateur"

Parmi tous les cas, un seul correspond à une promesse non tenue:

celui où l'enfant à son diplôme, et n'a toujours pas d'ordinateur

(deuxième ligne dans le tableau).

Et le cas où il n'a pas le diplôme, mais reçoit quand même un ordinateur?

Il est possible qu'il ait été longtemps malade et a raté un semestre,

et le père a le droit d'être bon.

Que signifie cette promesse, que nous écrirons aussi: "Tu

as ton diplôme  je t'achète un ordinateur" ? Exactement ceci:

je t'achète un ordinateur" ? Exactement ceci:

- Si tu as ton diplôme, c'est sûr, je t'achète un ordinateur (je

ne peux pas ne pas l'acheter)

- Si tu n'as pas ton diplôme, je n'ai rien dit

E2. De toute proposition fausse nous pouvons déduire

toute proposition (deux dernières lignes)

C'est un exemple plutôt anecdotique: dans un cours de Russell

portant sur le fait que d'une proposition fausse, toute proposition

peut être déduite, un étudiant lui posa la question

suivante:

- "Prétendez-vous que de 2 + 2 = 5, il s'ensuit que

vous êtes le pape ? "

- "Oui", fit Russell

- "Et pourriez-vous le prouver !", demanda l'étudiant

sceptique

- "Certainement", réplique Russell, qui proposa

sur le champ la démonstration suivante.

(1) Supposons que 2 + 2 = 5

(2) Soustrayons 2 de chaque membre de l'égalité,

nous obtenons 2 = 3

(3) Par symétrie, 3 = 2

(4) Soustrayant 1 de chaque côté, il vient 2 =1

Maintenant le pape et moi sommes deux. Puisque 2 = 1, le pape et

moi sommes un. Par suite, je suis le pape.

Sur ce ...

Le connecteur d'implication est essentiel en mathématiques, philosophie,

etc. C'est un des fondements de toute démonstration, preuve ou déduction.

Le connecteur d'implication a comme propriétés (vérifiables à l'aide

de la table de vérité ci-dessous):

(1.10)

(1.10)

conséquence de la dernière propriété (à nouveau vérifiable par

une table de vérité):

(1.11)

(1.11)

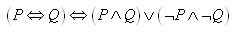

Le "connecteur d'équivalence

logique"

ou "biconditionnel" noté

" "

ou " "

ou " "

signifiant par définition que: "

signifiant par définition que:

(1.12)

(1.12)

en d'autres termes, la première expression a la même

valeur pour toute évaluation de la deuxième. Il

est de même de la relation suivante qui est plus "atomique"

puisque l'équivalence logique se réduit uniquement à l'utilisation

et  et

de la négation (combinaison de ce que nous avons vu plus haut): et

de la négation (combinaison de ce que nous avons vu plus haut):

(1.13)

(1.13)

Lorsque nous démontrons une telle équivalence de deux expressions

nous disons alors que: nous prouvons que l'équivalence est une

tautologie.

La table de vérité de l'équivalence est donnée logiquement par:

P |

Q |

|

|

|

V |

V |

V |

V |

V |

V |

F |

F |

V |

F |

F |

V |

V |

F |

F |

F |

F |

V |

V |

V |

Tableau: 1.7

- Table de vérité de l'équivalence logique

signifie

bien (lorsqu'il est vrai!) que "P et Q ont

toujours la même valeur de vérité" ou encore "P

et Q sont équivalents". C'est vrai si P et

Q ont même valeur, faux dans tout cas contraire. signifie

bien (lorsqu'il est vrai!) que "P et Q ont

toujours la même valeur de vérité" ou encore "P

et Q sont équivalents". C'est vrai si P et

Q ont même valeur, faux dans tout cas contraire.

Bien évidemment (c'est une tautologie):

(1.14)

(1.14)

La relation  équivaut

donc à ce que P soit une condition nécessaire et suffisante

de Q et à ce que Q soit une condition nécessaire

et suffisante de P. équivaut

donc à ce que P soit une condition nécessaire et suffisante

de Q et à ce que Q soit une condition nécessaire

et suffisante de P.

La conclusion, est que les conditions de type "nécessaire,

suffisant, nécessaire et suffisant" peuvent être

reformulées

avec les termes "seulement si", "si", "si et seulement si".

Ainsi:

1.  traduit le fait que Q est une condition nécessaire

pour P ou dit autrement, P est vraie seulement

si Q est vraie (dans la table de vérité,

lorsque

traduit le fait que Q est une condition nécessaire

pour P ou dit autrement, P est vraie seulement

si Q est vraie (dans la table de vérité,

lorsque  prend la valeur 1 on constate bien que P vaut 1 seulement

si Q vaut 1 aussi). On dit aussi, si

P est vraie alors Q

est vraie.

prend la valeur 1 on constate bien que P vaut 1 seulement

si Q vaut 1 aussi). On dit aussi, si

P est vraie alors Q

est vraie.

2.  ou ce qui revient au même

ou ce qui revient au même  traduit le fait que Q est une condition suffisante

pour P ou dit autrement, P est vraie si

Q est vraie (dans la table de vérité, lorsque

traduit le fait que Q est une condition suffisante

pour P ou dit autrement, P est vraie si

Q est vraie (dans la table de vérité, lorsque

prend la valeur 1 on constate bien que P vaut 1 si

Q vaut 1 aussi).

prend la valeur 1 on constate bien que P vaut 1 si

Q vaut 1 aussi).

3.  traduit le fait que Q est une condition nécessaire

et suffisante pour P ou dit autrement, P est

vraie si et seulement si Q

est vraie (dans la table de vérité, lorsque

traduit le fait que Q est une condition nécessaire

et suffisante pour P ou dit autrement, P est

vraie si et seulement si Q

est vraie (dans la table de vérité, lorsque  prend la valeur 1 on constate bien que P vaut 1 si

Q vaut 1 et seulement si Q

vaut 1).

prend la valeur 1 on constate bien que P vaut 1 si

Q vaut 1 et seulement si Q

vaut 1).

Remarque: L'expression "si et seulement si" correspond

donc a

une équivalence logique et ne peut être utilisée

que pour décrire une bi-implication!!

La première étape du calcul propositionnel est donc

la formalisation des énoncés du langage naturel. Pour

réaliser ce travail, le calcul propositionnel fournit

finalement trois types d'outils:

1. Les "variables propositionnelles" (P, Q, R,...)

symbolisent des propositions simples quelconques. Si la même

variable apparaît plusieurs fois, elle symbolise chaque fois

la même proposition.

2. Les cinq opérateurs logiques:

3. Les signes de ponctuation se réduisent aux seules parenthèses

ouvrante et fermante qui organisent la lecture de manière

à éviter toute ambiguïté.

Voici un tableau récapitulatif:

|

Description |

Symbole |

Utilisation |

|

La "négation" est

un opérateur qui ne porte que sur une proposition;

il est unaire ou monadique. "Il ne pleut pas" s'écrit  .

Cet énoncé est vrai si et seulement si P est

faux (dans ce cas s'il est faux qu'il pleut). L'usage

classique de la négation est caractérisé par

la loi de double négation: .

Cet énoncé est vrai si et seulement si P est

faux (dans ce cas s'il est faux qu'il pleut). L'usage

classique de la négation est caractérisé par

la loi de double négation:  est équivalent à P. est équivalent à P. |

|

|

|

La "conjonction" ou "produit

logique" est un opérateur binaire; elle

met en relation deux propositions. "Tout

homme est mortel ET Ma voiture perd de l'huile" s'écrit

.

Cette dernière expression est vraie si et seulement

si P est vrai et Q est vrai. .

Cette dernière expression est vraie si et seulement

si P est vrai et Q est vrai. |

|

|

|

La "disjonction" ou "somme

logique" est, elle aussi, un opérateur

binaire.  ;

est vraie si et seulement si P est vraie ou Q est

vraie. Nous pouvons comprendre ce OU de deux façons:

soit de manière inclusive, soit de manière

exclusive. Dans le premier cas ;

est vraie si et seulement si P est vraie ou Q est

vraie. Nous pouvons comprendre ce OU de deux façons:

soit de manière inclusive, soit de manière

exclusive. Dans le premier cas  est

vrai si P est vraie, si Q est vraie ou

si P et Q sont tous deux vrais. Dans

le second cas, est

vrai si P est vraie, si Q est vraie ou

si P et Q sont tous deux vrais. Dans

le second cas,  est

vraie si P est vraie ou si Q est vraie

mais pas si les deux le sont. La disjonction du calcul

propositionnel

est le OU inclusif et on donne au OU exclusif le nom "d'alternative". est

vraie si P est vraie ou si Q est vraie

mais pas si les deux le sont. La disjonction du calcul

propositionnel

est le OU inclusif et on donne au OU exclusif le nom "d'alternative". |

|

|

|

"L'implication" est également

un opérateur binaire. Elle correspond, en

gros, au schéma linguistique "Si...alors...". "Si

j'ai le temps, j'irai au cinéma" s'écrit  . .  est

fausse si P est vrai et Q est faux. Si

le conséquent (ici Q) est vrai, l'implication est

fausse si P est vrai et Q est faux. Si

le conséquent (ici Q) est vrai, l'implication  est

vraie. Lorsque l'antécédente (ici P)

est fausse, l'implication est toujours vraie. Cette dernière

remarque peut être comprise si l'on se réfère à des énoncés

de type: "Si on pouvait mettre Paris en bouteille,

on utiliserait la tour Eiffel comme bouchon." En

résumé, une implication est fausse si et

seulement si son antécédente est vraie

et son conséquent est fausse. est

vraie. Lorsque l'antécédente (ici P)

est fausse, l'implication est toujours vraie. Cette dernière

remarque peut être comprise si l'on se réfère à des énoncés

de type: "Si on pouvait mettre Paris en bouteille,

on utiliserait la tour Eiffel comme bouchon." En

résumé, une implication est fausse si et

seulement si son antécédente est vraie

et son conséquent est fausse.

|

|

|

|

La "bi-implication" est,

elle aussi, binaire: elle symbolise les expressions "...

si et seulement si..." et "... est équivalent à..." L'équivalence

entre deux propositions est vraie si celles-ci ont la

même valeur de vérité. La bi-implication

exprime donc aussi une forme d'identité et c'est

pourquoi elle est souvent utilisée dans les définitions. |

|

|

Tableau: 1.8

- Récapitulatif des opérateurs

Il est possible d'établir des équivalences entre

ces opérateurs. Nous avons déjà vu comment

le biconditionnel pouvait se définir comme un produit

de conditionnels réciproques, voyons maintenant d'autres équivalences:

(1.15)

(1.15)

Remarque: Les opérateurs classiques

peuvent donc être définis à l'aide de

grâce aux lois d'équivalence entre opérateurs.

Sont à noter également les deux relations de De

Morgan (cf. chapitre d'Algèbre de

Boole):

(1.16)

(1.16)

Elles permettent de transformer la disjonction en conjonction et

vice-versa:

(1.17)

(1.17)

PROCÉDURES DE DÉCISION

Nous avons introduit précédemment les éléments

de base nous permettant d'opérer sur des expressions à

partir de propriétés (variables propositionnelles)

sans toutefois dire grand-chose quant à la manipulation

de ces expressions. Alors, il convient maintenant de savoir

qu'en calcul

propositionnel il existe deux manières d'établir

qu'une proposition est une loi de la logique propositionnelle.

Nous

pouvons soit:

1. Employer des procédures non axiomatisées

2. Recourir à des procédures axiomatiques et démonstratives

Remarque: Dans de nombreux ouvrages ces procédures

sont présentées avant même la structure

du langage propositionnel. Nous avons choisi de faire le contraire

pensant

que l'approche serait plus aisée.

PROCÉDURES DE DÉCISIONS NON AXIOMATISÉES

Plusieurs de ces méthodes existent mais nous nous limiterons

ici à la plus simple et à la plus parlante d'entre

elles, celle du calcul matriciel, souvent appelée aussi "méthodes

des tables de vérité".

La procédure de construction est comme nous l'avons vu

précédemment

assez simple. Effectivement, la valeur de vérité d'une

expression complexe est fonction de la valeur vérité

des énoncés plus simples qui la composent, et finalement

fonction de la valeur de vérité des variables

propositionnelles qui la composent. En envisageant toutes les

combinaisons possibles

des valeurs de vérité des variables propositionnelles,

nous pouvons déterminer les valeurs de vérité

de l'expression complexe.

Les tables de vérité, comme nous l'avons vu, permettent

donc de décider, à propos de toute proposition, si

celle-ci est une tautologie (toujours vraie), une contradiction

(toujours fausse) ou une expression contingente (parfois vraie,

parfois fausse).

Nous pouvons ainsi distinguer quatre façons de combiner

les variables propositionnelles, les parenthèses et les

connecteurs:

| |

Nom |

Description |

Exemple |

| 1 |

Enoncé mal formé |

Non-sens. Ni vrai, ni faux |

|

| 2 |

Tautologie |

Enoncé toujours vrai |

|

| 3 |

Contradiction |

Enoncé toujours faux |

|

| 4 |

Enoncé contingent |

Enoncé parfois vrai,

parfois faux |

|

Tableau: 1.9

- Combinaison de variables propositionnelles

La méthode des tables de vérité permet de

déterminer le type d'expression bien formée face auquel

nous nous trouvons. Elle n'exige en principe aucune invention, c'est

une procédure mécanique. Les procédures axiomatisées,

en revanche, ne sont pas entièrement mécaniques. Inventer

une démonstration dans le cadre d'un système axiomatisé

demande parfois de l'habilité, de l'habitude ou de la chance.

Pour ce qui est des tables de vérité, voici la marche

à suivre:

Lorsqu'on se trouve face à une expression bien formée,

ou fonction de vérité, nous commençons par déterminer

à combien de variables propositionnelles distinctes nous

avons affaire. Ensuite, nous examinons les différents arguments

qui constituent cette expression. Nous construisons alors un

tableau

comprenant  rangées

(n étant le nombre de variables) et un nombre

de colonnes

égal au nombre d'arguments plus des colonnes pour l'expression

elle-même et ses autres composantes. Nous attribuons alors

aux variables les différentes combinaisons de vérité

et de fausseté qui peuvent leur être conférées

(la vérité est exprimée dans la table par

un 1 et la fausseté par un 0). Chacune des rangées

correspond à un monde possible et la totalité des

rangées constitue l'ensemble des mondes possibles.

Il existe, par exemple, un monde possible dans lequel P est

une proposition vraie tandis que Q est fausse. rangées

(n étant le nombre de variables) et un nombre

de colonnes

égal au nombre d'arguments plus des colonnes pour l'expression

elle-même et ses autres composantes. Nous attribuons alors

aux variables les différentes combinaisons de vérité

et de fausseté qui peuvent leur être conférées

(la vérité est exprimée dans la table par

un 1 et la fausseté par un 0). Chacune des rangées

correspond à un monde possible et la totalité des

rangées constitue l'ensemble des mondes possibles.

Il existe, par exemple, un monde possible dans lequel P est

une proposition vraie tandis que Q est fausse.

PROCÉDURES DE DÉCISIONS AXIOMATISÉES

L'axiomatisation d'une théorie implique, outre la formalisation

de celle-ci, que nous partions d'un nombre fini d'axiomes et

que,

grâce à la transformation réglée de

ces derniers, nous puissions obtenir tous les théorèmes

de cette théorie. Nous partons donc de quelques axiomes

dont la vérité est posée (et non démontrée).

Nous déterminons des règles de déduction

permettant de manipuler les axiomes ou toute expression obtenue à partir

de ceux-ci. L'enchaînement de ces déductions

est une démonstration qui conduit à un théorème,

à une loi.

Nous allons sommairement présenter deux systèmes

axiomatiques, chacun étant constitué d'axiomes utilisant

deux règles dites "règles d'inférence"

(règles intuitives) particulières:

Règle 1. Le "modus ponens":

si nous avons prouvé A et  ,

alors nous pouvons déduire B. A est appelé

la "prémisse mineure" et ,

alors nous pouvons déduire B. A est appelé

la "prémisse mineure" et  la prémisse majeure de la règle du modus ponens.

la prémisse majeure de la règle du modus ponens.

Exemple: De

Exemple: De  et et  nous

pouvons déduire nous

pouvons déduire

Règle 2. La "substitution":

nous pouvons dans un schéma d'axiomes remplacer une lettre

par une formule quelconque, pourvu que toutes les lettres identiques

soient remplacées

par des formules identiques.

Donnons à titre d'exemple, deux systèmes axiomatiques: le système axiomatique de Whitehead et Russell, le

système

axiomatique de Lukasiewicz.

1. Le système axiomatique de Whitehead et Russel adopte

comme symboles primitifs  et définit

et définit  à partir de ces derniers de la manière suivante (relations

facilement vérifiables à l'aide de tables de vérité):

à partir de ces derniers de la manière suivante (relations

facilement vérifiables à l'aide de tables de vérité):

(1.18)

(1.18)

nous avions déjà présenté plus haut

quelques-uns de ces éléments.

Ce système comprend cinq axiomes, assez évidents

en soi plus les deux règles d'inférence. Les axiomes

sont donnés ici en utilisant des symboles non primitifs,

comme le faisaient Whitehead et Russel:

A1.

A2.

A3.

A4.

A5.

Remarque: Ces cinq axiomes ne sont pas indépendants

les uns des autres. Le quatrième peut être obtenu à

partir des quatre autres.

Exemple:

Exemple:

Pour justifier le fait que ,

a du sens, nous pouvons procéder ainsi :: ,

a du sens, nous pouvons procéder ainsi ::

(1.19)

2. Le système axiomatique de Lukasiewicz comprend les

trois axiomes suivants, plus les deux règles d'inférences

(modus ponens et substitution):

A1.

A2.

A3.

Voici des preuves des deux premiers axiomes, dans le système

de Whitehead et Russel. Ce sont les formules (6) et (16) de

la dérivation

suivante:

(1.20)

Ces axiomatisations permettent de retrouver comme théorèmes

toutes les tautologies ou lois de la logique propositionnelle.

De

par tout ce qui a été dit jusqu'à maintenant,

nous pouvons tenter de définir ce qu'est une preuve.

Définition: Une suite finie de formules  est appelée "preuve"

à partir des hypothèses

est appelée "preuve"

à partir des hypothèses  si pour chaque i: si pour chaque i:

-  est l'une des hypothèses

est l'une des hypothèses

- ou  est une variante d'un axiome

est une variante d'un axiome

- ou  est inférée (par application de la règle du

modus ponens) à partir de la prémisse majeure

est inférée (par application de la règle du

modus ponens) à partir de la prémisse majeure  et de la prémisse mineure et de la prémisse mineure  où

où

- ou  est inférée (par application de la règle de

substitution) à partir d'une prémisse antérieure

est inférée (par application de la règle de

substitution) à partir d'une prémisse antérieure

,

la variable remplacée n'apparaissant pas dans ,

la variable remplacée n'apparaissant pas dans

Une telle suite de formules,  étant la formule finale de la suite, est appelée plus

explicitement "preuve de

étant la formule finale de la suite, est appelée plus

explicitement "preuve de  "

à partir des hypothèses "

à partir des hypothèses  ,

ce que nous notons par: ,

ce que nous notons par:

(1.21)

(1.21)

Remarque: Il faut noter que lorsque nous essayons de

prouver un résultat à partir d'un certain nombre

d'hypothèses,

nous n'essayons pas de prouver les hypothèses elles-mêmes.

QUANTIFICATEURS

Nous devons compléter l'utilisation des connecteurs du

calcul propositionnel par ce que nous appelons des "quantificateurs"

si nous souhaitons pouvoir résoudre certains problèmes.

Effectivement, le calcul propositionnel ne nous permet pas d'affirmer

des choses générales sur les éléments

d'un ensemble par exemple. Dans ce sens, la logique propositionnelle

ne reflète qu'une partie du raisonnement. Le "calcul

des prédicats" au contraire permet de manipuler

formellement des affirmations telles que "il existe un x

tel que [x a une voiture américaine]" ou "pour

tous les x [si x est un teckel, alors x est

petit]"; en somme, nous étendons les formules composées

afin de pouvoir affirmer des quantifications existentielles

("il

existe...") et des quantifications universelles ("pour

tout....").

Les exemples que nous venons de donner font intervenir des propositions

un peu particulières comme "x a une voiture

américaine".

Il s'agit ici de propositions comportant une variable. Ces propositions

sont en fait l'application d'une fonction à x. Cette

fonction, c'est celle qui associe "x a une voiture

américaine" à x. Nous dénoterons

cette fonction par "... a une voiture américaine"

et nous dirons que c'est une fonction propositionnelle, car c'est

une fonction dont la valeur est une proposition. Ou encore un "prédicat".

Les quantificateurs existentiels et universels vont donc de

pair avec l'emploi de fonctions propositionnelles. Le calcul

des prédicats

est cependant limité dans les formules existentielles

et universelles. Ainsi, nous nous interdisons des formules comme "il

existe une affirmation de x telle que...". En fait,

nous ne nous autorisons à quantifier que des "individus".

C'est pour cela que la logique des prédicats est dite

une

"logique du premier ordre" car

elle utilise comme variables des objets mathématiques élémentaires

(tandis que dans la logique du deuxième ordre elles peuvent aussi

être des ensembles).

Avant de passer à l'étude du calcul des prédicats

nous devons définir:

D1. Le "quantificateur universel":  (pour tout)

(pour tout)

D2. Le "quantificateur existentiel":  (il existe)

(il existe)

Remarque: Nous utilisons parfois

le symbole

pour

dire brièvement: "il existe un et un seul": pour

dire brièvement: "il existe un et un seul":

(1.22)

(1.22)

Nous allons voir que la théorie de la démonstration

et des ensembles est l'exacte transcription des principes et

résultats de la Logique

(celle avec un "L" majuscule).

CALCUL DES PRÉDICATS

Dans un cours de mathématiques (d'algèbre, d'analyse,

de géométrie,

...), nous démontrons les propriétés de différents

types d'objets (entiers, réels, matrices, suites, fonctions

continues, courbes,

...). Pour pouvoir prouver ces propriétés, il

faut bien sûr

que les objets sur lesquels nous travaillons soient clairement

définis

(qu'est-ce qu'un entier, un réel, ...?).

En logique du premier ordre et, en particulier, en théorie de la

démonstration, les objets que nous étudions sont les formules et

leurs démonstrations. Il faut donc donner une définition précise

de ce que sont ces notions. Les termes et les formules forment la

grammaire d'une langue, simplifiée à l'extrême et calculée exactement

pour dire ce que nous voulons sans ambiguïté et sans détour inutile.

GRAMMAIRE

Définitions:

D1. Les "termes", désignent

les objets dont nous voulons prouver des propriétés (nous reviendrons

un peu plus loin beaucoup plus en détail sur ces derniers):

- En algèbre, les termes désignent les éléments d'un groupe (ou

anneau, corps, espace vectoriel, etc.). Nous manipulons aussi des

ensembles d'objets (sous-groupe, sous-espace vectoriel, etc). Les

termes qui désignent ces objets, d'un autre type, seront appelés

"termes du second ordre".

- En analyse, les termes désignent les réels ou

(par exemple, si nous nous plaçons dans des espaces fonctionnels)

des fonctions.

D2. Les "formules", représentent

les propriétés des objets que nous étudions (nous reviendrons également

beaucoup plus en détail sur ces dernières):

- En algèbre, nous pourrons écrire des formules pour exprimer que

deux éléments commutent, qu'un sous-espace vectoriel est de dimension

3, etc.

- En analyse, nous écrirons des formules pour exprimer la continuité

d'une fonction, la convergence d'une suite, etc.

- En théorie des ensembles, les formules pourront exprimer

l'inclusion de deux ensembles, l'appartenance d'un élément à un

ensemble,...

D3. Les "démonstrations",

elles permettent d'établir qu'une formule est vraie. Le sens précis

de ce mot aura lui aussi besoin d'être défini. Plus exactement,

elles sont des déductions sous hypothèses, elles permettent de "mener

du vrai au vrai", la question de la vérité de la conclusion

étant alors renvoyée à celle des hypothèses, laquelle ne regarde

pas la logique mais repose sur la connaissance que nous avons des

choses dont nous parlons.

LANGAGES

En mathématique, nous utilisons, suivant le domaine, différents

langages qui se distinguent par les symboles utilisés. La définition

ci-dessous exprime simplement qu'il suffit de donner la liste de

ces symboles pour préciser le langage.

Définition: Un

"langage" est la donnée

d'une famille (pas nécessairement finie) de symboles.

Nous en distinguons de trois sortes: symboles, termes et formules.

Remarques:

R1. Nous utilisons quelques fois le mot "vocabulaire"

ou le mot "signature" à la

place du mot "langage".

R2. Le mot "prédicat" peut être utilisé à la place du

mot "relation". Nous parlons alors de "calcul des

prédicats" au lieu de "logique du premier ordre"

(ce que nous avons étudié précédemment).

SYMBOLES

Il existe différents types de symboles que nous allons tâcher de

définir:

D1. Les "symboles de constante"

(voir remarque plus bas)

Exemple:

Exemple:

Le n pour l'élément neutre en théorie

des ensembles (cf. chapitre de Théorie

Des Ensembles)

D2. Les "symboles de fonction"

ou "foncteurs". A chaque

symbole de fonction est associé un entier strictement

positif que nous appelons son "arité": c'est le nombre d'arguments de la fonction. Si l'arité est

1 (resp. 2, ...,n), nous disons que la fonction est unaire

(resp. binaire, ..., n-aire)

Exemple:

Exemple:

Le foncteur binaire de multiplication * dans les groupes (cf.

chapitre de Théorie Des Ensembles).

D3. Les "symboles de relation".

De la même manière, à chaque symbole de relation est associé un

entier positif ou nul (son arité) qui correspond à son nombre d'arguments

et nous parlons de relation unaire, binaire, n-aire (comme

par exemple le symbole de relation "=").

D4. Les "variables individuelles".

Dans toute la suite, nous nous donnerons un ensemble infini V

de variables. Les variables seront notées comme il l'est

de tradition: x, y, z (éventuellement indexées:  ). ).

D5. A cela il faut rajouter les connecteurs et quantificateurs

que nous avons longuement présentés plus haut

et sur lesquels il est pour l'instant inutile de revenir.

Remarques:

R1. Un symbole de constante peut être vu comme un symbole de fonction

à 0 argument (d'arité nulle).

R2. Nous considérons (sauf mention contraire) que chaque langage

contient le symbole de relation binaire = (lire "égal")

et le symbole de relation à zéro argument dénoté  (lire

"bottom" ou "absurde") qui représente

le faux. Dans la description d'un langage, nous omettrons donc

souvent de

les mentionner. Le symbole (lire

"bottom" ou "absurde") qui représente

le faux. Dans la description d'un langage, nous omettrons donc

souvent de

les mentionner. Le symbole  est

souvent redondant. Nous pouvons en effet, sans l'utiliser, écrire

une formule qui est toujours fausse. Il permet cependant de

représenter

le faux d'une manière canonique et donc d'écrire

des règles de démonstration

générales. est

souvent redondant. Nous pouvons en effet, sans l'utiliser, écrire

une formule qui est toujours fausse. Il permet cependant de

représenter

le faux d'une manière canonique et donc d'écrire

des règles de démonstration

générales.

R3. Le rôle des fonctions et des relations est très différent.

Comme nous le verrons plus loin, les symboles de fonction sont

utilisés

pour construire les termes (les objets du langage) et les symboles

de relation pour construire les formules (les propriétés

de ces objets).

TERMES

Les termes (nous disons aussi "termes du premier ordre")

représentent les objets associés au langage.

Définitions:

Soit  un

langage: un

langage:

D1. L'ensemble  des

termes sur des

termes sur  est

le plus petit ensemble contenant les variables, les constantes et

stable (on ne sort pas de l'ensemble) par l'application des symboles

de fonction de est

le plus petit ensemble contenant les variables, les constantes et

stable (on ne sort pas de l'ensemble) par l'application des symboles

de fonction de à

des termes. à

des termes.

D2. Un "terme clos" est

un terme qui ne contient pas de variables (donc par extension, seulement

des constantes).

D3. Pour obtenir une définition plus formelle, nous pouvons écrire:

(1.23)

(1.23)

où t est une variable ou un symbole de constante et, pour

tout  : :

(1.24)

(1.24)

où f est une fonction d'arité n (rappelons que l'arité

est le nombre d'arguments de la fonction). Ainsi, pour chaque arité,

il y a un degré d'ensemble de termes. Nous avons finalement:

(1.25)

(1.25)

D4. Nous appellerons "hauteur"

d'un terme t le plus petit k tel que

Dans la suite, nous allons sans cesse définir des notions (ou prouver

des résultats) "par récurrence" sur la structure ou la

taille d'un terme.

Définitions:

D1. Pour prouver une propriété P sur les

termes, il suffit de prouver P pour les variables et

les constantes et de prouver

à

partir de à

partir de  .

Nous faisons ainsi ici une "preuve

par induction sur la hauteur d'un terme". C'est

une technique que nous retrouverons dans les chapitres suivants. .

Nous faisons ainsi ici une "preuve

par induction sur la hauteur d'un terme". C'est

une technique que nous retrouverons dans les chapitres suivants.

D2. Pour définir une fonction  sur

les termes, il suffit de la définir sur les variables et les constantes

et de dire comment nous obtenons sur

les termes, il suffit de la définir sur les variables et les constantes

et de dire comment nous obtenons  à

partir de à

partir de  .

Nous faisons ici encore une "définition

par induction sur la hauteur d'un terme". .

Nous faisons ici encore une "définition

par induction sur la hauteur d'un terme".

Exemple: Exemple:

La taille (nous disons aussi la "longueur") d'un terme

t (notée  )

est le nombre de symboles de fonction apparaissant dans t.

Formellement: )

est le nombre de symboles de fonction apparaissant dans t.

Formellement:

-  si

x est une variable et c est une constante si

x est une variable et c est une constante

-

où le 1 dans la dernière relation relation représente le terme f.

Remarque: La preuve par induction sur la hauteur d'un

terme sera souvent insuffisante. Nous pourrons alors prouver

une propriété

P sur les termes en supposant la propriété vraie

pour tous les termes de taille  et

en la démontrant ensuite pour les termes de taille n.

Il s'agira alors d'une " preuve par

récurrence

sur la taille du terme" (voir de tels exemples dans

le chapitre de Théorie Des Nombres).

FORMULES

Les formules sont construites à partir de

"formules atomiques" en

utilisant des connecteurs et des quantificateurs.

Nous utiliserons les connecteurs et les quantificateurs suivants

(qui

nous sont déjà connus):

- connecteur unaire de négation:

- connecteurs binaires de conjonction et disjonction ainsi que

d'implication:  , ,

, ,

- quantificateurs:  qui

se lit "il existe" et qui

se lit "il existe" et  qui

se lit "pour tout" qui

se lit "pour tout"

Cette notation des connecteurs est standard (elle devrait du moins).

Elle est utilisée pour éviter les confusions entre les formules

et le langage courant (le métalangage).

Définitions:

D1. Soit  un

langage, les "formules atomiques"

de un

langage, les "formules atomiques"

de  sont

les formules de la forme sont

les formules de la forme  où

R est un symbole de relation n-aire de où

R est un symbole de relation n-aire de  et et

sont

des termes de sont

des termes de  .

Nous notons "Atom" l'ensemble

des formules atomiques. Si nous notons .

Nous notons "Atom" l'ensemble

des formules atomiques. Si nous notons  l'ensemble

des symboles de relation, nous pouvons écrire l'ensemble des termes

mis en relations par l'expression: l'ensemble

des symboles de relation, nous pouvons écrire l'ensemble des termes

mis en relations par l'expression:

(1.27)

(1.27)

L'ensemble F des formules de la logique du premier ordre

de  est

donc défini par la grammaire (où x est une variable): est

donc défini par la grammaire (où x est une variable):

(1.28)

(1.28)

où il faut lire: l'ensemble des formules est le plus petit

ensemble contenant les formules et tel que si  et et

sont

des formules alors sont

des formules alors  ,

etc. sont des formules et qu'elles peuvent être en

relation entre elles. ,

etc. sont des formules et qu'elles peuvent être en

relation entre elles.

Exemple:

Exemple:

Les symboles de relation du langage propositionnel sont des

relations d'arité 0 (même le symbole "=" est absent),

les quantificateurs sont alors inutiles (puisqu'une formule

propositionnelle ne peut pas contenir des

variables). Nous obtenons alors le calcul propositionnel défini

par:

(1.29)

(1.29)

Remarquons la présence du symbole "bottom" signifiant

le

"faux" que nous n'avions pas mentionné lors

de notre étude de la logique propositionnelle.

Nous ferons attention à ne pas confondre termes et formules.  est

un terme (fonction), est

un terme (fonction),  est

une formule. Mais est

une formule. Mais  n'est

rien: nous ne pouvons, en effet, mettre un connecteur entre

un

terme et une formule (aucun sens). n'est

rien: nous ne pouvons, en effet, mettre un connecteur entre

un

terme et une formule (aucun sens).

Remarques:

R1. Pour définir une fonction  sur

les formules, il suffit de définir sur

les formules, il suffit de définir  sur

les formules atomiques. sur

les formules atomiques.

R2. Pour prouver une propriété P sur les

formules, il suffit de prouver P pour les formules atomiques.

R3. Pour prouver une propriété P sur les formules, il suffit

de supposer la propriété vraie pour toutes les formules de taille

et de la démontrer pour les formules de taille n.

et de la démontrer pour les formules de taille n.

D2. Une "sous-formule" d'une

formule (ou expression) F est l'un de ses composants,

in extenso une formule à partir de laquelle F est construite.

Formellement, nous définissons l'ensemble SF(F) des

sous-formules de F par:

- Si F est atomique:

- Si  (soit

une composition!) avec (soit

une composition!) avec

- Si  ou ou

avec avec

D3. Une formule F de  n'utilise

qu'un nombre fini de symboles de n'utilise

qu'un nombre fini de symboles de  .

Ce sous-ensemble est appelé le "langage

de la formule" et noté .

Ce sous-ensemble est appelé le "langage

de la formule" et noté  . .

D4. La "taille (ou la longueur) d'une

formule" F (notée  )

est le nombre de connecteurs ou de quantificateurs apparaissant

dans F. Formellement: )

est le nombre de connecteurs ou de quantificateurs apparaissant

dans F. Formellement:

-  si

F est une formule atomique si

F est une formule atomique

-  où

où

-  avec avec

D5. "L'opérateur principal"

(nous disons aussi le "connecteur principal") d'une formule

est défini par:

- Si A est atomique, alors elle n'a pas d'opérateur principal

- Si  ,

alors ,

alors  est

l'opérateur principal de A est

l'opérateur principal de A

- Si  où où

,

alors ,

alors  est

l'opérateur principal de A est

l'opérateur principal de A

- Si  où où

,

alors ,

alors  est l'opérateur principal de A

est l'opérateur principal de A

D6. Soit F une formule. L'ensemble  des variables libres de F et l'ensemble

des variables libres de F et l'ensemble  des variables muettes (ou liées) de F sont définis par récurrence

sur

des variables muettes (ou liées) de F sont définis par récurrence

sur  . .

Une occurrence d'une variable donnée est dite "variable

liée" ou "variable

muette" dans une formule F si dans cette

même formule, un quantificateur y fait référence.

Dans le cas contraire, nous disons avoir une "variable

libre".

Remarque: Une occurrence d'une variable

x dans une formule F est une position de cette variable

dans la formule F. Ne pas confondre avec l'objet qu'est la

variable elle-même.

Pour préciser les variables libres possibles d'une formule F,

nous noterons  .

Cela signifie que les variables libres de F sont parmi .

Cela signifie que les variables libres de F sont parmi  in

extenso si y est libre dans F, alors y est

l'un des in

extenso si y est libre dans F, alors y est

l'un des  mais

les mais

les  n'apparaissent

pas nécessairement dans F. n'apparaissent

pas nécessairement dans F.

Nous pouvons définir les variables muettes ou libres

de manière

plus formelle:

1. Si  est

atomique alors est

atomique alors  est l'ensemble des variables libres apparaissant dans les

est l'ensemble des variables libres apparaissant dans les  et

nous avons alors pour les variables muettes et

nous avons alors pour les variables muettes

2. Si  où où

: :

alors alors

3. si  alors

alors  et et

4. si  avec avec

et et

Exemples:

Exemples:

E1. Soit F:  alors alors  et

et

E2. Soit G:  alors alors  et

et

D7. Nous disons que les formules F et G sont " -équivalentes" si

elles sont (syntaxiquement) identiques à un renommage près des occurrences

liées des variables. -équivalentes" si

elles sont (syntaxiquement) identiques à un renommage près des occurrences

liées des variables.

D8. Une "formule close"