|

THÉORIE

DE LA DÉMONSTRATION |

NOMBRES | OPÉRATEURS

ARITHMÉTIQUES

THÉORIE DES NOMBRES

| THÉORIE DES ENSEMBLES |

PROBABILITÉS | STATISTIQUES

Dernière mise à jour de ce chapitre:

2017-12-31 17:55:32 | {oUUID 1.706}

Version: 3.10 Révision 59 | Avancement: ~90%

vues

depuis le 2012-01-01:

0 vues

depuis le 2012-01-01:

0

LISTE DES SUJETS TRAITÉS SUR CETTE PAGE

LISTE DES SUJETS TRAITÉS SUR CETTE PAGE

ESTIMATEURS DE VRAISEMBLANCE

Ce qui va suivre est

d'une extrême importance en statistiques et est utilisé énormément

en pratique. Il convient donc d'y accorder une attention toute

particulière! Outre le fait que nous utiliserons cette

technique dans la présent chapitre, nous la retrouverons dans

le chapitre de Méthodes Numériques pour les techniques avancées

de régressions linéaires généralisées ainsi que dans le chapitre

de Génie Industriel dans le cadre de l'estimation des paramètres

de fiabilité.

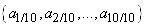

Nous supposons que nous

disposons d'observations  qui

sont des réalisations de variables aléatoires non biaisées (dans

le sens qu'elles sont choisies aléatoirement parmi un lot) indépendantes qui

sont des réalisations de variables aléatoires non biaisées (dans

le sens qu'elles sont choisies aléatoirement parmi un lot) indépendantes  de

loi de probabilité inconnue mais identique. de

loi de probabilité inconnue mais identique.

Nous allons chercher à estimer

cette loi de probabilité P inconnue à partir des observations  . .

Supposons que nous procédons

par tâtonnements pour estimer la loi de probabilité P inconnue.

Une manière

de procéder est de se demander si les observations  avaient

une probabilité élevée ou non de sortir avec

cette loi de probabilité arbitraire P. avaient

une probabilité élevée ou non de sortir avec

cette loi de probabilité arbitraire P.

Nous devons pour cela calculer

la probabilité conjointe qu'avaient les observations  de

sortir avec les probabilités de

sortir avec les probabilités  .

Cette probabilité conjointe vaut (cf.

chapitre de Probabilités): .

Cette probabilité conjointe vaut (cf.

chapitre de Probabilités):

(7.1)

(7.1)

en

notant P la loi de probabilité supposée

associée à  .

Il faut avouer qu'il serait alors particulièrement

maladroit, au niveau de la notion intuitive de risque, de

choisir une loi de probabilité (avec

ses paramètres!)

qui minimise cette quantité... .

Il faut avouer qu'il serait alors particulièrement

maladroit, au niveau de la notion intuitive de risque, de

choisir une loi de probabilité (avec

ses paramètres!)

qui minimise cette quantité...

Au contraire, nous allons

chercher les probabilités  (ou

les paramètres de la loi associée) qui

maximisent (ou

les paramètres de la loi associée) qui

maximisent ,

c'est-à-dire qui rende les observations ,

c'est-à-dire qui rende les observations  le

plus vraisemblable possible. le

plus vraisemblable possible.

Nous sommes donc amenés à chercher le (ou les) paramètre(s)

qui maximise(nt) la quantité:

qui maximise(nt) la quantité:

(7.2)

(7.2)

et où le paramètre  est

souvent dans les cas scolaires un moment d'ordre un (espérance)

ou d'ordre deux (variance). est

souvent dans les cas scolaires un moment d'ordre un (espérance)

ou d'ordre deux (variance).

Cette quantité L porte le

nom de "vraisemblance".

C'est une fonction du ou des paramètres  et

des observations et

des observations  . .

La ou les valeurs du paramètre  qui

maximisent la vraisemblance qui

maximisent la vraisemblance  sont

appelées "estimateurs

du maximum de vraisemblance" (estimateur MV/EMV). sont

appelées "estimateurs

du maximum de vraisemblance" (estimateur MV/EMV).

Dans le cas très particulier mais formateur de la loi

Normale, un des paramètres  sera

donc la variance (voir un peu plus loin l'exemple concret) et il

peut être considéré comme intuitif au physicien

que pour maximiser la probabilité, l'écart-type doit être

le plus petit possible (pour que le maximum d'évenements

se trouve dans un même intervalle).

Ainsi, lorsque nous calculons un EMV qui est le plus petit parmi

plusieurs possibles, nous parlons alors d'estimateur UMV pour "Uniform

Minimum Variance Unbiased" car leur propre variance

doit

être la plus petite possible. Cela se démontre (mais

c'est peu

élégant) en utilisant la définition de l'Information

de Fisher et du théorème de Fréchet

(ou de Rao-Cramer) qui fait usage de l'inégalité de

Cauchy-Schwartz (cf. chapitre de Calcul Vectoriel)

et de l'analogie entre espérance et produit scalaire...

Cette démonstration

ne sera pas présentée sur ce site Internet. sera

donc la variance (voir un peu plus loin l'exemple concret) et il

peut être considéré comme intuitif au physicien

que pour maximiser la probabilité, l'écart-type doit être

le plus petit possible (pour que le maximum d'évenements

se trouve dans un même intervalle).

Ainsi, lorsque nous calculons un EMV qui est le plus petit parmi

plusieurs possibles, nous parlons alors d'estimateur UMV pour "Uniform

Minimum Variance Unbiased" car leur propre variance

doit

être la plus petite possible. Cela se démontre (mais

c'est peu

élégant) en utilisant la définition de l'Information

de Fisher et du théorème de Fréchet

(ou de Rao-Cramer) qui fait usage de l'inégalité de

Cauchy-Schwartz (cf. chapitre de Calcul Vectoriel)

et de l'analogie entre espérance et produit scalaire...

Cette démonstration

ne sera pas présentée sur ce site Internet.

Faisons quand même cinq

petits exemples (très classiques, utiles et importants

dans l'industrie) avec dans l'ordre d'importance (donc pas forcément

dans l'ordre de facilité...) la fonction de distribution

de Gauss-Laplace (Normale), la fonction de distribution

de Poisson, la distribution Binomiale (et in extenso Géométrique),

la distribution de Weibull et finalement la distribution Gamma.

Remarque: Ces cinq exemples sont importants car utilisés

dans les SPC (maîtrise statistiques de processus) dans différentes

multinationales à travers le monde (cf.

chapitre de Génie Industriel).

ESTIMATEURS DE LA DISTRIBUTION NORMALE

Soit  un

n-échantillon

de variables aléatoires identiquement distribuées supposées

suivre une loi de Gauss-Laplace (loi Normale) de paramètres un

n-échantillon

de variables aléatoires identiquement distribuées supposées

suivre une loi de Gauss-Laplace (loi Normale) de paramètres  et et  . .

Nous recherchons quelles

sont les valeurs des estimateurs du maximum de vraisemblance  qui

maximisent la vraisemblance qui

maximisent la vraisemblance  de

la loi Normale? de

la loi Normale?

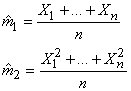

Remarque: Il va de soi que les estimateurs du maximum

de vraisemblance

sont

ici:

(7.3)

(7.3)

Nous avons démontré plus haut que la densité d'une

variable aléatoire

gaussienne était donnée

par:

(7.4)

(7.4)

La vraisemblance est alors

donnée

par:

(7.5)

(7.5)

Maximiser une fonction ou

maximiser son logarithme est équivalent donc la "log-vraisemblance"

sera:

(7.6)

(7.6)

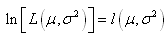

Nous retrouvons par ailleurs souvent dans la littérature la notation:

(7.7)

(7.7)

Pour déterminer

les deux estimateurs de la loi Normale, fixons d'abord l'écart-type.

Pour cela, dérivons  par

rapport à par

rapport à  et regardons pour quelle valeur de la moyenne la fonction s'annule.

et regardons pour quelle valeur de la moyenne la fonction s'annule.

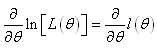

Remarque: La dérivéer partielle que nous chercheons à annuler

est souvent appelée la "fonction

score":

(7.8)

(7.8)

Il nous reste après simplification le terme suivant qui

est égal à zéro:

(7.9)

(7.9)

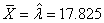

Ainsi, l'estimateur du maximum

de vraisemblance de la moyenne (espérance) de la loi Normale

est donc après réarrangement:

(7.10)

(7.10)

et nous voyons qu'il s'agit simplement de la moyenne arithmétique

(ou appelée aussi "moyenne empirique").

Fixons maintenant la moyenne.

L'annulation de la dérivée de  en

en  conduit à: conduit à:

(7.11)

(7.11)

Ce qui nous

permet d'écrire l'estimateur du maximum de vraisemblance

pour l'écart-type

(la variance lorsque la moyenne est connue selon la loi de distribution

supposée elle aussi connue!):

(7.12)

(7.12)

que certains appellent aussi "écart-type

de Pearson"...

Cependant, nous n'avons pas

encore défini ce qu'était un bon estimateur ! Ce que nous entendons

par là:

- Si l'espérance

d'un estimateur est égale à elle-même, nous

disons que cet estimateur est "sans

biais" et c'est bien évidemment ce que nous

cherchons!

- Si l'espérance

d'un estimateur n'est

pas égale à elle-même, nous disons

alors que cet estimateur est "biaisé" et

c'est forcément moins bien...

Dans l'exemple précédent,

la moyenne est donc non biaisée (trivial car la moyenne

de la moyenne arithmétique est égale à elle-même).

Mais qu'en est-il de la variance (in extenso de l'écart-type)

?

Un petit calcul simple par linéarité de l'espérance

(puisque les variables aléatoires sont identiquement distribuées)

va nous donner la réponse

dans le cas où la

moyenne théorique est approchée

comme dans la pratique (industrie) par l'estimateur de la moyenne

(cas le plus fréquent).

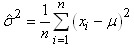

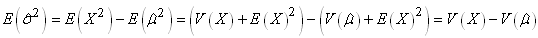

Nous avons donc le calcul de l'espérance

de la "variance empirique":

(7.13)

(7.13)

Or, comme les variables sont équidistribuées:

(7.14)

(7.14)

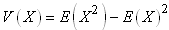

Et nous avons (relation de Huyghens):

(7.15)

(7.15)

ainsi que:

(7.16)

(7.16)

où la deuxième relation ne peut s'écrire que parce

que nous utilisons l'estimateur du maximum de vraisemblance de

la moyenne (moyenne

empirique). D'où:

(7.17)

(7.17)

et comme:

et et  (7.18)

(7.18)

Nous avons finalement:

(7.19)

(7.19)

nous avons donc un biais de moins une fois l'erreur-standard:

(7.20)

(7.20)

nous disons alors que cet estimateur à un biais négatif (il sous-estime

la vraie valeur!).

Nous noterons également

que l'estimateur tend vers un estimateur sans

biais (E.S.B.) lorsque le nombre d'individus tend

vers l'infini  .

Nous disons alors que nous avons un "estimateur

asymptotiquement non biaisé" ou "estimateur

asymptotiquement débiaisé". .

Nous disons alors que nous avons un "estimateur

asymptotiquement non biaisé" ou "estimateur

asymptotiquement débiaisé".

Il est important

de prendre note que nous avons démontré que

la variance empirique tend vers la variance théorique

quand n tend

vers l'infini et ce... que les données suivent une loi Normale

ou non!

Remarque: Un estimateur est aussi dit " estimateur

consistant" s'il converge en probabilité, lorsque  ,

vers la vraie valeur du paramètre.

De par les propriétés de

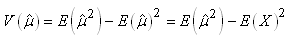

l'espérance, nous avons alors:

(7.21)

(7.21)

Il vient alors:

(7.22)

(7.22)

que certains appellent

aussi "écart-type standard"...

(à ne pas confondre avec "l'erreur-standard" que nous verrons plus

loin).

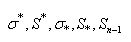

Nous avons donc finalement pour résumer

les deux résultats importants suivants:

1. "L'estimateur du maximum de vraisemblance

biaisé"

ou appelé également "écart-type

empirique" ou encore "écart-type échantillonnal" ou

encore "écart-type de Pearson"

... et donc donné par:

(7.23) (7.23)

lorsque  .

Nous retrouvons cet écart-type suivant les contextes (par

tradition) noté de cinq autres différentes façons

qui sont: .

Nous retrouvons cet écart-type suivant les contextes (par

tradition) noté de cinq autres différentes façons

qui sont:

(7.24)

(7.24)

et même parfois (mais c'est très malheureux

car cela génère alors souvent de la confusion avec

l'estimateur non biaisé)  ou S. ou S.

2. "L'estimateur

du maximum de vraisemblance non biaisé" ou

appelé

également "écart-type

standard" avec la "correction

de Bessel" (le -1 au dénominateur est la correction en

question...):

(7.25)

(7.25)

qui comme nous le voyons est un estimateur convergent (quand n tend

vers l'infini celui-ci tend vers l'estimateur

du maximum de vraisemblance biaisé).

Nous retrouvons cet écart-type suivant les contextes (par

tradition) noté de trois autres différentes façons

qui sont:

(7.26)

(7.26)

Nous retrouverons ces deux dernières notations souvent

dans les tables et dans de nombreux logiciels et que nous utiliserons

plus bas

dans les développements des intervalles de confiance et

des tests d'hypothèses!

Par

exemple, dans la version française de de Microsoft Excel 11.8346

l'estimateur biaisé est

donné par

la fonction ECARTYPEP( ) et le non biaisé par ECARTTYPE(

).

Au total, cela nous fait donc trois estimateurs pour la même

quantité!! Comme dans l'écrasante majorité des

cas de l'industrie la moyenne théorique n'est pas connue,

nous utilisons le plus souvent les deux dernières relations

encadrées

ci-dessus. Maintenant, c'est là que c'est le plus vicieux:

lorsque nous calculons le biais des

deux estimateurs, le premier est biaisé, le second ne

l'est pas. Donc nous aurions tendance à n'utiliser que le

second. Que nenni! Car nous pourrions aussi parler de la variance

et de

la précision d'un estimateur, qui sont aussi des critères

importants pour juger

de la qualité d'un estimateur par rapport à un autre.

Si nous faisions le calcul de la variance des deux estimateurs,

alors

le premier,

qui est

biaisé, a une variance plus petite que le second qui est

sans biais! Tout ça pour dire que

le critère du biais n'est pas (et de loin) le seul à étudier

pour juger de la qualité d'un estimateur.

Enfin, il est important de se rappeler que le facteur -1 du dénominateur

de l'estimateur du maximum de vraisemblance non biaisé provient

du fait qu'il fallait corriger l'espérance de l'estimateur

biaisé

à la base minoré de une fois l'erreur-standard!

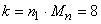

ESTIMATEURS DE LA DISTRIBUTION DE POISSON

En utilisant la même méthode que pour la loi Normale (Gauss-Laplace),

nous allons donc rechercher les estimateurs du maximum de vraisemblance

de la loi de Poisson qui rappelons-le, est donnée par:

(7.27)

(7.27)

Dès lors, la vraisemblance est donnée par:

(7.28)

(7.28)

Maximiser une fonction ou maximiser son logarithme est équivalent

donc:

(7.29)

(7.29)

Nous cherchons maintenant à la maximiser:

(7.30)

(7.30)

et obtenons donc son unique estimateur du maximum de vraisemblance

qui sera:

(7.31)

(7.31)

Il est tout à fait normal de retrouver dans cet exemple

didactique la moyenne empirique, car c'est le meilleur estimateur

possible pour le paramètre de la loi de Poisson (qui représente

aussi l'espérance d'une loi de Poisson).

Sachant que l'écart-type de cette distribution particulière

(voir plus haut lors de notre développement de la loi

de Poisson) n'est que la racine carrée

de la moyenne, nous avons alors pour l'écart-type du maximum

de vraisemblance:

(7.32)

(7.32)

Remarque:

Nous montrons de la même manière des résultats

identiques pour la loi exponentielle très utilisée

en maintenance préventive et

fiabilité!

ESTIMATEUR DE LA DISTRIBUTION BINOMIALE (ET GÉOMÉTRIQUE)

En utilisant la même méthode que pour la loi Normale (Gauss-Laplace)

et la loi de Poisson, nous allons donc rechercher l'estimateur

du maximum de vraisemblance de la loi Binomiale qui rappelons-le,

est donnée par:

(7.33)

(7.33)

Dès lors, la vraisemblance est donnée par:

(7.34)

(7.34)

Il convient de se rappeler que le facteur qui suit

le terme combinatoire exprime déjà les variables

successives selon ce que nous avons vu lors de notre étude

de la fonction de distribution de Bernoulli et de la fonction binomiale.

D'où la disparition du produit dans la dernière égalité précédente.

Maximiser une fonction ou maximiser son logarithme est équivalent

donc:

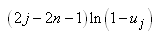

(7.35)

(7.35)

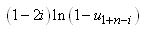

Nous cherchons maintenant à la maximiser:

(7.36)

(7.36)

Le lecteur aura peut-être remarqué que le coefficient binomial

a disparu. Dès lors, nous en déduisons immédiatement

que l'estimateur de la loi binomiale sera le même que celui

de la loi géométrique.

Ce qui donne:

(7.37)

(7.37)

d'où nous tirons l'estimateur du maximum de vraisemblance

qui sera donc la simple moyenne empirique:

(7.38)

(7.38)

Ce résultat est assez intuitif si l'on considère

l'exemple classique d'une pièce de monnaie qui a une chance

sur deux de tomber sur une de ces faces. La probabilité p étant

le nombre de fois k où une face donnée a été observée

sur le nombre d'essais total (toutes faces confondues).

Remarque: Dans la pratique, il n'est pas aussi simple

d'appliquer ces estimateurs! Il faut bien réfléchir

lesquels sont les plus adaptés à une expérience

donnée

et idéalement calculer également l'erreur quadratique

moyenne (erreur-standard) de chacun des estimateurs de la moyenne

(comme nous l'avons déjà fait pour la moyenne empirique

plus tôt). Bref c'est un long travail de réflexion.

ESTIMATEURS DE LA DISTRIBUTION DE WEIBULL

Nous avons vu dans le chapitre de Génie Industriel une étude

très détaillée de la loi de Weibull à trois

paramètres avec son écart-type

et son espérance car nous avions précisé qu'elle était

assez utilisée

dans le domaine de l'ingénierie de la fiabilité.

Malheureusement les trois paramètres de cette loi nous

sont en pratique inconnus. A l'aide des estimateurs nous pouvons

cependant déterminer l'expression de deux des trois en supposant  comme étant

nul. Cela nous donne donc la loi de Weibull dite "loi de Weibull à deux

paramètres" suivante: comme étant

nul. Cela nous donne donc la loi de Weibull dite "loi de Weibull à deux

paramètres" suivante:

(7.39)

(7.39)

avec pour rappel  et et  . .

Dès lors la vraisemblance est donnée par:

(7.40)

(7.40)

Maximiser une fonction ou maximiser son logarithme est équivalent

donc:

(7.41)

(7.41)

Cherchons maintenant à maximiser cela en se rappelant que (cf.

chapitre de Calcul Différentiel et Intégral):

et et  (7.42)

(7.42)

d'où:

(7.43)

(7.43)

Et nous avons pour le deuxième paramètre:

(7.44)

(7.44)

d'où:

(7.45)

(7.45)

Finalement avec les écritures correctes (et dans l'ordre de résolution

dans la pratique):

et et  (7.46)

(7.46)

La résolution de ces équations implique de lourds

calculs et nous ne pouvons a priori rien en tirer dans des tableurs

classiques comme Microsoft Excel ou Calc de Open Office sans

faire de la programmation.

On prend alors une approche différente en écrivant notre loi

de Weibull à deux paramètres ainsi:

(7.47)

(7.47)

avec pour rappel  et et  . .

Dès lors la vraisemblance est donnée par:

(7.48)

(7.48)

Maximiser une fonction ou maximiser son logarithme est équivalent

donc:

(7.49)

(7.49)

Cherchons maintenant à maximiser cela en se rappelant que (cf.

chapitre de Calcul Différentiel et Intégral):

et et  (7.50)

(7.50)

d'où:

(7.51)

(7.51)

Et nous avons pour le deuxième paramètre:

(7.52)

(7.52)

Il est alors immédiat que:

(7.53)

(7.53)

injecté dans la relation:

(7.54)

(7.54)

Il vient:

(7.55)

(7.55)

en simplifiant:

(7.56)

(7.56)

La résolution des deux équations (dans l'ordre de haut en bas):

(7.57)

(7.57)

peut très facilement être calculée avec l'outil

Valeur Cible de Microsoft Excel ou Calc de Open Office.

ESTIMATEURS DE LA DISTRIBUTION GAMMA

Nous allons utiliser ici une technique appelée "méthode

des moments" pour déterminer les estimateurs des

paramètres de la loi Gamma.

Supposons que X1, ..., Xn sont

des variables aléatoires indépendantes et identiquement distribuées

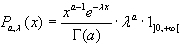

selon la loi Gamma avec pour densité:

(7.58)

(7.58)

Nous cherchons à estimer  .

Pour cela, nous déterminons d'abord quelques moments théoriques. .

Pour cela, nous déterminons d'abord quelques moments théoriques.

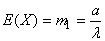

Le premier moment est l'espérance qui comme nous l'avons démontré vaut:

(7.59)

(7.59)

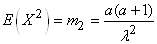

et le second moment, l'espérance du carré de la variable aléatoire,

est comme nous l'avons démontré implicitement lors de la démonstration

de la variance de la loi Gamma:

(7.60)

(7.60)

Nous exprimons ensuite la relation entre les paramètres et les

moments théoriques:

(7.61)

(7.61)

La résolution donne:

(7.62)

(7.62)

Une fois ce système établi, la méthode des moments consiste à utiliser

les moments empiriques, en l'occurrence pour notre exemple les

deux premiers,  : :

(7.63)

(7.63)

que nous posons égaux aux moments théoriques vrais... Dès lors,

il vient:

(7.64)

(7.64)

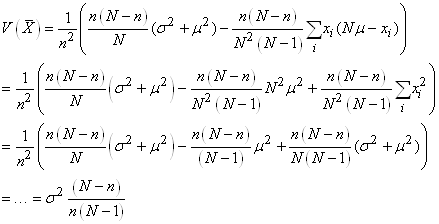

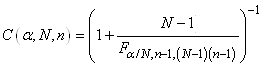

FACTEUR DE CORRECTION SUR POPULATION FINIE

Maintenant démontrons un autre résultat qui nous

sera indispensables dans certains tests statistiques que nous verrons

plus loin.

Supposons que nous avons une population de N individus

que nous représentons par l'ensemble  et

une variable aléatoire X qui est donc une application de et

une variable aléatoire X qui est donc une application de  dans dans  .

Nous posons .

Nous posons  .

La moyenne de X est alors donnée par: .

La moyenne de X est alors donnée par:

(7.65)

(7.65)

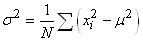

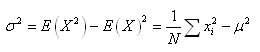

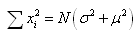

La variance de X est par définition:

(7.66)

(7.66)

Considérons à présent l'ensemble E des échantillons  de

taille n pris dans de

taille n pris dans  avec avec  .

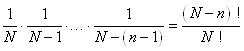

Chaque individu a une probabilité d'être tiré égale à: .

Chaque individu a une probabilité d'être tiré égale à:

(7.67)

(7.67)

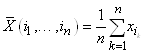

Nous nous intéressons à la variable aléatoire  définie

sur E et étant égale à la moyenne de l'échantillon. Plus

précisément: définie

sur E et étant égale à la moyenne de l'échantillon. Plus

précisément:

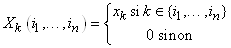

(7.68)

(7.68)

Afin de calculer la variance  ,

nous allons

exprimer ,

nous allons

exprimer  comme

somme de variables aléatoires. En effet si nous définissons les variables comme

somme de variables aléatoires. En effet si nous définissons les variables  avec avec  par: par:

(7.69)

(7.69)

Nous avons naturellement (donc de la par la définition précédente):

(7.70)

(7.70)

et donc il vient:

(7.71)

(7.71)

Les variables aléatoires  ne

sont pas indépendantes deux à deux, en effet comme nous allons

le voir, leurs covariances ne sont pas nulles si N est

fini. Dans le cas contraire (covariance nulle), nous retrouvons

un résultat déjà démontré plus haut: ne

sont pas indépendantes deux à deux, en effet comme nous allons

le voir, leurs covariances ne sont pas nulles si N est

fini. Dans le cas contraire (covariance nulle), nous retrouvons

un résultat déjà démontré plus haut:

(7.72)

(7.72)

Il nous faut donc calculer les variances  et

les covariances et

les covariances  . .

Pour ce faire nous allons utiliser la relation de Huyghens et

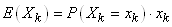

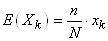

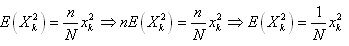

nous allons commencer par calculer l'espérance  : :

(7.73)

(7.73)

Or  est

la probabilité qu'un échantillon contienne k. Cette probabilité vaut

bien évidemment est

la probabilité qu'un échantillon contienne k. Cette probabilité vaut

bien évidemment  et

par suite: et

par suite:

(7.74)

(7.74)

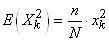

De la même façon nous obtenons:

(7.75)

(7.75)

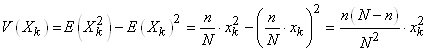

Nous pouvons donc calculer la variance  : :

(7.76)

(7.76)

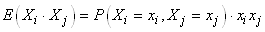

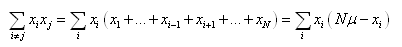

Pour calculer les covariances avons à présent besoin de calculer

les espérances  : :

(7.77)

(7.77)

Or  est

la probabilité qu'un échantillon contienne i et j.

Cette probabilité vaut bien évidemment: est

la probabilité qu'un échantillon contienne i et j.

Cette probabilité vaut bien évidemment:

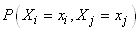

(7.78)

(7.78)

et par suite:

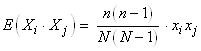

(7.79)

(7.79)

Nous pouvons à présent calculer les covariances:

(7.80)

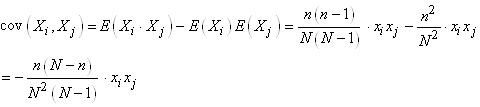

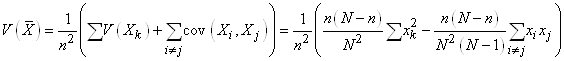

(7.80)

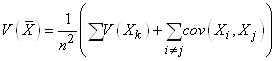

Nous sommes maintenant en mesure de calculer  : :

(7.81)

(7.81)

En utilisant le résultat démontré juste plus

haut:

(7.82)

(7.82)

et en l'injectant dans la relation de Huyghens:

(7.83)

(7.83)

nous pouvons alors écrire:

(7.84)

(7.84)

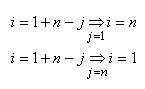

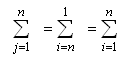

Pour la double somme  , nous avons: , nous avons:

(7.85)

(7.85)

Dès lors:

(7.86)

(7.86)

Et donc:

(7.87)

(7.87)

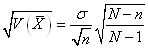

Le terme:

(7.88)

(7.88)

que nous avons déjà rencontré lors de notre étude la loi hypergéométrique

est appelé "facteur de correction sur

population finie" et il a pour effet de réduire l'erreur-standard

d'autant plus que n est grand.

INTERVALLES DE CONFIANCE

Jusqu'à maintenant nous avons toujours déterminé les différents

estimateurs de vraisemblance ou estimateurs simples (variance, écart-type) à partir

de lois (fonctions) statistiques théoriques ou mesurées sur toute

une population de données.

Définition: Un "intervalle

de confiance"

est un couple de nombres qui définit (a posteriori) une

plage de valeurs possibles avec une certaine probabilité cumulée

pour un estimateur (ponctuel) d'un indicateur statistique donné par

un échantillon

d'une expérience (plage

calculée le plus souvent à l'aide

de paramètres vrais mesurés). Il s'agit du cas le

plus fréquent

en statistiques.

Nous allons maintenant aborder qui consiste à se demander assez

naturellement quelles doivent être les tailles des échantillons

de nos données mesureés pour avoir une certaine validité (intervalle

de confiance I.C.) de nos estimateurs ou encore quel écart-type

ou fractile dans une loi Normale centrée réduite

(grand nombre d'individus), du Khi-deux, de Student ou de Fisher

correspond un certain intervalle de confiance (nous verrons ces

deux derniers cas de faibles échantillons dans la partie

traitant de l'analyse de la variance ou ANOVA) lorsque la variance

ou la moyenne est connue ou respectivement inconnue sur l'ensemble

ou une partie de la population donnée.

Indiquons que ces intervalles de confiance utilisent souvent le

théorème central limite démontré plus

loin (afin d'éviter toute frustration) et que les développements

que nous allons faire maintenant nous seront également utiles

dans le domaine des Tests d'Hypothèses qui ont une place

majeure en statistique!

Enfin, indiquons que de très nombreuses organisations (privées

ou étatiques) font des statistiques fausses car les hypothèses

et conditions d'utilisation de ces intervalles de confiance (et

in extenso les tests d'hypothèses qui en découlent) ne sont pas

rigoureusement vérifiées

ou simplement omises ou pire encore, toute la base (les mesures)

n'est pas collectée dans les règles de l'art (fiabilisation

de la collecte de données par des protocoles scientifiques

reproductibles et validés par les pairs).

Enfin, indiquons que de très nombreuses organisations

(privées

ou étatiques) font des statistiques fausses car les hypothèses

et conditions d'utilisation ne sont pas rigoureusement vérifiées

ou simplement omises ou pire encore, toute la base (les mesures)

ne sont pas collectées dans les règles de l'art (fiabilisation

de la collecte de données).

Remarque: Le praticien doit être

très prudent

quant à au

calcul des intervalles de confiance et à l'utilisation des

tests d'hypothèses

dans la pratique. Raison pour laquelle, afin d'éviter toute

erreur triviale d'utilisation ou d'interprétation, il est

important de se référer aux normes suivantes par

exemple: ISO 2602:1980 (Interprétation

statistique de résultats d'essais - Estimation de la moyenne

- Intervalle de confiance), ISO 2854:1976 (Interprétation

statistique des données - Techniques d'estimation et tests

portant sur des moyennes et des variances), ISO 3301:1975 (Interprétation

statistique des données - Comparaison de deux moyennes dans

le cas d'observations appariées), ISO 3494:1976 (Interprétation

statistique des données -- Efficacité des tests portant

sur des moyennes et des variances), ISO 5479:1997 (Interprétation

statistique des données - Tests pour les écarts à la

distribution normale), ISO 10725:2000 + ISO 11648-1:2003 + ISO 11648-2:2001

(Plans et procédures

d'échantillonnage pour acceptation pour le contrôle

de matériaux en vrac), ISO 11453:1996 (Interprétation

statistique des données - Tests et intervalles de confiance

portant sur les proportions), ISO 16269-4:2010 (Interprétation

statistique des données - Détection et traitement

des valeurs aberrantes), ISO 16269-6:2005 (Interprétation

statistique des données - Détermination

des intervalles statistiques de tolérance), ISO 16269-8:2004

(Interprétation statistique des données - Détermination

des intervalles de prédiction), ISO/TR 18532:2009 (Lignes

directrices pour l'application des méthodes statistiques à la

qualité et à la normalisation industrielle).

I.C. SUR LA MOYENNE AVEC VARIANCE THÉORIQUE CONNUE

Commençons par le cas le plus simple et le plus courant

qui est la détermination du nombre d'individus pour avoir

une certaine confiance dans la moyenne des mesures effectuées

d'une variable aléatoire supposée suivre une loi

Normale.

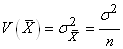

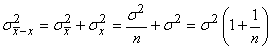

D'abord rappelons que nous avons démontré au début

de ce chapitre que l'erreur-type (écart-type à la

moyenne) était sous l'hypothèses de variables indépendantes

et identiquement distribuées (i.i.d.):

(7.89)

(7.89)

Maintenant, avant d'aller plus loin, considérons X comme

une variable aléatoire suivant une loi Normale de moyenne  et

d'écart-type et

d'écart-type  .

Nous souhaiterions que la variable aléatoire ait par exemple 95%

de probabilité cumulée de se trouver dans un intervalle symétrique

borné donné. Ce qui s'exprime donc sous la forme suivante: .

Nous souhaiterions que la variable aléatoire ait par exemple 95%

de probabilité cumulée de se trouver dans un intervalle symétrique

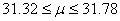

borné donné. Ce qui s'exprime donc sous la forme suivante:

(7.90)

(7.90)

Remarque: Donc

avec un intervalle de confiance de 95% vous aurez raison 19 fois

sur 20, ou n'importe quel autre niveau de confiance

ou niveau de risque  (1-niveau

de confiance, soit 5%) que vous vous serez fixé à l'avance.

En moyenne, vos conclusions seront donc bonnes, mais nous ne pourrons

jamais savoir si une décision particulière est bonne!

Si le niveau de risque est très faible mais que l'événement

a quand même lieu, les spécialistes parlent alors de " grande

déviation" ou de " black

swan" (cygne noir). La gestion des valeurs aberrantes

est traitée dans la norme ISO 16269-4:2010 Détection

et traitement des valeurs aberrantes que tout ingénieur

faisant des statistiques en entreprise se doit de respecter.

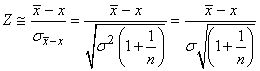

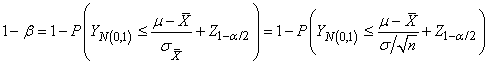

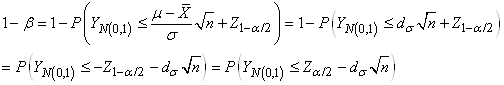

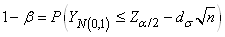

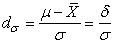

En centrant et réduisant la variable aléatoire:

(7.91)

(7.91)

Notons maintenant Y la variable centrée réduite:

(7.92)

(7.92)

Puisque la loi Normale centrée réduite est symétrique:

(7.93)

(7.93)

D'où:

(7.94)

(7.94)

A partir de là en lisant dans les tables numériques

de la loi Normale centrée réduite (ou en utilisant

un simple tableur), nous avons pour satisfaire cette égalité que:

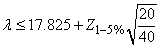

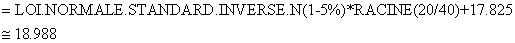

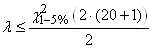

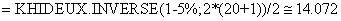

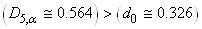

(7.95)

(7.95)

Ce qui s'obtient facilement avec la version anglaise de Microsoft

Excel 11.8346 en utilisant la fonction: -NORMSINV((1-0.95)/2).

Donc:

(7.96)

(7.96)

Ce qui est noté de façon traditionnelle dans le

cas général autre

que 95% par (Z étant la variable aléatoire

correspondant donc

à la moitié du quantile du seuil fixé de la loi Normale centrée

réduite):

(7.97)

(7.97)

Or, considérons que la variable X sur laquelle

nous souhaitons faire de l'inférence statistique est justement

la moyenne (et nous démontrerons plus loin que celle-ci

suit une loi Normale centrée

réduite). Dès

lors:

(7.98)

(7.98)

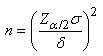

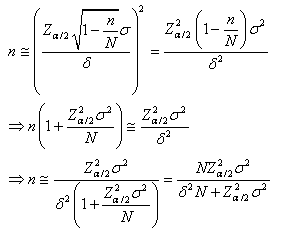

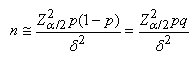

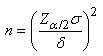

Nous en tirons la taille de l'échantillon:

(7.99)

(7.99)

dont nous prenons évidemment (normalement...) la valeur

entière

supérieure…

Cette dernière notation est plus souvent

écrite sous la forme suivante mettant mieux en évidence

la largeur de l'intervalle de confiance à un niveau  sous-jacent: sous-jacent:

(7.100)

(7.100)

Relation appelée "effectif de

l'échantillon pour estimation par loi Normale".

Ainsi, nous pouvons maintenant savoir le nombre d'individus à avoir

pour s'assurer un intervalle de précision  (marge

d'erreur) autour de la moyenne et pour qu'un pourcentage donné des

mesures se trouvent dans cet intervalle et en supposant l'écart-type

théorique (marge

d'erreur) autour de la moyenne et pour qu'un pourcentage donné des

mesures se trouvent dans cet intervalle et en supposant l'écart-type

théorique  connu

(ou imposé) d'avance (typiquement utilisé dans l'ingénierie

de la qualité ou les instituts de sondages/enquêtes). connu

(ou imposé) d'avance (typiquement utilisé dans l'ingénierie

de la qualité ou les instituts de sondages/enquêtes).

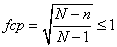

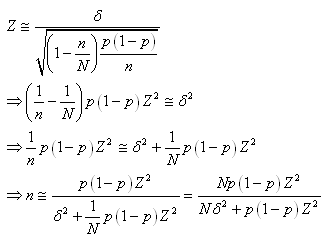

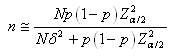

Dans le cas des sondages/enequêtes où la population n'est pass

assez grande pour considéréer que nous avons un échantillonnage

avec remise, nous parlons devons alors introduire la facteur fpc que

nous avons démontré plus haut (nous parlons alors dans PSSR pour

"plan de sondage sans remise"). Il vient alors:

(7.101)

(7.101)

Autrement dit, nous pouvons calculer le nombre n d'individus à mesurer

pour s'assurer un intervalle de confiance donné

(associé à Z) de la moyenne mesurée

en supposant l'écart-type théorique connu (ou

imposé) et en souhaitant un

précision de  en

valeur absolue sur la moyenne. en

valeur absolue sur la moyenne.

Cependant... en réalité, la variable Z provient du théorème

central limite (voir plus bas) qui donne pour un échantillon de

grande taille (approximativement):

(7.102)

(7.102)

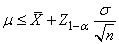

En réarrangeant nous obtenons:

(7.103)

(7.103)

et comme Z peut être négatif ou positif alors il est plus

censé d'écrire cela sous la forme:

(7.104)

(7.104)

Soit:

(7.105)

(7.105)

que les ingénieurs notent parfois:

(7.106)

(7.106)

avec LCL étant la lower confidence limit et UCL la upper confidence

limit. C'est de la terminologie Six Sigma (cf.

chapitre de Génie Industriel).

Et nous venons de voir plus avant que pour avoir un intervalle

de confiance à 95% nous devrions avoir Z=1.96.

Et puisque la loi Normale est symétrique:

(7.107)

(7.107)

Cela se note finalement:

(7.108)

(7.108)

Comme nous l'avons déjà mentionné, et nous

le démontrerons un

peu plus loin, la moyenne arithmétique centrée réduite

d'une séries de variables aléatoires indépendantes

et identiquement distribuées

de variance

fini suit asymptotiquement une loi Normale centrée réduite,

alors l'intervalle de confiance ci-dessus a une portée très

générale!

Raison pour laquelle nous parlons parfois de "d'intervalle

de confiance asymptotique de la moyenne".

Ces intervalles ont évidemment

pour origine que nous travaillons très souvent en statistiques

sur des échantillons et non sur toute la population disponible.

L'échantillonage choisi influe donc sur l'estimateur ponctuel.

Nous parlons alors de "fluctuation d'échantillonage".

Dans le cas particulier d'un I.C. (intervalle

de confiance) à 95%, la dernière relation s'écrit:

(7.109)

(7.109)

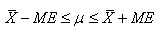

Parfois nous retrouvons l'inégalité antéprécédente sous la forme équivalente

suivante:

(7.110)

(7.110)

ou encore plus rarement sous la forme générale

suivante (que l'on retrouve pour toutes les intervalles):

(7.111)

(7.111)

où ME signifie "marge

d'erreur".

Nous sommes ainsi capables maintenant d'estimer

des tailles de population nécessaires à obtenir un

certain niveau de confiance  dans

un résultat, soit d'estimer

dans quel intervalle de confiance se trouve la moyenne théorique

en connaissant la moyenne

expérimentale (empirique) et l'estimateur du maximum de

vraisemblance de l'écart-type. Nous pouvons bien évidemment

dès lors aussi déterminer la probabilité avec

laquelle la moyenne est en dehors d'un certain intervalle... (l'un

comme l'autre étant

beaucoup utilisés dans l'industrie). dans

un résultat, soit d'estimer

dans quel intervalle de confiance se trouve la moyenne théorique

en connaissant la moyenne

expérimentale (empirique) et l'estimateur du maximum de

vraisemblance de l'écart-type. Nous pouvons bien évidemment

dès lors aussi déterminer la probabilité avec

laquelle la moyenne est en dehors d'un certain intervalle... (l'un

comme l'autre étant

beaucoup utilisés dans l'industrie).

Enfin, signalons que du résultat précédent,

nous déduisons immédiatement

par la propriété de

stabilité de la loi Normale (démontrée plus

haut) le test suivant que nous retrouvons dans de très nombreux

logiciels de statistiques:

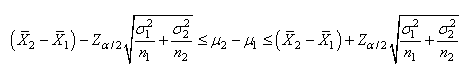

(7.112)

(7.112)

appelé "test

Z bilatéral sur

la différence de deux moyennes" avec l'intervalle de

confiance correspondant:

(7.113)

(7.113)

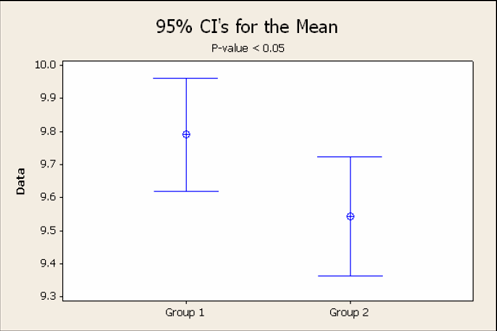

Et ce n'est pas parce que deux moyennes sont significativement

différentes que leurs intervalles de tolérance ne

se superposent pas! Comme le montre le graphique ci-dessous obtenu

avec le logiciel

Minitab 16 où le test-Z de la différence est

significative à 95%:

Figure: 7.1 - Illustration de la superposition d'intervalle de tolérance à 95%

alors que leur moyenne est significativement différente

à un seuil de confiance de 95%.

Remarque: La taille de la population

mère

pour les relations développées plus haut n'entre

pas en ligne de compte dans le calcul des intervalles de confiance

ni dans celui de la taille de l'échantillon, et pour cause,

elle est considérée infinie. Il faut donc faire attention à ne

pas avoir parfois des tailles d'échantillons qui sont plus

grandes que la population mère réelle possible...

I.C. SUR LA VARIANCE AVEC MOYENNE THÉORIQUE

CONNUE

Commençons par démontrer une propriété fondamentale

de la loi du Khi-deux:

Si une variable aléatoire X suit une loi Normale centrée

réduite  alors

son carré suit une loi du Khi-deux de degré de liberté 1: alors

son carré suit une loi du Khi-deux de degré de liberté 1:

(7.114)

(7.114)

Ce résultat est parfois appelé "statistique

de Wald" et tout test statistique l'utilisant directement

(on devrait plutôt parler de "famille de tests")

peut être rangé

sous

la dénomination

de "test de Wald" (pour un

exemple concret voir le test de Cochran-Mantel-Haenszel

dans le chapitre de Méthodes Numériques).

Démonstration:

Pour démontrer cette propriété, il suffit de calculer la densité de

la variable aléatoire  avec avec  .

Or, si .

Or, si  et

si nous posons et

si nous posons  ,

alors pour tout ,

alors pour tout  nous

obtenons: nous

obtenons:

(7.115)

(7.115)

Puisque la loi Normale centrée réduite est symétrique

par rapport à 0

pour la variable aléatoire X, nous pouvons écrire:

(7.116)

(7.116)

En notant  la

fonction de répartition de la loi Normale centrée réduite (sa probabilité cumulée

en d'autres termes pour rappel...), nous avons: la

fonction de répartition de la loi Normale centrée réduite (sa probabilité cumulée

en d'autres termes pour rappel...), nous avons:

(7.117)

(7.117)

et comme:

(7.118)

(7.118)

alors:

(7.119)

(7.119)

La fonction de répartition de la variable aléatoire

(probabilité cumulée)  est

donc donnée par: est

donc donnée par:

(7.120)

(7.120)

si y est supérieur ou égal à zéro,

nulle si y inférieur à zéro.

Nous noterons cette répartition  pour

la suite des calculs. pour

la suite des calculs.

Puisque la fonction de distribution est la dérivée de la fonction

de répartition et que X suit une loi Normale centrée réduite

alors nous avons pour la variable aléatoire X:

(7.121)

(7.121)

et il s'ensuit pour la loi de distribution de Y (qui

est donc le carré de X pour rappel!):

(7.122)

(7.122)

cette dernière expression correspond exactement à la

relation que nous avions obtenue lors de notre étude de

la loi du Khi-deux en imposant un degré de liberté unité.

Le théorème est donc bien démontré,

à savoir

que si X suit une

loi Normale centrée réduite alors son carré suit

une loi du Khi-deux à 1

degré de liberté tel que:

(7.123)

(7.123)

C.Q.F.D. C.Q.F.D.

Ce type de relation est utilisé dans les processus industriels

et leur contrôle (cf. chapitre de Génie

Industriel).

Nous allons maintenant utiliser un résultat démontré lors

de notre étude de la loi Gamma. Nous avons effectivement

vu plus haut que la somme de deux variables aléatoires suivant

une loi Gamma suit aussi une loi Gamma dont les paramètres

s'additionnent:

(7.124)

(7.124)

Comme la loi du Khi-deux n'est qu'un cas particulier de la loi

Gamma, le même résultat s'applique.

Pour être plus précis, cela revient à dire:

Si  sont

des variables aléatoires indépendantes (!) et identiquement distribuées

N(0,1) alors

par extension de la démonstration précédente

où nous avons montré que: sont

des variables aléatoires indépendantes (!) et identiquement distribuées

N(0,1) alors

par extension de la démonstration précédente

où nous avons montré que:

(7.125)

(7.125)

et de la propriété d'addition de la loi Gamma,

la somme de leurs carrés suit alors une loi du Khi-deux

de degrés de liberté k telle

que:

(7.126)

(7.126)

Ainsi, la loi du  à k degrés

de liberté est la loi de probabilité de la somme

des carrés de k variables

normales centrées réduites linéairement indépendantes

entre elles. Il s'agit de la propriété de linéarité de

la loi du Khi-deux (implicitement de la linéarité de

la loi Gamma)! à k degrés

de liberté est la loi de probabilité de la somme

des carrés de k variables

normales centrées réduites linéairement indépendantes

entre elles. Il s'agit de la propriété de linéarité de

la loi du Khi-deux (implicitement de la linéarité de

la loi Gamma)!

Maintenant voyons une autre propriété importante

de la loi du Khi-deux: Si  sont

des variables aléatoires indépendantes et identiquement

distribuées sont

des variables aléatoires indépendantes et identiquement

distribuées  (donc

de même moyenne et même écart-type et suivant une loi Normale)

et si nous notons l'estimateur du maximum de vraisemblance de la

variance: (donc

de même moyenne et même écart-type et suivant une loi Normale)

et si nous notons l'estimateur du maximum de vraisemblance de la

variance:

(7.127)

(7.127)

alors, le rapport de la variable aléatoire  sur

l'écart-type supposé connu de l'ensemble de la population

(dit "écart-type vrai" ou "écart-type

théorique" pour bien différencier!)

multiplié par

le nombre d'individus n de

la population suit une loi du Khi-deux de degré n telle

que: sur

l'écart-type supposé connu de l'ensemble de la population

(dit "écart-type vrai" ou "écart-type

théorique" pour bien différencier!)

multiplié par

le nombre d'individus n de

la population suit une loi du Khi-deux de degré n telle

que:

(7.128)

(7.128)

Ce résultat est appelé "théorème

de Cochran" ou

encore "théorème de Fisher-Cochran"

(dans le cas particulier d'échantillons gaussiens) et nous

donne donc une distribution pour les écarts-types empiriques

(dont la loi parente est une loi Normale).

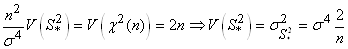

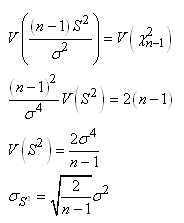

En utilisant la valeur de l'écart-type démontrée

lors de notre étude da la loi du khi-deux nous avons donc:

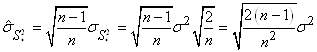

(7.129)

(7.129)

Mais n et  sont

imposés et sont donc considérés comme des constantes. Il vient

alors: sont

imposés et sont donc considérés comme des constantes. Il vient

alors:

(7.130)

(7.130)

Et dès lors nous avons une expression de l'écart-type de l'écart-type

empirique si nous connaissons l'écart-type de la population:

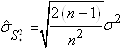

(7.131)

(7.131)

Mais nous avons démontré lors de notre étude des estimateurs

que:

(7.132)

(7.132)

Dès lors il vient que:

(7.133)

(7.133)

Il en découle donc la relation parfois importante

dans la pratique de l'estimateur de l'écart-type de.... l'écart-type:

(7.134)

(7.134)

Rappelons que la population parente est dite "infinie" si

le tirage de l'échantillon est avec remise ou encore si la taille N de

la population parente est très supérieure à celle de n de

l'échantillon.

Remarques:

R1. En laboratoire, les  peuvent être

vues comme une classe d'individus d'un même produit étudié identiquement

par différentes équipes de recherche avec des instruments

de même

précision (écart-type de mesure identique). peuvent être

vues comme une classe d'individus d'un même produit étudié identiquement

par différentes équipes de recherche avec des instruments

de même

précision (écart-type de mesure identique).

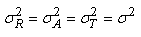

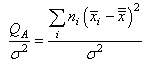

R2.  est

la "variance interclasse" également

appelée "variance expliquée".

Donc elle donne la variance d'une mesure ayant eu lieu dans les

différents laboratoires. est

la "variance interclasse" également

appelée "variance expliquée".

Donc elle donne la variance d'une mesure ayant eu lieu dans les

différents laboratoires.

Ce qui est intéressant c'est qu'à partir du calcul de la loi

du Khi-deux en connaissant n et l'écart-type  il

est possible d'estimer cette variance (écart-type) interclasse. il

est possible d'estimer cette variance (écart-type) interclasse.

Pour voir que cette dernière propriété est une généralisation élémentaire

de la relation:

(7.135)

(7.135)

il suffit de constater que la variable aléatoire  est

une somme de n carrés de N(0,1) indépendants les

uns des autres. Effectivement, rappelons qu'une variable aléatoire

centrée réduite (voir notre étude de la loi Normale) est donnée

par: est

une somme de n carrés de N(0,1) indépendants les

uns des autres. Effectivement, rappelons qu'une variable aléatoire

centrée réduite (voir notre étude de la loi Normale) est donnée

par:

(7.136)

(7.136)

Dès lors:

(7.137)

(7.137)

Or, puisque les variables aléatoires  sont

indépendantes et identiquement distribuées selon une loi

Normale, alors les variables aléatoires: sont

indépendantes et identiquement distribuées selon une loi

Normale, alors les variables aléatoires:

(7.138)

(7.138)

sont aussi indépendantes et identiquement distribuées mais selon

une loi Normale centrée réduite.

Puisque:

(7.139)

(7.139)

en réarrangeant nous obtenons:

(7.140)

(7.140)

Donc sur la population de mesures, l'écart-type vrai suit

la relation donnée ci-dessus. Il est donc possible de faire

de l'inférence

statistique sur l'écart-type lorsque la moyenne théorique

est connue (...).

Puisque la fonction du Khi-deux n'est pas symétrique,

la seule possibilité pour faire l'inférence c'est

de faire appel au calcul numérique et nous noterons alors

l'intervalle de confiance à 95%

(par exemple...) de la manière suivante:

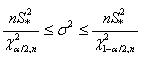

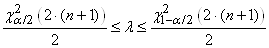

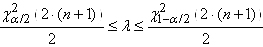

(7.141)

(7.141)

Soit en notant  : :

(7.142)

(7.142)

le dénominateur étant alors bien évidemment

le quantile de la loi du khi-2.

Cette relation est rarement utilisée dans la pratique car

la moyenne théorique n'est pas connue. Indiquons, aussi,

qu'afin d'éviter toute confusion, cette dernière

relation est souvent notée

sous la forme suivante:

(7.143)

(7.143)

Voyons donc le cas le plus courant:

I.C. SUR LA VARIANCE AVEC MOYENNE EMPIRIQUE

Cherchons maintenant à faire de l'inférence statistique lorsque

la moyenne théorique de la population  n'est

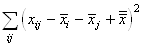

pas connue. Pour cela, considérons maintenant la somme: n'est

pas connue. Pour cela, considérons maintenant la somme:

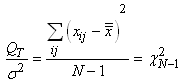

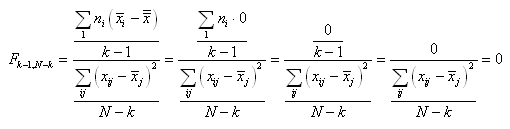

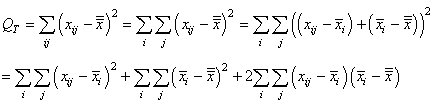

(7.144)

(7.144)

où pour rappel est

la moyenne empirique (arithmétique) de l'échantillon: est

la moyenne empirique (arithmétique) de l'échantillon:

(7.145)

(7.145)

En continuant le développement nous avons:

(7.146)

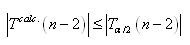

Or, nous avons démontré au début de ce chapitre que la somme

des écarts à la moyenne était nulle. Donc:

(7.147)

et reprenons l'estimateur sans biais de la loi Normale (nous

changeons de notation pour respecter les traditions et bien différencier

la moyenne empirique de la moyenne théorique):

(7.148)

(7.148)

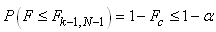

Dès lors:

(7.149)

(7.149)

ou autrement écrit:

(7.150)

(7.150)

Puisque le deuxième terme (au carré) suit une loi

Normale centrée

réduite aussi, alors si nous le supprimons nous obtenons

de par la propriété démontrée plus

haut de la loi du Khi-deux:

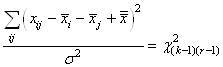

(7.151)

(7.151)

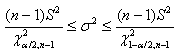

Ces développements nous permettent cette fois-ci de faire aussi

de l'inférence sur la variance  d'une

loi d'une

loi  lorsque

les paramètres lorsque

les paramètres  et et  sont

tous les deux inconnus pour l'ensemble de la population. C'est

ce résultat qui nous donne, par exemple, l'intervalle de confiance: sont

tous les deux inconnus pour l'ensemble de la population. C'est

ce résultat qui nous donne, par exemple, l'intervalle de confiance:

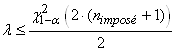

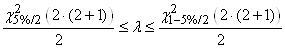

(7.152)

(7.152)

lorsque la moyenne théorique  est

donc inconnue. Et à aussi, pour éviter tout confusion, il est plutôt

d'usage d'écrire: est

donc inconnue. Et à aussi, pour éviter tout confusion, il est plutôt

d'usage d'écrire:

(7.153)

(7.153)

De la même manière que plus haut, nous pouvons calculer

l'écart-type

de l'écart-type et qui a une grande importance dans la pratique

de la finance:

(7.154)

(7.154)

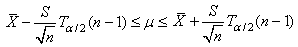

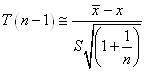

I.C. SUR LA MOYENNE AVEC VARIANCE EMPIRIQUE CONNUE

Nous avons démontré beaucoup plus haut que la loi de Student

provenait de la relation suivante:

(7.155)

(7.155)

si Z et U sont des variables aléatoires indépendantes

et si Z suit une loi Normale centrée réduite N(0,1)

et U une loi du Khi-deux  tel

que: tel

que:

(7.156)

(7.156)

et rappelons que la fonction de densité (distribution) est symétrique!

Voici une application très importante du résultat

ci-dessus:

Supposons que  constituent

un échantillon aléatoire de taille n issu de la loi constituent

un échantillon aléatoire de taille n issu de la loi  .

Alors nous pouvons déjà écrire que selon les développements faits

plus haut: .

Alors nous pouvons déjà écrire que selon les développements faits

plus haut:

(7.157)

(7.157)

Et pour U qui suit une loi  ,

si nous posons ,

si nous posons  alors

selon les résultats obtenus plus haut: alors

selon les résultats obtenus plus haut:

(7.158)

(7.158)

Nous avons alors après quelques simplifications triviales:

(7.159)

(7.159)

Donc puisque:

(7.160)

(7.160)

suit une loi de Student de paramètre k alors nous

obtenons le "independant one-sample t-test" (en

anglais) ou "test-T à 1 échantillon":

(7.161)

(7.161)

qui suit aussi une loi de Student de paramètre n-1

et qui est très utilisé dans les laboratoires pour

les tests d'étalonnages.

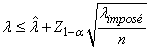

Ce qui nous donne aussi après réarrangement:

(7.162)

(7.162)

Ce qui nous permet de faire de l'inférence sur la moyenne  d'une

loi Normale d'écart-type théorique inconnu (sous-entendu

qu'il n'y a pas assez de valeurs expérimentales) mais dont

l'estimateur sans biais de l'écart-type

est connu. C'est ce résultat

qui nous donne l'intervalle de confiance: d'une

loi Normale d'écart-type théorique inconnu (sous-entendu

qu'il n'y a pas assez de valeurs expérimentales) mais dont

l'estimateur sans biais de l'écart-type

est connu. C'est ce résultat

qui nous donne l'intervalle de confiance:

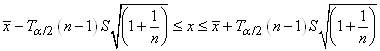

(7.163)

(7.163)

où nous retrouvons les mêmes indices que pour l'inférence

statistique sur la moyenne (espérance) d'une variable aléatoire

d'écart-type (théorique)

connu puisque la loi de Student tend asymptotiquement pour de grandes

valeurs de n vers une loi Normale. Ainsi, l'intervalle

précédent et l'intervalle suivant:

(7.164)

(7.164)

donneront des valeurs très proches (à la troisième

décimale)

pour des grandeurs de n aux

alentours des 10'000 (dans la pratique on considère qu'à partir

de 100 c'est identique...).

Nous déduisons immédiatement par la

propriété de

stabilité de la loi du Khi-deux (démontrée

plus haut par le fait qu'elle découle de la loi Gamma) le

test suivant que nous retrouvons dans de très

nombreux logiciels de statistiques:

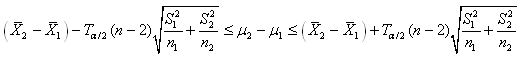

(7.165)

(7.165)

appelé "test-T (de

Student) bilatéral

sur la différence de deux moyennes" (rigoureusement...

sommer les degrés de liberté comme nous venons de le faire n'est

valable que si les deux variances sont égales et nous démontrerons

le cas général où les variances ne sont pas égales lors de la

démonstration du test de Welch plus loin).

Nous pouvons bien évidemment dès lors aussi

déterminer

la probabilité avec laquelle la moyenne est dedans ou en

dehors d'un certain intervalle... (l'une comme l'autre étant

beaucoup utilisées dans l'industrie).

Le lecteur pourra s'amuser à contrôler avec la version

française de Microsoft Excel 11.8346 que pour

un grand nombre de mesures n,

la loi de Student tend vers la loi Normale centrée réduite

en comparant les valeurs des deux fonctions ci-dessous:

=LOI.STUDENT.INVERSE.N(5%/2;n-1)

=LOI.NORMALE.STANDARD.INVERSE.N(5%/2)

Remarque: Le

résultat précédent fut obtenu par William

S. Gosset aux alentours de 1910. Gosset qui avait étudié la

mathématique et la chimie,

travaillait comme statisticien pour la brasserie Guinness en Angleterre. À l'époque,

on savait que si  sont

des variables aléatoires indépendantes et identiquement

distribuées

alors:

(7.166)

(7.166)

Toutefois, dans les applications statistiques on s'intéressait

bien évidemment plutôt à la quantité:

(7.167)

(7.167)

On se contentait alors de supposer que cette quantité suivait à peu

près une loi Normale centrée réduite ce qui

n'était pas une mauvaise

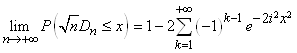

approximation comme le montre l'image ci-dessous ( ): ):

Figure: 7.2 - Comparaison entre la fonction de distribution Normale et celle de

Student

Suite à de nombreuses simulations, Gosset arriva à la conclusion

que cette approximation était valide seulement lorsque n est

suffisamment grand (donc cela lui donnait l'indication comme quoi

il devait y avoir quelque part derrière le théorème central limite).

Il décida de déterminer l'origine de la distribution et après avoir

suivi un cours de statistique avec Karl Pearson il obtint son fameux

résultat qu'il publia sous le pseudonyme de Student. Ainsi, on

appelle loi de Student la loi de probabilité qui aurait dû être

appelée la loi ou fonction de Gosset.

Signalons enfin que le test de Student est aussi très utilisé pour

identifier si des variations (progressions

ou l'inverse) de la moyenne des chiffres de deux

populations identiques sont statistiquement significatives. C'est-à-dire

que si la taille de deux échantillons dépendants

est identique alors nous pouvons créer le test suivant (nous

avons indiqué tous

les différents types d'écritures que l'on peut retrouver

dans la littérature et dans les nombreux logiciels implémentant

ce test):

(7.168)

(7.168)

Avec:

(7.169)

(7.169)

La relation antéprécédente

est donc très

utile pour comparer deux fois le même échantillon

dans des situations différentes de mesure (ventes avant

ou après

rabais d'un article par exemple). La relation antéprécédente

est appelée "test-T (de

Student) de deux moyennes d'échantillons appariés

(ou échantillons dépendants)" ou

plus simplement "test-T de Student pour

échantillons appariés".

Définition: Nous parlons

"d'échantillons appariés"

(par paires) si les échantillons de valeurs sont prises

2 fois sur les mêmes

individus (donc les valeurs des paires ne sont pas indépendantes,

contrairement à deux échantillons pris indépendamment).

TEST BINOMIAL EXACT

Il arrive fréquemment lors de mesures que l'on souhaite

comparer si deux échantillons de petite taille pris au hasard

(sans remise!) d'une population elle aussi petite... sont statistiquement

significativement différents ou non alors que l'on attendait

une égalité parfaite!

Nous cherchons donc un test adapté aux cas suivants:

- Savoir si un échantillon d'une population préfère

utiliser une technique de travail plutôt qu'une autre alors

que l'on s'attend à ce que la population utilise autant

l'une que l'autre

- Savoir si un échantillon d'une population a une caractéristique

prédominante parmi deux possibilités alors que l'on

s'attend à ce que la population soit parfaitement équilibrée

Avant d'aller plus en détails, rappelons qu'il faut être

extrêmement prudent quant à la manière d'obtenir

les deux échantillons. Il faut que l'expérience soit

non biaisée, cela signifie pour rappel, que le protocole

de tirage ne doit en aucun cas avantager l'une au l'autre des caractéristiques

de la population (si vous étudiez l'équilibre homme/femme

dans une population en attirant dans le sondage des personnes grâce à un

cadeau sous la forme de bijoux ou en appelant pandans les jours

ouvrés vous aurez alors un échantillon

biaisé... car vous aurez probablement naturellement plus

de femmes que d'hommes...).

Ceci étant dit, cette situation correspond donc à une

loi binomiale pour laquelle nous avons démontré plus

haut dans ce chapitre que la probabilité de k réussites

pour une population de taille N dont la probabilité de

réussite

est p (et la probabilité d'échec

q donc de 1 - p) était donnée par

la relation:

(7.170)

(7.170)

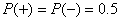

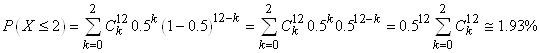

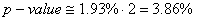

Dans le cas qui nous intéresse, nous avons donc  : :

(7.171)

(7.171)

tout en

se rappelant que la distribution ne sera pas pour autant symétrique

et ce surtout si la taille N de la population est petite.

Si nous notons maintenant x le nombre de réussites

(considéré comme la taille du premier échantillon)

et y le

nombre d'échecs (considéré comme la taille

du deuxième échantillon), nous avons alors:

(7.172)

(7.172)

Ceci étant fait, pour construire le test et de par l'asymétrie

de la distribution, nous allons calculer la probabilité cumulée

que k soit plus petit que le x obtenu par l'expérience

et la sommer à la probabilité cumulée pour

que

k soit plus grand que le y obtenu par l'expérience

(ce qui correspond à la probabilité cumulée

des queues respectivement gauche et droite de la distribution).

Cette somme correspond donc à la probabilité:

(7.173)

(7.173)

et cette dernière relation est appelée "test

binomial exact (bilatéral)".

Si la probabilité P obtenue pour la somme est

au-dessus d'une certaine probabilité cumulée fixée à l'avance,

nous dirons alors que la différence avec un échantillon

tiré au hasard dans une population parfaitement équilibrée

n'est pas statistiquement significative (en bilatéral...)

et respectivement si elle est en-dessous, la différence

sera donc statistiquement significative et nous rejetterons l'équilibre

supposé.

Ainsi,si:

(7.174)

(7.174)

la différence par rapport à une population équilibrée

sera considérée comme non statistiquement significative.

Souvent on prendra au maximum  comme valant 5% (mais rarement en-dessous) ce

qui correspond donc à un intervalle de confiance de 95%.

comme valant 5% (mais rarement en-dessous) ce

qui correspond donc à un intervalle de confiance de 95%.

Malheureusement d'un logiciel de statistiques à l'autre

les paramètres demandés ou les résultats obtenus

ne seront pas nécessairement les mêmes (les tableurs

n'intègrent pas de fonction spécifique pour le test

binomial, il faudra souvent construire un tableau ou programmer

soi-même la fonction). Par exemple, certains logiciels calculent

systématiquement et imposent (ce qui est assez logique dans

un sens...):

(7.175)

(7.175)

Exemple: Exemple:

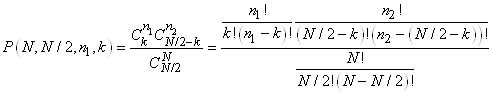

D'une petite population ayant deux caractéristiques x et

y particulières qui nous intéressaient et

pour laquelle nous nous attendions à avoir un parfait équilibre

tel que  mais

nous avons en réalité obtenu mais

nous avons en réalité obtenu  et et

.

Nous souhaiterions faire le calcul avec Microsoft Excel 11.8346 pour savoir

si cette différence

est statistiquement significative ou non à un niveau de 5%? .

Nous souhaiterions faire le calcul avec Microsoft Excel 11.8346 pour savoir

si cette différence

est statistiquement significative ou non à un niveau de 5%?

Pour répondre à cette question, nous allons

donc calculer la probabilité cumulée:

(7.176)

(7.176)

ce qui nous donne:

Figure: 7.3 - Valeurs du calcul des coefficients binomiaux dans Microsoft Excel 11.8346

soit explicitement:

Figure: 7.4 - Formules du calcul des coefficients binomiaux dans Microsoft Excel 11.8346

donc la probabilité cumulée étant

de 0.774 (soit 77.4%) la différence

par rapport à une population équilibrée sera

considérée donc comme non statistiquement significative.

Remarque: Ce test est également

utilisé par la majorité

des logiciels de statistiques (comme Minitab) pour donner un intervalle

de confiance

de la conformité d'opinions par rapport à celle d'un

expert. C'est ce que nous appelons une étude R&R (reproductabilité & répétabilité)

par attributs (voir mon livre sur Minitab pour un exemple).

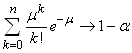

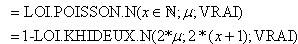

I.C. POUR UNE PROPORTION

Indiquons que certains statisticiens utilisent le fait que la

loi Normale découle de la loi de Poisson qui elle-même découle

de la loi Binomiale (nous l'avons démontré lorsque n tend

vers l'infini et que p et q sont du même ordre)

pour faire un intervalle de confiance dans le cadre de l'analyse

de proportions (très utilisé dans l'analyse

de la qualité dans les industries).

Pour voir cela, notons  la

variable aléatoire définie par: la

variable aléatoire définie par:

(7.177)

(7.177)

où l'attribut A peut être la propriété "défectueux" ou "non

défectueux" par exemple pour une analyse de pièces. Nous noterons k le

nombre de réussites de l'attribut A.

La variable aléatoire  nous

l'avons démontré au début de ce chapitre, suit une loi Binomiale

de paramètres n et p avec les moments: nous

l'avons démontré au début de ce chapitre, suit une loi Binomiale

de paramètres n et p avec les moments:

(7.178)

(7.178)

Ceci étant, nous ne connaissons pas la valeur vraie de p.

Nous allons donc utiliser l'estimateur de la loi Binomiale démontré plus

haut:

(7.179)

(7.179)

D'après les propriétés de l'espérance nous avons alors:

(7.180)

(7.180)

Et nous avons d'après les propriétés de la variance, la relation

suivante pour la variance de la moyenne empirique de la proportion:

(7.181)

(7.181)

Ce qui nous amène alors à:

et et  (7.182)

(7.182)

Maintenant rappelons enfin que nous avons démontré que

la loi Normale découlait de la loi Binomiale sous certaines

conditions (les praticiens admettent que c'est applicable tant

que n>50

et  ).

Autrement dit, que la variable aléatoire X suivant

une loi Binomiale suit une loi Normale sous certaines conditions. Évidemment,

si X suit une loi Normale alors X/n aussi

(et donc ).

Autrement dit, que la variable aléatoire X suivant

une loi Binomiale suit une loi Normale sous certaines conditions. Évidemment,

si X suit une loi Normale alors X/n aussi

(et donc  ...).

Dès lors nous pouvons centrer et réduire ...).

Dès lors nous pouvons centrer et réduire  afin

qu'il se comporte comme la variable aléatoire Normale centrée

réduite notée Z: afin

qu'il se comporte comme la variable aléatoire Normale centrée

réduite notée Z:

(7.183)

(7.183)

Exemples: Exemples:

E1. Si 5% de la production annuelle d'une entreprise est défectueuse,

quelle est la probabilité qu'en prenant un échantillon

de 75 pièces

de la ligne de production que seulement 2% ou moins soit défectueux?

Nous avons dès lors avec:

(7.184)

(7.184)

La probabilité cumulée correspondante à cette

valeur de la variable aléatoire est avec la version anglaise

de Microsoft Excel 11.8346:

=NORMSDIST(-1.19)=11.66%

Mais remarquez que nous n'avons pas  qui

est satisfait donc normalement il est exclu d'utiliser ce résultat. qui

est satisfait donc normalement il est exclu d'utiliser ce résultat.

E2. Dans son rapport de 1998, la banque J.P. Morgan a expliqué que

durant l'année 1998 ses pertes allèrent au-delà de

la Value at Risk (cf. chapitre d'Économie) 20 jours sur

les 252 jours ouvrés de l'année en se basant sur

une VaR temporelle de 95% (donc 5% des journées ouvrées

considérées comme à perte). Au seuil de 95%

est-ce de la malchance ou est-ce que le modèle de VaR utilisé était

mauvais?

(7.185)

(7.185)

Donc c'était juste de la malchance.

Nous pouvons maintenant approximer l'intervalle de confiance pour

la proportion en se basant sur la loi Binomiale et son comportement

asymptotiquement

Normal dans les conditions démontrées lors de notre

introduction de la loi Normale tel que nous avons le "test Z à

une proportion" ou "test p à

une proportion" (dans le marketing appelée "test

A/B"):

(7.186)

(7.186)

Avant de passer à un exemple, il est peut-être

utile de préciser au lecteur que cette approximation par

une loi Normale est très courante et que nous allons la

rencontrer encore de nombreuse fois dans les démonstrations

qui vont suivre. C'est tellement courant qu'on a même donné un

nom à cette méthode...:

la "méthode de Wald" (bon

en réalité il y a plusieurs méthodes

de Wald mais c'est la plus connue que nous utiliserons à chaque

fois).

Exemple: Exemple:

Prenons  ,

nous avons alors: ,

nous avons alors:

(7.187)

(7.187)

Sur une production de 300 éléments nous en avons trouvé 8 qui étaient

défectueux. Quel est donc l'intervalle de confiance?

Nous vérifions d'abord avec:

(7.188)

(7.188)

que:

(7.189)

(7.189)

Donc il est acceptable d'utiliser l'intervalle de confiance par

la loi Normale. Nous avons dès lors:

(7.190)

(7.190)

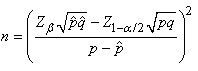

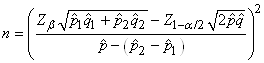

Pour clore ce sujet, nous pouvons évidemment nous intéresser

aussi au nombre d'individus (taille d'échantillon) qu'il faut avoir

pour satisfaire une certaine précision d'intervalle de confiance

(imposé)

en ayant un écart-type imposé.

Nous avons donc selon les hypothèses susmentionnées et dans l'acceptation

de l'approximation par une loi Normale que:

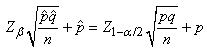

(7.191)

(7.191)

Et en procédant de manière identique aux développements effectués

plus haut avec la loi Normale, nous obtenons:

(7.192)

(7.192)

dont nous prenons évidemment normalement la valeur entière

supérieure

dans la pratique...

Einfin, faisons une petite excursion dans la théorie des

sondages/enquêtes par rapport à une relation que nous

retrouvont souvent dans la littérature spécialisée.

Si la taille de la population est petite telle que le système

ne peut pas

être

considéré avec

remise,

nous

utilisons

alors le facteur fpc démontré plus tôt.

Nous avons alors:

(7.193)

(7.193)

Soit:

(7.194)

(7.194)

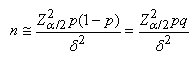

Une question qui revient souvent dans la pratique concerne le

fait de savoir s'il faut appliquer ce test en unilatéral

ou bilatéral.

Au fait il n'y a pas de réponse précise, tout dépend

de ce que nous cherchons à mettre en évidence.

Remarque: La taille de la population

mère pour les relations

développées plus haut n'entre pas en ligne

de compte dans le calcul des intervalles de confiance

ni dans celui de la taille de l'échantillon, et pour

cause, elle est considérée infinie. Il faut donc faire

attention

à ne pas avoir parfois des tailles d'échantillons qui

sont plus grandes que la population mère réelle possible...

Exemple: Exemple:

Nous souhaiterions savoir le nombre d'individus (taille d'échantillon) à prendre

d'un lot de production sachant que la proportion de défectueux

est imposée à 30% avec une erreur tolérée

d'environ 5% entre la proportion réelle et empirique et

ce afin d'obtenir un intervalle de confiance à un niveau

de 95% du résultat:

(7.195)

(7.195)

Remarque: La dernière relation est

très très souvent utilisée

en théorie des sondages (analyses pour des votations avec réponses

de type: Oui/Non) où parfois la taille de l'échantillon n est

imposée pour des raisons de coûts du sondage et dont nous cherchons à calculer

l'incertitude  et

parfois l'inverse (l'incertitude est imposée et donc nous cherchons à connaître

la taille de l'échantillon).

TEST DE L'ÉGALITÉ DE DEUX PROPORTIONS

Toujours dans le même contexte que l'approximation précédente

de la loi Binomiale par une loi Normale, l'industrie (en particulier

la biostatistique) est friande de comparer deux proportions de

deux populations différentes afin de savoir si elles sont

statistiquement égales

ou non (autrement dit: statistiquement significativement différentes

ou pas).

Dès lors rappelons que nous avons démontré la stabilité de la

loi Normale si deux variables aléatoires étaient indépendantes

et identiquement distribuées (selon une loi Normale donc!):

(7.196)

(7.196)

Dans le cadre des hypothèses susmentionnées il en est alors de

même approximativement pour la différence de deux proportions:

(7.197)

(7.197)

Remarque: Dans le domaine médical

où chacune des proportions

ci-dessus représente respectivement le risque avec traitement

et sans traitement nous parlons de " Risk

Difference" et

nous notons la différence  .

Si la différence est pare exemple de -5% cela signifie que nous

pouvons sauver 5% des patients. En plus, le corps médical introduit

aussi la notion de N.N.T. pour " Number

Needed to Treat" comme étant

le ration 1/ RD qui donne donc le nombre moyen de patient

à traiter pour éviter un événement indésirable. Ainsi avec 5% de

RD (en valeur absolue), nous devons traiter 20 patients

pour en sauver 1 statistiquement parlant.

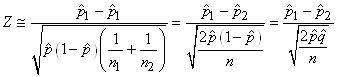

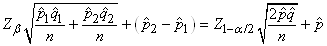

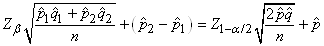

Dès lors nous savons que cette nouvelle variable centrée réduite

suit une loi Normale selon:

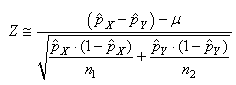

(7.198)

(7.198)

et comme nous cherchons à savoir la probabilité cumulée que l'espérance

théorique de la différence est nulle, cette dernière relation se

réduit alors dans ce cas à:

(7.199)

(7.199)

Évidemment nous pouvons aussi construire (comme toujours...)

un intervalle de confiance à partir de cette relation.

Remarque: Attention! Le test de la

différence

de deux proportions de deux échantillons différents

n'est évidemment pas le même que le test de la différence

de deux proportions dans un même échantillon (covariance

oublige puisque les deux proportions ne sont dès lors plus

indépendantes)! Dans le dernier cas nous utilisons le test

de McNemar (cf. chapitre de Méthodes Numériques)

Il semblerait cependant que cette dernière relation approximative

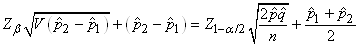

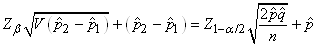

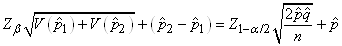

serait d'après l'expérience plus correcte en prenant pour dénominateur:

(7.200)

(7.200)

où  sera

pris comme le mélange de deux populations. C'est-à-dire: sera

pris comme le mélange de deux populations. C'est-à-dire:

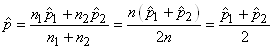

(7.201)

(7.201)

soit (en changeant la notations des indices des proportions

expérimentales):

(7.202)

(7.202)

Ce test est aussi appelé "test

Z de l'égalité de deux proportions".

En médecine, on appelle cela le "test

des différences de risque" (en sous-entendant

que chaque proportion est une catégorie de population étudiée

par rapport

à un événement indésirable).

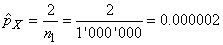

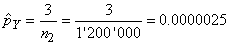

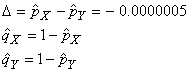

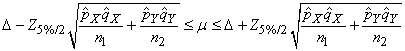

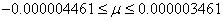

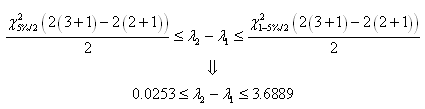

Exemple: Exemple:

Dans le cadre d'un plan d'échantillonnage (cf.

chapitre de Génie

Industriel) nous avons prélevé sur un premier

lot de 50 individus, 48 en parfait états. Dans un second

lot de 30 individus, 26 étaient

en bon état.

Nous avons donc:

(7.203)

(7.203)

Nous souhaiterions donc savoir si la différence est statistiquement

significative avec une certitude de 95% ou simplement due au hasard.

Nous utilisons

alors:

(7.204)

(7.204)

et:

(7.205)

(7.205)

Ce qui correspond à une probabilité cumulée

en utilisant la version anglaise de Microsoft Excel 11.8346 de:

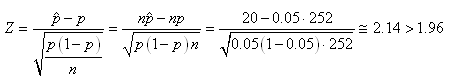

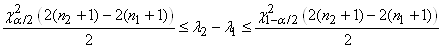

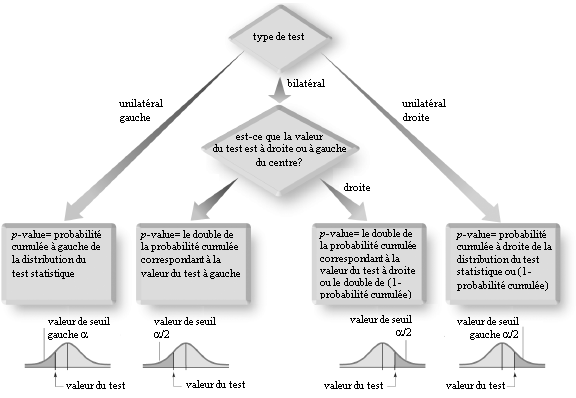

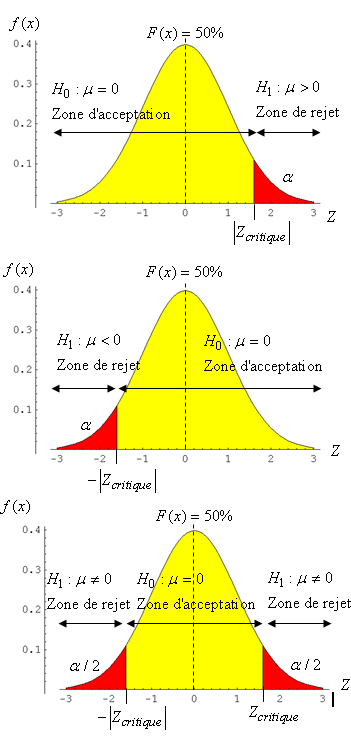

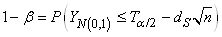

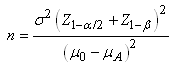

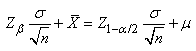

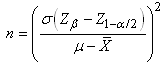

=NORMSDIST(1.535)=93.77%