|

GÉNIE MARIN & MÉTÉO | GÉNIE

MÉCANIQUE | GÉNIE ÉLECTRIQUE

GÉNIE ÉNERGÉTIQUE| GÉNIE

CIVIL | GÉNIE BIOLOGIQUE | GÉNIE AÉRONAUTIQUE

GÉNIE SPATIAL | GÉNIE

CHIMIQUE | GÉNIE INDUSTRIEL

Dernière

mise-à-jour de ce chapitre:

08.08.2010 20:15

Version: 1.3 Revision 9 | Rédacteur: Vincent Isoz | Avancement: ~60%

LISTE

DES SUJETS TRAITÉS SUR CETTE PAGE LISTE

DES SUJETS TRAITÉS SUR CETTE PAGE

Le génie industriel englobe la conception, l'amélioration

et l'installation

de systèmes. Il utilise les connaissances provenant des sciences mathématiques,

physiques et sociales, ainsi que les principes et méthodes propres à l'art

de l'ingénieur, dans le but de spécifier, prédire et évaluer

les résultats découlant de ces systèmes.

Nous pouvons résumer tous les domaines qui touchent au génie

industriel (et pas seulement.... cela peut s'appliquer avec adaptation ad hoc

à l'administration) par l'objectif d'optimiser et contrôler

les performances globales de l'entreprise (coûts, délais, qualité)

car:

On ne peut améliorer que ce que l'on mesure!

Remarquons que certaines techniques de génie industriel ont déjà été abordées

dans d'autres chapitres comme les techniques de gestion quantitatives, l'optimisation

(recherche opérationelle), l'analyse financière, l'analyse des

files d'attentes, et autres...

Danc ce chapitre nous traiterons uniquement des deux aspects du SQC (Statistical

Quality Control) soit du contrôle statistique de la qualité (dont

c'est le métier du "qualiticien") dans

le cadre de la fabrication et de la mise en production de biens ou de services.

Selon l'utilisation nous distinguons trois domaines principaux qui dans l'ordre

conventionnel sont:

1. Contrôle statistique de processus, surveillance de fabrication ou

réglage de qualité (Statistical

Process Control, SPC). Il s'agit de la surveillance d'un processus de fabrication

pendant la production de produits de masse, pour découvrir des différences

de qualité et pour pouvoir intervenir et conduire directement.

2. Contrôle de réception ou examen d'échantillon de réception

(Acceptance Sampling, AC). Il s'agit du contrôle d'entrée, d'un

contrôle pendant la production et d'un contrôle final des

produits dans une entreprise (ou usine) sans influence directe sur la production.

Ainsi le montant

de rebut produit est mesuré. Le contrôle initial sert aussi à refuser

la marchandise arrivante. Elle

n'influence par conséquent la production que de manière indirecte.

3. Maintenance préventive et contrôle du veilissement et de la

défaillance et impacts critiques (Analyse des Modes de Défaillances,

de leurs Effets et de leur Criticité, AMDEC). Il s'agit principalement

de calculer la durée de vie de composants ou de machines afin de prévoir

des remplacements à l'avance et les actions y relatives à mener

pour éviter

les situations critiques humaines ou financières.

Indiquons que depuis la fin du 20ème siècle, il est à la

mode de regrouper les deux premiers points dans une méthodologie de

travail appelée "Six Sigma" que nous allons aborder immédiatement.

Enfin, signalons que dans la pratique, pour avoir un intérêt de la direction

d'une entreprise, il faut toujours trouver une relation quantitative entre

non-qualité et les coûts pour pouvoir faire bouger les choses...

SIX SIGMA

Six Sigma est à l'origine une démarche qualité limitée dans un premier temps

aux techniques de "maîtrise statistique des procédés" (M.S.P.)

appelée aussi "statistiques des processus

qualité" (S.P.Q. ou S.P.C. en anglais pour Statistical Process

Control).

C'est une méthodologie de travail utile pour satisfaire

les clients dont l'idée est de délivrer des produits/services

de qualité, sachant que la qualité est inversement

proportionnelle à la variabilité. Par ailleurs, l'introduction

de la qualité doit être optimisée afin de ne pas trop

augmenter les coûts.

Le jeu subtil entre ces deux paramètres (qualité/coûts)

et leur optimisation conjointe est souvent associé au terme de "Lean

management". Si nous y intégrons Six Sigma, nous parlons

alors de "Lean

Six Sigma".

Six Sigma intégre tous

les aspects de la maîtrise de la variabilité en entreprise

que ce soit au niveau de la production, des services, de l'organisation

ou de la gestion

(management). D'où son intérêt! Par ailleurs, dans Six

Sigma un défaut doit

être paradoxalement la bienvenue car c'est une source de progrès

d'un problème

initialement caché. Il faut ensuite se poser plusieurs fois la question "Pourquoi?"

(traditionnellement 5 fois) afin de bien remonter à la source de celui-ci.

Nous distinguons deux types de variablité dans la pratique:

- La "variabilité inhérente" au

processus (et peu modifiable) qui induit la notion de distribution des mesures

(le plus souvent admise par les entreprises comme étant une loi Normale).

- La "variabilité externe" qui

induite le plus souvent un biais (déviation) dans les distributions

dans le temps.

Les processus de fabrication dans l'industrie de pointe ayant une forte tendance à devenir

terriblement complexes, il faut noter que les composants de base utilisés pour

chaque produit ne sont pas toujours de qualité ou de performance égale. Et

si de surcroît, les procédures de fabrication sont difficiles à établir, la

dérive sera inévitablement au rendez-vous.

Que ce soit pour l'une ou l'autre raison, au final bon nombre de produits

seront en dehors de la normale et s'écarteront ainsi de la fourchette correspondant à la

qualité acceptable pour le client. Cette dérive est fort coûteuse pour l'entreprise,

la gestion des rebuts, des retouches ou des retours clients pour non-conformité générant

des coûts conséquents amputant sérieusement les bénéfices espérés.

Comme nous allons le voir dans ce qui suit, une définition possible assez

juste de Six Sigma est: la résolution de problèmes basée sur l'exploitation

de données. C'est donc une méthode scientifique de gestion.

contrôle qualité

Dans le cadre des études qualité en entreprise, nous renonçons souvent à un

contrôle à 100% à cause du prix que cela engendrerait. Nous procédons alors à une

prise d'échantillons. Ceux-ci doivent bien évidemment être représentatifs,

c'est-à-dire quelconques et d'égales chances (in extenso le mélange est bon).

Le but de la prise d'échantillons étant bien évidemment la probabilité du

taux de défaillance réel du lot complet sur la base des défaillances constatées

sur l'échantillonnage.

Rappelons avant d'aller plus loin que nous avons vu dans le chapitre de Statistique

la loi hypergéométrique (et son interprétation) donnée pour rappel par (cf.

chapitre de Statistiques) :

(1)

(1)

Lors d'un échantillonnage, nous avons normalement un paquet de n éléments

dont nous en tirons p. Au lieu de prendre m (nombre entier!)

comme le nombre d'éléments défectueux nous allons implicitement le définir

comme étant égal à :

(2)

(2)

où  est

la probabilité (supposée connue ou imposée...) qu'un pièce soit défectueuse.

Ainsi, nous avons pour probabilité de trouver k pièces défectueuses

dans un échantillon de p pièces parmi n : est

la probabilité (supposée connue ou imposée...) qu'un pièce soit défectueuse.

Ainsi, nous avons pour probabilité de trouver k pièces défectueuses

dans un échantillon de p pièces parmi n :

(3)

(3)

La probabilité cumulée de trouver k pièces défectueuses (entre 0 et k en

d'autres termes) se calcule alors avec la distribution hypergéométrique cumulative

:

(4)

(4)

Exemple: Exemple:

Dans un lot n de 100 machines, nous admettons au maximum que 3 soient

défectueuses (soit que  ).

Nous procédons à un échantillonnage p à chaque sortie de commande de

20 machines. ).

Nous procédons à un échantillonnage p à chaque sortie de commande de

20 machines.

Nous voulons savoir dans un premier temps qu'elle est la probabilité que

dans cet échantillonnage p trois machines soient défectueuses et dans

un deuxième temps quel est le nombre de machines défectueuses maximum autorisé dans

cet échantillonnage p qui nous dirait avec 90% de certitude que le lot

de n machines en contienne que de 3 défectueuses.

x |

H(x) |

|

0 |

0.508 |

0.508 |

1 |

0.391 |

0.899 |

2 |

0.094 |

0.993 |

3 |

0.007 |

1.000 |

Tableau: 1

- Application loi hypergéométrique

Ainsi, la probabilité de tirer en une série de tirages trois machines

défectueuses dans l'échantillon de 20 est de 0.7% et le nombre de pièces défectueuses

maximum autorisé dans cet échantillon de 20 qui nous permet avec au moins 90%

de certitude d'avoir 3 défectueuses est de 1 pièce défectueuse trouvée (probabilité cumulée)!

Les valeurs H(x) peuvent être calculées facilement avec MS

Excel. Par exemple la première valeur est obtenue grâce à la fonction LOI.HYPERGEOMETRIQUE(0;20;3;100).

DÉFAUTS/ERREURS

Intéressons-nous donc à exposer pour la culture générale un exemple pratique

et particulier de ce qui n'est qu'une application simple de la théorie des

statistiques et probabilités.

Imaginons une entreprise fabricant trois copies d'un même produit sortant

d'une même chaîne, chaque copie étant composée de huit éléments.

Remarque: Nous

pouvons tout aussi bien imaginer une société de services développant (fabricant)

trois copies d'un logiciel (produit) sortant d'une même équipe de développement

(chaîne), chacun composé d'un nombre égal de modules (éléments).

Supposons que le produit P1 a un défaut, le produit P2 zéro

défauts et le produit P3 deux défauts.

Ici, Six Sigma suppose implicitement que les défauts sont des variables indépendantes

ce qui est relativement rare dans les chaînes de fabrication machines mais

plus courant dans les chaînes dans lesquelles des humains sont les intervenants.

Cependant, nous pouvons considérer lors de l'application SPC sur des

machines qu'un échantillonage

du temps dans le processus de mesure équivaut à avoir une variable

aléatoire!!

Remarques:

R1. Dans le cadre de l'exemple du logiciel pris plus haut, l'indépendance

est peu probable si nous ne prenons pas un exemple dans lequel les modules

sont

personnalisés

selon les besoins du client.

R2. L'inconstance des résultats de production de certaines machines

dont les réglages bougent pendant le fonctionnement... (ce qui est courant),

voir que la matière première change de qualité pendant la production (ce qui

est aussi courant!) posent donc de gros problèmes d'application des méthodes

SPC.

La moyenne arithmétique des défauts nommée dans le standard Six Sigma "Defects

Per Unit" (D.P.U.) est alors défini par :

(5)

(5)

et donne dans notre exemple :

(6)

(6)

ce qui signifie en moyenne que chaque produit a un défaut de conception ou

fabrication. Attention! Cette valeur n'est pas une probabilité pour les simples

raisons qu'elle peut d'abord être supérieure à 1 et qu'ensuite elle a comme

dimension des [défauts]/[produits].

De même, l'analyse peut être faite au niveau du nombre total d'éléments défectueux

possibles qui composent le produit tel que nous sommes amenés naturellement à définir

selon le standard Six Sigma le "Defects per Unit

Opportunity" (D.P.O.) :

(7)

(7)

ainsi, dans notre exemple, nous avons :

(8)

(8)

et ceci peut être vu comme la probabilité d'avoir un défaut par élément de

produit puisque c'est une valeur sans dimensions :

(9)

(9)

Par extension nous pouvons argumenter que 87.5% des éléments d'une unité n'ont

pas de défauts et comme Six Sigma aime bien travailler avec des exemples de

l'ordre du million (c'est plus impressionnant) nous avons alors les "Defects

Per Million Opportunities" (D.P.M.O.) qui devient :

(10)

(10)

ce qui dans notre exemple donne :

(11)

(11)

Comme la probabilité D qu'un élément d'une pièce

soit non défectueux

est de 87.5% (soit 12.5% de taux de rebus) alors, par l'axiome des probabilités

conjointes (cf.

chapitre de Probabilités), la probabilité qu'un produit

dans son ensemble soit non défectueux est de :

(12)

(12)

ce qui dans notre exemple donne :

(13)

(13)

ce qui n'est pas excellent...

Remarque: Dans

Six Sigma, les probabilités conjointes sont aussi naturellement utilisées

pour calculer la probabilité conjointe de produits non défectueux

dans une chaîne

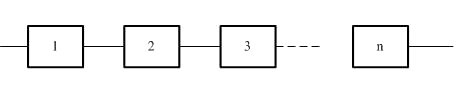

de processus de production P connectés en série. Cette

probabilité conjointe

est appelée dans Six Sigma " Rolled Troughput

Yield" (R.T.Y.) ou " Rendement

Global Combiné" (R.G.C.) et vaut :

(14)

Ce type de calcul étant très utilisé par

les logisticiens qui nomment le résultat "taux

de disponibilité" ainsi que par les chefs de projets pour

la durée d'une phase d'un projet lorsqu'ils considèrent la durées des tâches

comme indépendantes.

Ainsi, dans une chaîne industrielle basée sur l'exemple

précédent

pour avoir une quantité Q bien définie de produits (supposés

utiliser qu'un seul composant de chaque étape) au bout de

la chaîne

il faudra à l'étape A prévoir :

(15)

(15)

soit 52.42% de composants A de plus que prévus. Il

faudra prévoir à l'étape B:

(16)

(16)

soit 37.17% de composants de plus. Et ainsi de suite...

Rappelons maintenant que la densité de probabilité d'avoir k fois

l'événement p et N-k fois l'événement q dans n'importe

quel arrangement (ou ordre) est donné par (cf. chapitre

de Statistiques):

(17)

(17)

et est appelée la loi binomiale ayant pour espérance et écart-type (cf.

chapitre de Statistiques) :

(18)

(18)

Ainsi, dans le standard Six Sigma, nous pouvons appliquer la loi binomiale

pour connaître quelle est la probabilité d'avoir zéros éléments

défectueux et 8 autres en bon état de marche sur un produit de

la chaîne de fabrication de notre exemple (si tous les éléments

ont la même

probabilité de tomber en panne...):

(19)

(19)

et nous retombons bien évidemment sur la valeur obtenue avec les probabilités

conjointes avec :

(20)

(20)

Ou la probabilité d'avoir un élément défectueux et sept autres en bon état

sur un produit de la chaîne de fabrication :

(21)

(21)

nous voyons que la loi binomiale nous donne 39.26% de probabilité d'avoir

un élément défectueux sur 8 dans un produit.

Par ailleurs, dans le chapitre de statistiques, nous avons démontré que lorsque

la probabilité p est très faible et tend vers zéro mais que toutefois

la valeur moyenne  tend

vers une valeur fixe si n tend vers l'infini, la loi binomiale de moyenne tend

vers une valeur fixe si n tend vers l'infini, la loi binomiale de moyenne  avec k épreuves était

donnée alors donnée par : avec k épreuves était

donnée alors donnée par :

(22)

(22)

avec :

(23)

(23)

Remarque: Dans

un cadre pratique, il est fait usage de l'estimateur de maximum de vraisemblance

de la loi expontentielle pour déterminer la moyenne et l'écart-type

ci-dessus (cf. chapitre de Statistiques).

Ce que Six Sigma note naturellement :

(24)

(24)

avec :

(25)

(25)

Ainsi, dans notre exemple, il est intéressant de regarder la valeur obtenue

(qui sera forcément différente étant donné que nous sommes loin d'avoir une

infinité d'échantillons et que p est loin d'être petit) en appliquant

une telle loi continue (la loi continue la plus proche de la loi binomiale

en fait) :

(26)

(26)

avec :

(27)

(27)

ce qui est un résultat encore plus mauvais qu'avec la loi binomiale pour

nos produits.

Cependant, si p est fixé au départ, la moyenne  tend également

vers l'infini théoriquement dans la loi de Poissons de plus l'écart-type tend également

vers l'infini théoriquement dans la loi de Poissons de plus l'écart-type  tend également

vers l'infini. tend également

vers l'infini.

Si nous voulons calculer la limite de la distribution binomiale, il s'agira

donc de faire un changement d'origine qui stabilise la moyenne, en 0 par exemple,

et un changement d'unité qui stabilise l'écart, à 1 par exemple. Ce calcul

ayant déjà été fait dans le chapitre de statistique, nous savons que le résultat

est la loi de gauss-laplace :

(28)

(28)

Ainsi, dans notre exemple, nous avons  et

l'écart-type est donné par l'estimateur sans biais de l'écart-type (cf.

chapitre de Statistique) : et

l'écart-type est donné par l'estimateur sans biais de l'écart-type (cf.

chapitre de Statistique) :

(29)

(29)

ce qui dans notre exemple donne  . .

Pour calculer la probabilité nous calculons la valeur numérique de la loi

de Gauss-Laplace pour  : :

(30)

(30)

Ainsi, en appliquant la loi Normale nous avons 24.19% de chance de tirer

au premier coup un produit défectueux. Cet écart par rapport aux autres

méthodes s'expliquant simplement par les hypothèses de départ (nombre d'échantillons

fini, probabilité faible, etc.)

Remarque: Ceux

qui penseraient utiliser la loi triangulaire (cf. chapitres

de Statistiques) doivent tout de suite l'oublier. Effectivement, comme

en qualité la valeur optimiste sera le zéro par définition, la probabilité que

le nombre de défauts soit égal à 0 sera immédiatement de zéro.

INDICES DE CAPABILITÉ

Six Sigma défini plusieurs indices permettant de mesurer pendant le processus

de fabrication la capabilité de contrôle dans le cas d'un grand nombre

de mesures de défauts répartis souvent selon une loi de Gauss-Laplace (loi

Normale).

Basiquement, si nous nous imaginons dans une entreprise, responsable de la

qualité d'usinage d'une nouvelle machine, d'une nouvelle série de pièces, nous

allons être confrontés aux deux situations suivantes:

1. Au début de la production, il peut y avoir de gros écarts de qualité dûs

à des défauts de la machine ou de réglages importants mal initialisés. Ce sont

des défauts qui vont souvent être rapidement corrigés (sur le court terme).

Dès lors pendant cette période de grosses corrections, nous faisons des contrôles

par lot (entre chaque grosse correction) et chacun sera considéré comme une

variable aléatoire indépendante et identiquement distribuée (selon une loi

Normale)

mais de moyenne

et écart-type

bien évidemment différents.

2. Une fois les gros défauts corrigés, nous n'allons avoir en théorie plus

que des défauts minimes très difficilements contrôlables et ce même sur long

terme.

Alors l'analyse

statistique ne se fait plus forcément par lot de pièces mais par pièces et

l'ensemble des

pièces sur le long terme est considéré comme un unique lot à chaque fois.

Ces deux scénarios mettent en évidence que nous n'effectuons

alors logiquement pas les mêmes analyses en début de production

et ensuite sur le long terme. Raison pour laquelle en SPC nous définissons

plusieurs indices (dont les notations sont propre à ce site Internet

car elles changent selon les normes) dont 2 principaux qui sont:

D1. Nous appelons "Capabilité potentielle

du procédé

court terme"

le rapport entre l'étendue de contrôle E de

la distribution des valeurs et la qualité de Six Sigma (6 sigma) lorsque

le processus est centré (c'est-à-dire sous contrôle) tel que :

(31)

(31)

ce qui s'écrit aussi :

(32)

(32)

où USL est la limite supérieure de contrôle/tolérance ou "Upper

Specification Level" (USL) de la distribution et LSL la limite

inférieure ou "Lower Specification Level" (LSL)

que nous imposons souvent (mais pas toujours!) dans l'industrie comme à distances égales

par rapport à la

moyenne  théorique

souhaitée. théorique

souhaitée.

Ce rapport est utile dans l'industre dans le sens où l'étendue E (qui

est importante car elle représente la dispersion/variation du processus)

est assimilée à la "voix du client" (ses exigences)

et le 6 sigma au dénominateur

au comportement réel du procédé/processus et que la valeur

6 est censée inclure

quasiment toutes les issues possibles. Il vaut donc mieux espérer que

ce rapport soit au pire égal à l'unité!

Voici typiquement un exemple en gestion de projets où lorsque le client

ne paie pas pour une modélisation du risque fine on tombe sur ce type

de distribution (le client accepte que le consultant puisse garantir une variation

qui ne dépassera pas les 50% de l'estimation sans modélisation du risque):

(33)

Remarque: En

MSP, l'étendue E est souvent notée IT, signifiant "intervalle

de tolérance".

L'écart-type au dénominateur étant donné par la relation démontrée dans

le chapitre de Statistique dans le cas de k variables aléatoires

indépendantes et identiquement distribuées selon une loi Normale (mais d'écart-type

et moyenne non-identique):

(34)

(34)

où CT est l'abréviation de "court terme" (abréviation

souvent non précisée dans la pratique car supposée connue dans le contexte).

Cet écart-type

est bien évidemment le meilleur pour le premier scénario dont

nous avons fait mention plus haut. Car entre chaque grosse correction, les

lots sont considérés

comme indépendants et ne peuvent pas être analysés comme

un seul et unique lot (ce serait une abérration!).

Attention cependant! Comme souvent dans la situation court terme (lors de

la correction des grosses sources d'erreurs donc) les lots de tests sont petits,

même très petits, afin de diminuer les coûts en production. Dès lors l'écart-type

se trouvant sous la racine (qui est l'estimateur de maximum de vraisemblance

de la loi Normale) n'a pas une valeur vraiment correcte... Il est alors bon

d'utiliser soit d'autres méthodes de calcul assez empiriques comme le font

de nombreux

logiciels, soit de calculer un intervalle de confiance de l'indice de capabilité

en calculant l'intervalle de confiance de l'écart-type court terme comme nous

l'avons vu dans le chapitre de Statistique.

D2. Nous appelons "Performance globale du procédé long

terme" le

rapport entre l'étendue de contrôle E de la distribution des valeurs

et la qualité de Six Sigma (6 sigma) lorsque le

processus est centré tel que :

(35)

(35)

ce qui s'écrit aussi :

(36)

(36)

L'écart-type au dénominateur étant donné cette

fois par le cas où nous considérons tous les gros défauts

corrigés et le processus

stable afin de considérer toutes les pièces fabriquées comme

un seul et unique lot de contrôle:

(37)

(37)

où LT est l'abréviation de "long terme" (abréviation

souvent non précisée dans la pratique car supposée connue

dans le contexte).

Cet écart-type est bien évidemment le meilleur pour le deuxième

scénario dont nous avons fait mention plus haut. Car les variations

étant par hypothèses maintenant toutes petites, l'ensemble de la fabrication

peut être supposée comme étant un seul et unique lot de contrôle sur le long

terme (bon cela n'empêche pas qu'il faut parfois nettoyer les valeurs extrêmes

qui peuvent se produire).

Le tolérancement des caractéristiques est donc très important pour l'obtention

de la qualité et de la fiabilité des produits assemblés. Traditionnellement,

une tolérance s'exprime sous la forme d'un bipoint [Min,Max]. Une caractéristique

est alors déclarée conforme si elle se situe dans les tolérances.

Le problème

du tolérancement consiste à tenter de concilier la fixation des limites

de variabilité acceptable les plus larges possibles pour

diminuer les coûts de production et d'assurer un niveau de qualité optimal

sur le produit fini.

Deux approches tentent de résoudre ce problème:

1. Le tolérancement au pire des cas garanti l'assemblage dans toutes les

situations à partir

du moment où les caractéristiques élémentaires sont dans les tolérances.

2. Le tolérancement statistique tient compte de la faible probabilité d'assemblages

d'extrêmes entre eux et permet d'élargir de façon importante les tolérances

pour diminuer les coûts et c'est donc à celui-ci que nous allons nous

intéresser

ici comme vous l'aurez compris.

Un processus est dit "limite capable" (soit

limite stable par rapport aux exigences du client en d'autres termes) s'il

le ratio donné ci-dessus (en choisissant 6 fois l'écart-type)

est supérieur à 1. Mais dans l'industrie on préfère

prendre en réalité la valeur de ~1.33 dans le cas d'une distribution

Normale des données.

Bien évidemment, la valeur  de

l'écart-type peut-être être calculée en utilisant les estimateurs de maximum

de vraisemblance avec ou sans biais vus dans le chapitre de Statistiques mais

il ne s'agit en aucun cas dans la réalité pratique de l'écart-type

théorique mais d'un estimateur. Par ailleurs, nous verrons plus loin

qu'en fonction de l'écart-type utilisé, les notations des indicateurs

changent! de

l'écart-type peut-être être calculée en utilisant les estimateurs de maximum

de vraisemblance avec ou sans biais vus dans le chapitre de Statistiques mais

il ne s'agit en aucun cas dans la réalité pratique de l'écart-type

théorique mais d'un estimateur. Par ailleurs, nous verrons plus loin

qu'en fonction de l'écart-type utilisé, les notations des indicateurs

changent!

Remarque: En

entreprise, il faut faire attention car l'instrument de mesure rajoute son

propre écart-type (erreur) sur celui de la production.

Comme nous l'avons démontré au chapitre de Statistique, l'erreur-type (écart-type

de la moyenne) est :

(38)

(38)

Dans la méthodologie Six Sigma nous prenons alors souvent pour les processus

à long terme et sous contrôle:

(39)

(39)

quand nous analysons des cartes de contrôles dont les variables aléatoires

sont des échantillons de n variables aléatoires indépendantes

et identiquement distribuées et que les limites n'ont pas été imposées

par un client ou par une politique interne ou des contraintes techniques! Bien évidemment,

il faut bien être

conscient que UCL et LCL n'ont pas la même expression

dans des cas plus complexes et donc pour des distributions autre que la loi

Normale!

Par ailleurs l'expression précédente diffère aussi pour

les processus à court

terme car l'exemple donnée ci-dessus est pour un cas de mesures sur

le long terme uniquement pour rappel!

Le lecteur remarquera que nous avons maintenant:

(40)

(40)

Normalement, au sein des entreprise, l'étendue de contrôle est fixe (le numérateur)

et donc quand la valeur de l'écart-type type est grande (plus de variations,

moins de contrôles) la valeur de l'indice est faible et lorsque l'écart-type

est faible (moins de variations, plus de contrôles) la valeur de l'indice est élevé.

Comme le montre les deux exemples ci-dessous :

(41)

L'indice  impose

que la moyenne (l'objectif) est centrée entre LSL et USL. Dès lors, la moyenne

est confondue avec ce que nous appelons la "cible" T du

processus. impose

que la moyenne (l'objectif) est centrée entre LSL et USL. Dès lors, la moyenne

est confondue avec ce que nous appelons la "cible" T du

processus.

Mais la moyenne  dans

la réalité peut être décalée par rapport à l'objectif T initial qui

doit lui toujours (dans l'usage courant) être à distance égale entre USL et

LSL comme le montre la figure ci-dessous dans le cas particulier d'une loi

Normale : dans

la réalité peut être décalée par rapport à l'objectif T initial qui

doit lui toujours (dans l'usage courant) être à distance égale entre USL et

LSL comme le montre la figure ci-dessous dans le cas particulier d'une loi

Normale :

(42)

Mais ce n'est pas forcément le cas dans la réalité où les ingénieurs (quelque

soit leur domaine d'application) peuvent choisir des LSL et USL asymétriques

par rapport à la moyenne ne serait-ce que parce que la loi n'est pas toujours

Normale

(typiquement

le

cas en gestion de projets...)! D'où la définition suivante :

D2. Nous appelons alors "Capabilité

potentielle décentrée court terme du procédé" (dans

le cas décentré) ou "Process

Capability Index (within)" la relation :

(43)

(43)

avec :

(44)

(44)

où  est

appelé le "dégré de biais" et T le "target" donné naturellement

par: est

appelé le "dégré de biais" et T le "target" donné naturellement

par:

(45)

(45)

qui donne le milieu de la distribution relativement au bi-point [LSL,USL]

imposé (ne pas oublier que l'écart-type au dénominateur

de la relation antéprécédente est l'écart-type

court terme!).

Au fait cet indicateur de capabilité de contrôle peut sembler

très artificiel mais il ne l'est pas totalement.... Effectivement il y a quelques

valeurs remarquables (celles qui intéressent l'ingénieur) qui

permettent de se faire une bonne idée ce qu'il se passe avec celui-ci:

1. Si la moyenne et la cible sont confondues nous avons alors:

(46)

(46)

nous nous retrouvons donc avec  et

donc et

donc  et

le critère de jugement de la valeur de l'indice sera basée sur l'indice de

capabilité centrée court terme. et

le critère de jugement de la valeur de l'indice sera basée sur l'indice de

capabilité centrée court terme.

2. Si faute d'un mauvais contrôle du processus nous avons :

(47)

(47)

alors la moyenne  est

soit au-dessus de USL soit en-dessous de LSL ce qui a pour conséquence d'avoir est

soit au-dessus de USL soit en-dessous de LSL ce qui a pour conséquence d'avoir  et

donc et

donc  . .

3. Si nous avons :

(48)

(48)

alors la moyenne  est

comprise entre les valeurs USL et LSL ce qui a pour conséquence d'avoir est

comprise entre les valeurs USL et LSL ce qui a pour conséquence d'avoir  et

donc et

donc  . .

4. Si nous avons:

(49)

(49)

alors cela signifie simplement que la moyenne est confondue avec USL ou LSL et nous avons alors  et et  . .

Comme l'interprétation reste cependant délicate et difficile, nous construisons

les indices "Upper

Capability Index CPU" et "Lower Capability

Index CPL" donnés par:

(50)

(50)

Voyons d'où viennent ces deux valeurs et comment les utiliser:

Démonstration:

D'abord, nous avons besoin de deux formulations particulière du degré de

biais k.

Si:

(51)

(51)

alors nous pouvons nous débarrasser de la valeur absolue:

(52)

(52)

Si:

(53)

(53)

alors nous pouvons nous débarrasser de la valeur absolue:

(54)

(54)

Nous avons alors lorsque  : :

(55)

(55)

et respectivement lorsque  : :

(56)

(56)

C.Q.F.D. C.Q.F.D.

A long terme dans certaines entreprises il est intéressant de savoir qu'elles

sont les plus mauvaises valeurs prises par les indices CPU et CPL

(c'est le cas dans le domaine de la production mais pas forcément de

la gestion de projets)

Les plus mauvaises valeurs étant trivialement les plus petites, nous prenons

souvent (avec quelques une des notations différentes que l'on peut

trouver dans la littérature spécialisée...):

(57)

(57)

Voici par exemple un diagramme d'analyse de la capabilité produit

par le logiciel Minitab (en anglais) avec les différents facteurs susmentionnés

sur un échantillons de 68 données suivant une loi Normale (un

test de normalité a été fait avant):

(58)

Deux lectures typiques sont possibles (nous expliquerons la partie inférieure

gauche du graphique plus loin):

1. En production: Le processus est capable (valeur >1.33) mais avec

une (trop) forte déviation vers le gauche par rapport à la cible

définie

ce qui n'est pas bon (CPL ayant

la

valeur la plus petite) et doit être corrigé.

2. En gestion de projets: Les tâches redondantes sont sous contrôle

(valeur

>1.33) mais avec une forte déviation vers le gauche ce qui peut être

bon si notre objectif est de prende de l'avance par rapport au planifié (rien à corriger).

Il faut vraiment prendre garde au fait que dans la réalité il

n'est pas toujours possible de prendre la loi Normale or tous les exemples

donnés ci-dessus ce sont basés sur cette hypothèse simplificatrice.

Toujours le cadre de la gestion de la qualité en production, la figure

ci-dessous représente bien la réalité dans le cadre d'un processus court ou

long terme:

(59)

Source: MSP/SPC de Maurice Pillet

Chaque petite gaussienne en gris clair, représente une analyse de lots. Effectivement,

nous voyons bien que leurs moyennes ne cessent de bouger pendant la période

de mesures (que cette variation soit grande ou très faible).

Or la relation définissant  supposait,

comme nous l'avons mentionné que le processus est sous contrôle centré (donc

toutes les gaussiennes sont alignées) et sur une optique court-terme. supposait,

comme nous l'avons mentionné que le processus est sous contrôle centré (donc

toutes les gaussiennes sont alignées) et sur une optique court-terme.

De même, la relation définissant  supposait,

comme nous l'avons mentionné que le processus est sous contrôle, sur une optique

court terme et décentré par choix (ou à cause du fait que la loi n'est pas

Normale). supposait,

comme nous l'avons mentionné que le processus est sous contrôle, sur une optique

court terme et décentré par choix (ou à cause du fait que la loi n'est pas

Normale).

Par contre, si le processus n'est pas centré parce qu'il n'est pas sous contrôle

alors qu'il devrait l'être, la variable aléatoire mesurée est la somme

de la variation aléatoire des réglages X de la machine et des variations

aléatoires

non-contrôlables des contraintes des pièces Y.

L'écart-type total est alors, si les deux variables aléatoires suivent une

loi normale, la racine carrée de la somme des écart-types (cf.

chapitre de Statistiques):

(60)

(60)

Or, si nous n'avons qu'une seule mesure, il vient en prenant l'estimateur

biaisé (c'est un peu n'importe quoi de l'utiliser dans ce cas là mais bon...)

:

(61)

(61)

Or dans le cas d'étude qui nous intéresse Y représente la moyenne

expérimentale (mesurée) du processus qu'on cherche à mettre sous contrôle.

Cette moyenne est notée traditionnellement m dans le domaine.

Ensuite,  n'étant

pas connu on prend ce qu'il devrait être: c'est la cible T du processus.

Ainsi, nous introduisons un nouvel indice appelé "Capabilité potentielle

décentrée

moyenne court terme du procédé" : n'étant

pas connu on prend ce qu'il devrait être: c'est la cible T du processus.

Ainsi, nous introduisons un nouvel indice appelé "Capabilité potentielle

décentrée

moyenne court terme du procédé" :

(62)

(62)

où encore une fois il faut se rappeler que l'écart-type dans la racine au

dénominateur est l'écart-type court terme!

Nous voyons immédiatement que plus  est

proche de est

proche de  mieux

c'est (dans les domaines de production du moins). mieux

c'est (dans les domaines de production du moins).

Nous avons donc finalement les trois indices de capabilités court terme centré et

non centré les plus courants (nous avons délibérément choisi d'uniformiser

les notations et de mettre le maximum d'infos dans celles-ci):

(63)

(63)

De même nous avons aussi les trois indices de capabilités long terme centré et

non centré les plus courants (nous avons délibérément choisi d'uniformiser

les notations et de mettre le maximum d'infos dans celles-ci):

(64)

(64)

Enfin, indiquons que bien que ce soit pas très pertinent, il arrive parfois

que certains ingénieurs fassent les deux analyses (court terme + long terme)

en même temps sur la même base de données de mesures.

Cependant, pour faire de l'analyse objective sur les indices de capabilité vus

jusqu'à maintenant, il faudrait d'abord que les instruments de mesure soient

eux-mêmes capables... ce que nous appelons souvent les "méthodes R&R"

(Répétabilité,

Reproductibilité).

Le principe consiste alors à évaluer la dispersion courte terme ou respectivement

long terme de l'instrument de mesure afin de calculer une "capabilité de

processus de contrôle" définie par:

(65)

(65)

Dans les cas classiques, nous déclarons le moyen de contrôle capable pour

une suivi MSP lorsque cette capabilité est supérieure à 4 et nous allons de

suite voir pourquoi. Rappelons pour cela d'abord que:

(66)

(66)

Mais la variance observée est au fait la somme de la "vraie" variance

et de celle de l'instrument telle que:

(67)

(67)

Or nous avons:

et et  (68)

(68)

En mettant le tout au carré, nous en déduisons:

(69)

(69)

D'où:

(70)

(70)

Ce qui nous donne:

(71)

(71)

Soit:

(72)

(72)

Ce qui se traduit par le graphique de la figure suivante qui montre bien

l'intérêt d'un  au

moins égal à 4! au

moins égal à 4!

(73)

Dans la pratique, signalons que pour déterminer  on

se sert d'une pièce étalon mesurée par interférométrie LASER et s'assurer ensuite

que tous les essais répétés de mesure se fassent sur les deux mêmes points

de mesure. on

se sert d'une pièce étalon mesurée par interférométrie LASER et s'assurer ensuite

que tous les essais répétés de mesure se fassent sur les deux mêmes points

de mesure.

Une fois ceci fait, on effectue plusieurs mesures de la cote étalon et on

prend l'écart-type de ces mesures. Ce qui donnera le  . .

L'étendue E est elle imposée par le client ou par des ingénieurs internes à l'entreprise.

Elle sera souvent prise comme étant au plus dixième de l'unité de tolérance

d'une pièce.

Par exemple, si nous avons un diamètre intérieur de  (étendue

de tolérance de 2 microns ce qui est déjà du haut de gamme niveau de précision

car à notre époque le standard se situe plutôt autour des 3!), notre appareil

devra alors avoir selon la règle précédemment citée une étendue de 0.2 microns....

Il est alors aisé de déterminer qu'elle devra être l'écart-type maximum de

l'instrument si on se fixe une capabilité de processus de contrôle de 4 (et

encore... 4 c'est grossier!). (étendue

de tolérance de 2 microns ce qui est déjà du haut de gamme niveau de précision

car à notre époque le standard se situe plutôt autour des 3!), notre appareil

devra alors avoir selon la règle précédemment citée une étendue de 0.2 microns....

Il est alors aisé de déterminer qu'elle devra être l'écart-type maximum de

l'instrument si on se fixe une capabilité de processus de contrôle de 4 (et

encore... 4 c'est grossier!).

Certains ingénieurs apprécient de savoir à combien d'éléments en millions

d'unités produites (parties par million: PPM) seront considérées comme défectueuses

relativement.

Le calcul est alors aisé puisque l'ingénieur a à sa disposition au moins

les informations suivantes:

(74)

(74)

et que les données suivent une loi Normale alors il est immédiat que (cf.

chapitre de Statistiques):

(75)

(75)

et:

(76)

(76)

valeurs très aisées à obtenir avec n'importe quel tableur comme MS Excel

par exemple.

Nous avons alors

(77)

(77)

il en est de même pour la capabilité long-terme (il suffit de prendre alors

l'expression correspondante de l'écart-type).

NIVEAUX DE QUALITÉS

Signalons un point important relativement à Six Sigma. Au fait, objectivement,

l'idée de cette méthode est certes de faire de la SPC (entre

autres, mais ça

ce n'est pas nouveau) mais surtout de garantir au client selon la tradition

couramment admise avec un écart-type ayant une borne supérieure

de  avec

une déviation à la moyenne (en valeur absolue) de 1.5 avec

une déviation à la moyenne (en valeur absolue) de 1.5 par

rapport à la cible ce qui garantit au plus 3.4 PPM (c'est-à-dire 3.4

rejets par million). par

rapport à la cible ce qui garantit au plus 3.4 PPM (c'est-à-dire 3.4

rejets par million).

Remarque: Ce choix empirique vient de la mise

en pratique de la méthode Six Sigma par son créateur (Bill Smith).

Il a observé dans

son entreprise (Motorola) que sous contrôle statistique il avait

quasimment systématiquement une déviation comprise entre 1.2

et 1.8  à

la moyenne pour tous ses procédés industriels.

Voyons d'où vient cette dernière valeur à l'aide des deux tableaux suivants:

1. D'abord construisons un tableau de type idéal qui présente des données

d'un procédé court terme (mais les calculs sont parfaitement identiques pour

du long terme) centré sur la cible (de cible nulle ici, ce qui est un cas typique),

de moyenne nulle (donc sur la cible et alors donc  )

et d'écart-type unitaire avec USL et LSL symétriques (ce qui restreint par

contre le champ d'application): )

et d'écart-type unitaire avec USL et LSL symétriques (ce qui restreint par

contre le champ d'application):

Cp |

Cpk |

Défauts (PPM) |

Niveau de qualité Sigma |

Critère |

0.5 |

0.5 |

133614 |

1.5 |

Mauvais |

0.6 |

0.6 |

71861 |

1.8 |

|

0.7 |

0.7 |

35729 |

2.1 |

|

0.8 |

0.8 |

16395 |

2.4 |

|

0.9 |

0.9 |

6934 |

2.7 |

|

1 |

1 |

2700 |

3 |

|

1.1 |

1.1 |

967 |

3.3 |

|

1.2 |

1.2 |

318 |

3.6 |

|

1.3 |

1.3 |

96 |

3.9 |

Limite |

1.4 |

1.4 |

27 |

4.2 |

|

1.5 |

1.5 |

6.8 |

4.5 |

|

1.6 |

1.6 |

1.6 |

4.8 |

|

1.7 |

1.7 |

0.34 |

5.1 |

|

1.8 |

1.8 |

0.067 |

5.4 |

|

1.9 |

1.9 |

0.012 |

5.7 |

|

2 |

2 |

0.002 |

6 |

Excellent |

Tableau: 2

- Capabilité, Niveau de qualité Sigma et P.P.M. dans procédé centré

où tout les données sont obtenues à l'aide des relations suivantes à partir

de l'indice de capabilité potentielle uniquement:

(78)

(78)

si l'écart-type est réduit (ce qui peut toujours être fait et ne change point

la justesse des résultats!). Et puisque dans le tableau ci-dessus LSL et USL sont

symétrique par rapport à la cible:

(79)

(79)

et les PPM sont conformément à ce que nous avons vus juste avant donnés par:

(80)

(80)

et donc puisque dans l'exemple ci-dessus LSL et USL sont symétrique par rapport à la

cible cela se simplifie en:

(81)

(81)

où par exemple la valeur du PPM donnée à la ligne "Limite" est obtenue

avec Maple à l'aide de la commande:

>evalf((1-1/sqrt(2*Pi)*int(exp(-x^2/2),x=-infinity..3.9))*2)*1E6;

ou avec MS Excel (version anglais):

=(1-NORMDIST(3.9;0;1;1))*1E6

Il nous reste à voir d'où provient le "niveau

de qualité sigma" noté  qui

est au fait donné à l'aide du tableau que nous avions construit dans le chapitre

de Statistique: qui

est au fait donné à l'aide du tableau que nous avions construit dans le chapitre

de Statistique:

Niveau

de qualité Sigma |

Taux

de non-défection assuré en % |

Taux

de défection en parties par million |

|

68.26894 |

317'311 |

|

95.4499 |

45'500 |

|

99.73002 |

2'700 |

|

99.99366 |

63.4 |

|

99.999943 |

0.57 |

|

99.9999998 |

0.002 |

Tableau: 3

- Capabilité, Taux de non-défection en % et PPM

et nous avions donné la commande Maple pour obtenir ses valeurs qui sont

toutes valables pour tout écart-type et toute espérance!

2. Maintenant construisons le tableau au pire selon Six Sigma, soit un tableau

en procédé non centré (c'est-à-dire où  n'est

pas satisfait) avec une déviation

de la moyenne de n'est

pas satisfait) avec une déviation

de la moyenne de  (donc à droite

mais on pourrait prendre à gauche et les résultats seraient les mêmes)

par rapport à la

cible et d'écart-type unitaire avec USL et LSL symétriques (ce

qui restreint toujours le champ d'application): (donc à droite

mais on pourrait prendre à gauche et les résultats seraient les mêmes)

par rapport à la

cible et d'écart-type unitaire avec USL et LSL symétriques (ce

qui restreint toujours le champ d'application):

Cp |

Cpk |

Défauts (PPM) |

Niveau de qualité Sigma |

Critère |

0.5 |

0 |

501350 |

1.5 |

Mauvais |

0.6 |

0.1 |

382572 |

1.8 |

|

0.7 |

0.2 |

27412 |

2.1 |

|

0.8 |

0.3 |

184108 |

2.4 |

|

0.9 |

0.4 |

115083 |

2.7 |

|

1 |

0.5 |

66810 |

3 |

|

1.1 |

0.6 |

35931 |

3.3 |

|

1.2 |

0.7 |

17865 |

3.6 |

|

1.3 |

0.8 |

8198 |

3.9 |

Limite |

1.4 |

0.9 |

3467 |

4.2 |

|

1.5 |

1 |

1350 |

4.5 |

|

1.6 |

1.1 |

483 |

4.8 |

|

1.7 |

1.2 |

159 |

5.1 |

|

1.8 |

1.3 |

48 |

5.4 |

|

1.9 |

1.4 |

13 |

5.7 |

|

2 |

1.5 |

3.4 |

6 |

Excellent |

Tableau: 4

- Capabilité, Niveau de qualité Sigma et P.P.M. dans procédé décentré

où tout les données sont obtenues à l'aide des relations suivantes à partir

de l'indice de capabilité potentielle uniquement:

(82)

(82)

et donc:

(83)

(83)

d'où:

(84)

(84)

et les PPM sont conformément à ce que nous avons vus juste avant donnés par:

(85)

(85)

où la ligne "Limite" du tableau précédent est par exemple obtenue

avec Maple à l'aide

de la commande:

>evalf((1-1/sqrt(2*Pi)*int(exp(-(x-1.5)^2/2),x=-infinity..(1.3*3))))*1E6+evalf((1/sqrt(2*Pi)*int(exp(-(x-1.5)^2/2),x=-infinity..-(3*(1.3+1)))))*1E6;

ou avec MS Excel:

=(((1-NORMDIST(3*1.3;1.5;1;1))+NORMDIST(-3*(1.3+1);1.5;1;1)))*1E6

On comprend enfin en voyant cette fameuse ligne "Limite" pourquoi

un procédé sous-contrôle est dit "limite capable" avec un indice

de capabilité potentielle de 1.33 étant donné le nombre de PPM!

Donc le but dans la pratique c'est bien évidemment d'être dans la situation

du premier tableau avec pour valeur correspondante dans ce premier tableau à un

niveau de qualité sigma de  pour

avoir l'équivalent des 3.4 PPM du deuxième tableau (car il est plus facile

de centrer un procédé que de contrôler ses écarts). pour

avoir l'équivalent des 3.4 PPM du deuxième tableau (car il est plus facile

de centrer un procédé que de contrôler ses écarts).

Toute l'importance des valeurs calculées ci-dessous est dans l'application

de procédés de fabrication à n-étapes

en série

(considérés sous la dénomination de "processus"). Cette

application sera présentée dans le chapitre sur les Techniques de Gestion.

Exemple: Exemple:

Faisons un résumé de tout cela en considérant une nouvelle

petite production de  pièces

par lot de 10 (afin d'ajuster en cours de production). La mesure de côtes de

5 pièces chaque heure pendant 10 heures avec une tolérance de pièces

par lot de 10 (afin d'ajuster en cours de production). La mesure de côtes de

5 pièces chaque heure pendant 10 heures avec une tolérance de  soit

en termes de centièmes un étendue de: soit

en termes de centièmes un étendue de:

(86)

(86)

et une cible de  (en

termes d'écarts). Nous avons les données suivantes: (en

termes d'écarts). Nous avons les données suivantes:

| |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

10 |

1 |

-2 |

-4 |

-1 |

0 |

4 |

0 |

3 |

0 |

1 |

-1 |

2 |

0 |

-3 |

0 |

-2 |

1 |

-2 |

0 |

1 |

-1 |

2 |

3 |

-1 |

0 |

-3 |

-1 |

0 |

0 |

-1 |

-1 |

3 |

1 |

4 |

1 |

1 |

-2 |

2 |

2 |

0 |

1 |

0 |

4 |

0 |

5 |

-1 |

-1 |

-3 |

0 |

0 |

3 |

3 |

2 |

1 |

0 |

|

-0.6 |

-1.4 |

-1.8 |

-0.2 |

1.4 |

0.2 |

1.2 |

0.4 |

1.6 |

0.5 |

|

1.14 |

2.07 |

1.30 |

1.48 |

1.67 |

1.79 |

1.79 |

1.14 |

1.95 |

1.14 |

Tableau: 5

- Application d'analyse de maîtrise statistique des procédés

Nous voyons immédiatement que le processus de fabrication a été non-stationnaire

pendant cette première production il faudra donc apporter des corrections à l'avenir:

(87)

ou sous forme de carte de contrôle (comme je les aime) avec la représentation

d'un écart-type de  (ce

qui est suffisant pour des petites quantité des pièces bon marché à fabriquer): (ce

qui est suffisant pour des petites quantité des pièces bon marché à fabriquer):

(88)

Donc on devine quand même que le processus est limite....

Remarque: Une chose intéressante c'est que l'on peut analyser aussi ce graphique

en utilisant les outils mathématiques de l'analyse des séries temporelles

(cf. chapitre d'Économétrie).

D'abord, si nous voulons faire une étude statistique pertinente des différentes

données ci-dessus nous pouvons calculer la moyenne générale des écarts qui

sous l'hypothèse d'une distribution Normale est la moyenne arithmétique (cf.

chapitre de Statistiques):

(89)

(89)

Ensuite l'écart-type des données de toutes les pièces est de:

(90)

(90)

en utilisant l'estimateur de maximum de vraisemblance de la variance de la

loi Normale:

(91)

(91)

nous avons une valeur supérieur à 1 ce qui est donc non-conforme à ce que

Six Sigma exige dans son niveau de qualité.

Donc l'erreur-standard (l'estimateur de l'écart-type de la moyenne) est de:

(92)

(92)

Donc l'intervalle de confiance à 95% de la moyenne est de (cf.

chapitre de Statistiques):

(93)

(93)

Soit dans notre cas:

(94)

(94)

Et l'inférence statistique avec notre écart-type long terme utilisant le

test d'hypothèse bilatéral du  donne

(cf. chapitre de Statistiques): donne

(cf. chapitre de Statistiques):

(95)

(95)

Ce qui nous donne dans notre cas:

(96)

(96)

soit:

(97)

(97)

Nous remarquons alors que sur une analyse long terme nous avons les intervalles:

(98)

(98)

Calculons maintenant la performance globale du procédé long terme (si supposé centré donc!).

Nous avons:

(99)

(99)

Mais avec un instrument ayant un  de

4, cela correspond réellement à: de

4, cela correspond réellement à:

(100)

(100)

De plus, indiquons que comme nous savons faire un calcul d'intervalle de

confiance pour  (voir

le calcul fait précédemment), il est alors aisé d'en avoir un pour (voir

le calcul fait précédemment), il est alors aisé d'en avoir un pour  aussi! aussi!

Si l'analyse de la performance globale du procédé long terme est non centrée

(ce qui est le cas ici) nous utilisons donc:

(101)

(101)

et nous savons encore une fois qu'à cause de l'instrument, cette valeur

est un peu sous-évaluée! Nous avons bien évidemment:

(102)

(102)

donc le processus n'est pas centré (on s'en doutait...). Alors il faut calculer

la capabilité potentielle décentrée moyenne long terme du procédé  selon

les relations déterminées plus haut: selon

les relations déterminées plus haut:

(103)

(103)

Bref, que ce soit de la valeur de  , ,  ou ou  ,

nous voyons que les valeurs sont toutes limites capable (c'est-à-dire

que la valeur est supérieure à 1 - voir définition plus

haut pour un rappel de ce que signifie "limite capable"). ,

nous voyons que les valeurs sont toutes limites capable (c'est-à-dire

que la valeur est supérieure à 1 - voir définition plus

haut pour un rappel de ce que signifie "limite capable").

Si nous faisons alors nos calculs de PPM selon les relations obtenues

plus haut avec la valeur de  et

de et

de  obtenues,

nous avons alors: obtenues,

nous avons alors:

(104)

(104)

Ensuite dire ce chiffre est bon ou mauvais cela est difficile car il nous

manque l'information de savoir quel est le coût de production, le coût de revient

et de réparation d'un produit et le tout est lui-même dépendant de la quantité total

fabriquée! Mais nous pouvons utiliser aussi le modèle de Taguchi pour connaître

la valeur des paramètres (moments) calculés qu'il serait préférable de ne pas

dépasser!

Calculons maintenant les indices de capabilité court terme! Pour cela, il

nous faut l'estimateur de la moyenne de l'ensemble en considérant chaque échantillon

comme une variable aléatoire. Nous savons (cf. chapitre

de Statistiques) que

cette moyenne est aussi la moyenne arithmétique dans le cas d'une loi Normale

et elle est strictement égale à celle que l'on calcule en considérant l'ensemble

des échantillons comme une seule et unique variable aléatoire. Donc il vient

que:

(105)

(105)

En ce qui concerne l'écart-type par contre ce n'est pas pareil. Mais nous

savons (cf. chapitre de Statistiques) que la loi Normal est stable par la somme.

Par exemple, nous avions démontré que étant donné deux variables aléatoires

indépendantes et distribuées selon une loi Normale (en imaginant que chaque

variable représente deux de nos dix échantillons), nous avions donc pour leur

some.:

(106)

(106)

Or nous avons aussi démontré dans le chapitre de Statistiques que de par

la propriété de linéarité de l'espérance, nous avons:

(107)

(107)

ce qui est conforme à notre remarque précédent pour la variance:

(108)

(108)

Donc in extenso:

(109)

(109)

et dans notre cas particulier:

(110)

(110)

nous avons une valeur supérieur à 1 ce qui est donc non-conforme à ce que

Six Sigma exige dans son niveau de qualité.

Donc l'erreur-standard (l'estimateur de l'écart-type de la moyenne) est de:

(111)

(111)

Donc l'intervalle de confiance à 95% de la moyenne est de (cf.

chapitre de Statistiques):

(112)

(112)

Soit dans notre cas:

(113)

(113)

Nous remarquons donc qu'en court terme, l'intervalle est beaucoup plus large

qu'en long terme ce qui est normal étant donné la faible valeur de k (qui

vaut donc 5 dans notre exemple).

Et l'inférence statistique avec notre écart-type long terme utilisant le

test d'hypothèse bilatéral du  donne

(cf. chapitre de Statistiques): donne

(cf. chapitre de Statistiques):

(114)

(114)

Ce qui nous donne dans notre cas:

(115)

(115)

soit:

(116)

(116)

Nous remarquons alors que sur une analyse long terme avec les intervalles:

(117)

(117)

Les variations peuvent donc être énormes avec une probabilité cumulée de

95% et il faudra prendre garde dans un cas pratique d'apporter des réglages

au plus vite afin de diminuer aux maximum les moments!

Calculons maintenant la capabilité potentielle du procédé court terme (si

supposé centré donc!). Nous avons:

(118)

(118)

Donc nous avons:

(119)

(119)

ce qui est normal car si les mesures que nous avons étaient vraiment faites

sur une longue période alors ce serait très problématique alors que sur une

courte période c'est déjà un peu plus normal. D'où cette relation d'ordre entre

les deux indices.

Mais avec un instrument ayant un  de

4, cela correspond réellement à: de

4, cela correspond réellement à:

(120)

(120)

De plus, indiquons que comme nous savons faire un calcul d'intervalle de

confiance pour  (voir

le calcul fait précédemment), il est alors aisé d'en avoir un pour (voir

le calcul fait précédemment), il est alors aisé d'en avoir un pour  aussi! aussi!

Si l'analyse de la capabilité potentielle du procédé court terme est non

centrée (ce qui est le cas ici) nous utilisons donc:

(121)

(121)

et nous savons encore une fois qu'au cause de l'instrument, cette valeur

est un peu sous évaluée! Nous avons bien évidemment:

(122)

(122)

donc le processus n'est pas centré (on s'en doutait...). Alors il faut calculer

la capabilité potentielle décentrée moyenne court terme du procédé  selon

les relations déterminées plus haut: selon

les relations déterminées plus haut:

(123)

Bref, que ce soit de la valeur de  , ,  ou ou  ,

nous voyons que les valeurs sont toutes limites capable. ,

nous voyons que les valeurs sont toutes limites capable.

Si nous faisons alors nos calculs de PPM selon les relations obtenues

plus haut avec la valeur de  et

de et

de  obtenues,

nous avons alors: obtenues,

nous avons alors:

(124)

(124)

Ensuite dire ce chiffre est bon ou mauvais cela est difficile car il nous

manque l'information de savoir quel est le coût de production, le coût de revient

et de réparation d'un produit et le tout est lui-même dépendant de la quantité total

fabriquée! Mais nous pouvons utiliser aussi le modèle de Taguchi pour connaître

la valeur des paramètres (moments) calculés qu'il serait préférable de ne pas

dépasser!

Modèle de Taguchi

Dans le cadre des SPC il est intéressant pour un industriel d'estimer les

pertes financières générées par les écarts à la cible (attention on peut appliquer

également cette approche dans d'autres domaines que l'industrie!)

Nous pouvons avoir une estimation relativement simple et satisfaisante de

ses pertes (coûts) sous les hypothèses suivantes:

H1. Le processus est sous contrôle (écart-type constant) et suit une loi

de densité symétrique décroissante à gauche et à droite par rapport à la cible

(qui peut être une côte, un nombre d'erreurs par périodes, etc.)

H2. Le coût est nul lorsque la production (ou le travail) est centrée sur

la cible (minimum).

H3. Le coût augmente de manière identique lorsque la production se décentre

sur la gauche et sur la droite (ce qui n'est plus le cas dans le domaine de

l'administration par exempl). La fonction de coût

passe donc selon H2 et H3 par un minimum sur la cible.

Dès lors, si nous notons Y le décentrage par rapport à la cible T et L la

perte financière ("loss" en anglais d'où le L). Nous avons:

(125)

(125)

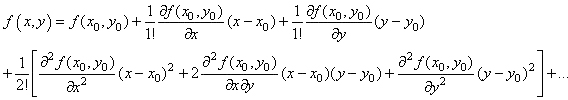

Même si nous ne connaissons pas la forme de cette fonction, nous pouvons

l'écrire sous forme de développement de Taylor autour de T tel que (cf.

chapitre de Suites et Séries):

(126)

(126)

Si nous développons au troisième ordre:

(127)

(127)

Or par l'hypothèse H2, nous avons L(T) qui est nul. Il reste

alors:

(128)

(128)

et comme par H3, la dérivée de la fonction L(Y) est nulle en T puisqu'il

s'agit d'un minimum alors:

(129)

(129)

Ce qui est noté en SPC:

(130)

(130)

et est appelée "fonction de perte de Taguchi" ou

plus simplement "fonction perte de qualité".

Bon c'est bien joli d'avoir cette relation mais comment doit-on l'utiliser?

Au fait, c'est relativement simple. Sous les hypothèses mentionnées plus

haut, si nous avons en production des mesures de défauts (côtes, retards, pannes,

bug, etc.) alors il suffit de calculer leur moyenne arithmétique  (estimateur

de la moyenne d'une loi Normale) et ensuite de savoir le coût financier ou

horaire L que

cela a engendré pour l'entreprise ou l'institution (parfois cette moyenne est

calculée

sur la base d'un unique échantillon...). (estimateur

de la moyenne d'une loi Normale) et ensuite de savoir le coût financier ou

horaire L que

cela a engendré pour l'entreprise ou l'institution (parfois cette moyenne est

calculée

sur la base d'un unique échantillon...).

Donc la relation précédente devient:

(131)

(131)

avec L et  connus. connus.

Et comme T est donné par les exigences du client ou du contexte alors

il est aisé d'obtenir

le facteur k:

(132)

(132)

qui est au fait mathématiquement parlant

le point d'inflexion de la fonction mathématique L .

Cette dernière relation est parfois notée:

(133)

(133)

Une fois que nous avons k avec une bonne estimation, il est possible

de connaître L pour toute valeur Y et ainsi nous pouvons calculer

en production le coût d'une déviation quelconque par rapport à la cible.

Exemple: Exemple:

Considérons une alimentation pour une chaîne stéréo pour laquelle T vaut

110 [V]. Si la tension sort des  alors

la stéréo tombe en panne et doit être réparée. Supposons que le coût de réparation

est (tous frais directs et indirects compris!) de 100.-. Alors le coût associé pour

une valeur donnée

de la tension est: alors

la stéréo tombe en panne et doit être réparée. Supposons que le coût de réparation

est (tous frais directs et indirects compris!) de 100.-. Alors le coût associé pour

une valeur donnée

de la tension est:

(134)

(134)

Voyons maintenant une manière élégante de calculer le coût moyen de Taguchi

(perte unitaire moyenne). Nous avons bien évidemment dans une chaîne de production

sur plusieurs pièces

d'une même famille:

(135)

(135)

où les  sont

des variables aléatoires normales (gaussiennes par hypothèse). Or, nous avons

démontré dans

le chapitre de Statistique lors de notre étude de l'intervalle de confiance

sur la variance avec moyenne empirique connue que: sont

des variables aléatoires normales (gaussiennes par hypothèse). Or, nous avons

démontré dans

le chapitre de Statistique lors de notre étude de l'intervalle de confiance

sur la variance avec moyenne empirique connue que:

(136)

(136)

Donc:

(137)

(137)

Donc:

(138)

(138)

Cette dernière expression présente l'avantage de montrer très

clairement que pour minimiser la perte il faut agir sur la dispersion et l'ajustement

de la moyenne sur la valeur nominale.

Or nous avons démontré que (il est important dans les présents développements

que nous utilisions les notations qui distinguent les différents estimateurs!):

(139)

(139)

Donc:

(140)

(140)

Et si n est grand nous avons alors pour un lot de produits:

(141)

(141)

où le premier terme entre crochets représente donc l'écart-type

de Y autour

de sa propre moyenne et le deuxième terme la déviation de Y par

rapport à la cible T.

MAINTENANCE PRÉVENTIVE

L'évolution des techniques de production vers une plus grande robotisation

des systèmes techniques plus complexes a augmenté l'importance

de la fiabilité des machines de production. Aussi, un arrêt imprévu

coûte cher à une entreprise. De même, dans l'industrie aéronautique

et spatiale, les problèmes de fiabilité, de maintenabilité,

de disponibilité sont capitaux. La maintenance garantit le niveau de

fiabilité pour l'ensemble des composantes (mécaniques, électromécaniques

et informatiques).

L'existence d'un service de maintenance a pour raison le maintien des équipements

(systèmes) et aussi la diminution des pannes. En effet, ces dernières

coûtent cher, elles occasionnent :

- Des coûts d'intervention, de réparation

- Des coûts de non qualité du produit

- Des coûts indirects tels que des frais fixes, pertes de production,

la marge bénéficiaire perdu...

De ce fait, il faut tout mettre en oeuvre pour éviter la panne, agir

rapidement lorsqu'elle survient afin d'augmenter la disponibilité du

matériel. Pour ce faire, il faut modéliser la vie des équipements.

L'ensemble des méthodes et techniques relatives à ses problématiques

sont habituellement classifiées sous le nom de "Analyse

des Modes de Défaillance, des Effets et de leur Criticité" AMDEC.

Nous distinguons principalement deux classes de systèmes: les systèmes

non-réparables (satellites, bien de conommations à faibles coûts,

etc.) et les systèmes réparables (machines de production, moyens

de transports, etc.) où les approches théoriques sont différentes.

Pour la deuxième catégorie il est possible d'utiliser aussi les

chaînes de Markov, les réseaux de Petri ou la simulation par Monte-Carlo.

L'idée est dans les textes qui vont suivre de faire un petit point

sur ces méthodes, d'en rechercher l'efficacité et de permettre

au praticiens ingénieurs ou techniciens de mieux appréhender

ces problèmes. Une large place sera faite au modèle de Weibull

d'application importante dans le domaine.

ESTIMATEURS EMPIRIQUES

Dans le cadre de l'étude de fiabilité non accélérée

(le vieilissement accéléré est un sujet trop complexe

pour être abordé sur ce site), nous sommes amenés à définir

certaines variables dont voici la liste :

- sera

le nombre d'éléments bons à sera

le nombre d'éléments bons à  (instant

initial) (instant

initial)

-  le

nombre d'éléments bons à le

nombre d'éléments bons à

-  le

nombre d'éléments défaillant entre le

nombre d'éléments défaillant entre  et et  noté aussi noté aussi

-  l'intervalle

de temps observé égal à l'intervalle

de temps observé égal à  . .

Définitions:

D1. Nous définissons le "taux de défaillance

par tranche temporelle"  par

la relation : par

la relation :

(142)

(142)

qui s''interprète donc comme étant le % d'éléments

défectueux par rapport au nombre d'éléments survivants

sur une tranche de temps donnée.

Cette dernière relation est aussi parfois appelée "hazard

ratio" (HR) ou

"survie relative".

D2. Nous définissons la "fonction de défaillance" par

la relation (densité de probabilité de défaillances à l'instant  )

: )

:

(143)

(143)

en remarquant bien que le dénominateur n'est pas le même que

celui qui définit la taux de défaillance par tranche!

Cette fonction s'interprète donc comme étant le % d'éléments

défectueux dans la tranche de temps étudiée par rapport

au nombre total d'éléments initialement testés. Il s'agit

de l'indicateur qui intéresse le plus souvent l'ingénieur!

D3. Nous définissons naturellement la "fonction

de défaillance cumulée" par :

(144)

(144)

que tend vers 1 lorsque le temps tend vers l'infini.

Cette fonction s'interprète donc comme étant le % d'éléments

défectueux cumulé par rapport au nombre total d'éléments

initialement testés.

D4. Nous définissons in extenso la "fonction

de fiabilité" par (il s'agit du deuxième terme de la

précèdente relation):

(145)

(145)

Son nom provient par l'interpratition du rapport dans le cadre de la définition

de la fonction de défaillance cumulée.

Pour se rappeler des termes se souvenir que R provient de l'anglais "reliability" qui

signifie "fiabilité" alors que le F en anglais signifie "failure" qui

signifie en "panne".

Par suite nous avons aussi:

(146)

(146)

Cette dernière relation servant au calcul des lois de fiabilité!

Puisque :

et et  (147)

(147)

la fonction de défaillance peut être vue comme une probabilité ce

qui nous amène à définir naturellement son espérance

:

(148)

(148)

Relation très utile dans la pratique qui donne en théorie le

pourcentage moyen d'éléments en panne à l'instant  . .

Exemple: Exemple:

Nous avons relevé sur un lot de 37 moteurs d'un type donné les

défaillances suivantes répertoriées par tranches (données

par des clients ou mesuré en internes sur des bancs d'essais):

|

0 à

1'000 h.

|

1'000 à 2'000 h.

|

2'000 à

3'000 h.

|

3'000 à

4'000 h.

|

4'000 à

5'000 h.

|

5'000 à 6'000 h.

|

|

1 |

4 |

7 |

12 |

11 |

2 |

Tableau: 6

- Défaillances des moteurs par tranches d'effort

Il faut que nous estimions la valeur de la fonction de fiabilité  ,

la fonction de défaillance ,

la fonction de défaillance  et

la défaillance par tranche et

la défaillance par tranche  .

Les calculs sont élémentaires et nous obtenons le tableau suivant

: .

Les calculs sont élémentaires et nous obtenons le tableau suivant

:

|

Intervalle

d'observation |

Nombre de

défaillances dans l'intervalle |

Survivants |

Cumul des

défaillants |

|

|

|

|

0 |

- |

37 |

0 |

100% |

0 |

- |

0 à

1'000 h. |

1 |

36 |

1 |

97% |

2.7% |

27 |

1'000 à

2'000 h. |

4 |

32 |

5 |

86% |

10.8% |

111 |

2'000 à

3'000 h. |

7 |

25 |

12 |

67% |

18.9% |

218 |

| 3'000 à 4'000 h. |

12 |

13 |

24 |

35.1% |

32.4% |

480 |

| 4'000 à 5'000 h. |

11 |

2 |

35 |

5.4% |

5.4% |

846 |

5'000 à

6'000 h. |

2 |

0 |

37 |

0% |

- |

1 |

Tableau: 7

- Analyse des défaillances des moteurs par tranches d'effort

Nous voyons ci-dessus par exemple que le taux de défaillance n'est

pas constant bien évidemment!

Concernant les taux de défaillance, les ingénieurs reconnaissent souvent

trois tranches d'analyses suivant que certains objets étudiés soient jeunes,

en fonctionnement normal ou considérés en vieillissement.

On considère alors assez intuitivement (et parfois grossièrement) que le

taux de défaillance suit une courbe en baignoire comme représenté ci-dessous

(dans les tables techniques c'est souvent le taux de défaillance en fonctionnement

normal qui est donné):

(149)

alors que si vous observez le tableau précédent, le taux de

défaillance

ne suit pas du tout une courbe en baignoire (c'est donc un contre-exemple).

Les ingénieurs en fiabilité découpent souvent la baignoire en trois parties

visibles ci-dessus mais sous la dénomination technique suivante:

- D.F.R.: Decreasing Failure Rate (les composants jeune ayant des problèmes

de fabrication non identifiés lors de procédé sont éliminés

du lot ce qui a pour effet de diminuer le taux de défaillance). La loi

de Weibull est relativement bien adaptée pour modéliser cette phase.

- C.F.R.: Constant Failure Rate (les composants sont dans un état

stationnaire). La loi de Poisson est relativement bien adaptée pour

modéliser

les arrivées de pannes, et la loi exponentielle pour modéliser

le temps entre pannes successives..

- I.F.R.: Increasing Failure Rate (les composants sont en fin de vie et leur

taux de défaillance augmente). La loi de Weibulle est à nouveau relativement

bien adaptée pour modéliser cette phase.

Remarque: Contrairement

à ce que pas mal de théoriciens pensent..., les logiciels informatiques grand

public ont aussi leur taux de défaillance qui suit une courbe en baignoire. Effectivement,

au début il y a des bugs non détectés qui font que la défaillance va diminuer

au fur et à mesure de leur détection et leur correction. Ensuite,

à

cause

des mises-à-jour fréquentes de l'environnement qui ont tendance à rajouter

d'autres problèmes (service pack), le taux de défaillance se maintient à peu

près constant. Enfin, avec le temps, l'évolution des

technologies

environnantes (framwork) rendent l'applicatif obsolète et des fonctions ne

répondent ou n'agissent plus correctement ce qui fait à nouveau augmenter le

taux de défaillance.

Vis-à-vis de l'efficacité de la rénovation, indiquons qu'elles peuvent (en

simplifiant) très fréquemment se ranger en trois catégories:

1. As good as new: C'est de la maintenance préventive dans le sens que nous

changeons une pièce lorsque sa durée de vie l'amène à une taux de défaillance

que nous considérons comme trop élevé et dont la rupture non anticipée coûtera

plus cher que sa non-anticipation.

2. As bad as old: C'est de la maintenance déficiente dans le sens que nous

changeons une pièce que lorsqu'elle est arrivée à rupture ce qui engendre majoritairement

des coûts d'arrêts plus élevés que la maintenance préventive qui consiste elle à anticiper

au plus juste la casse.

3. Restauration partielle: C'est de la maintenance préventive minimale dans

les sens que nous réparons la pièce défaillante plutôt que de la remplacer

par une nouvelle. A nouveau le problème du coût doit être calculé en faisant

un audit des besoins et des délais de l'entreprise.

Revenons en à d'autres définitions au passage à la limite

du continu.

Nous savons donc que le "taux de défaillance instantané" aura

pour unité l'inverse du temps tel que  .

Ce taux est dans le cadre de notre étude pas nécessairement constant dans le

temps nous l'avons constaté! .

Ce taux est dans le cadre de notre étude pas nécessairement constant dans le

temps nous l'avons constaté!

Soit R(t) le pourcentage cumulé d'objets analysés

toujours en état de bon fonctionnement d'un échantillon testé au temps t.

Le nombre d'objets tombant en panne durant le temps infinitésimal dt est

donc égal à :

(150)

(150)

ce qui correspond donc à la diminution du stock initial en bon fonctionnement

au temps t.

Nous pouvons alors écrire la relation:

(151)

(151)

soit :

(152)

(152)

Définition: La "probabilité conditionnelle

de défaillance" (rien à voir avec les probabilités

conditionnelles cependant....) entre t et t + dt est

définie par:

(153)

(153)

où F(t) et R(t) sont respectivement

la fonction cumulée de défaillance (probabilité cumulée

de tomber en panne au temps t) et la fonction fiabilité appelée également "fonction

de survie". R(t) valant 1 au temps 0 et... 0

après